《Video Mamba Suite》论文笔记(1)Mamba在时序建模中的作用

原文链接

https://arxiv.org/abs/2403.09626![]() https://arxiv.org/abs/2403.09626

https://arxiv.org/abs/2403.09626

原文代码

https://github.com/OpenGVLab/video-mamba-suite![]() https://github.com/OpenGVLab/video-mamba-suite

https://github.com/OpenGVLab/video-mamba-suite

原文笔记

What

《Video Mamba Suite: State Space Model as a Versatile Alternative for Video Understanding》

为了评估 Mamba 是否可以成为视频理解领域中 Transformer 的可行替代方案,在这项工作中,我们进行了一组全面的研究,探索 Mamba 在视频建模中可以扮演的不同角色,同时研究 Mamba 可能展现出良好性能的不同任务。

为了实现这一目标,我们探索了曼巴在理解视频中可能扮演的不同角色,以及调查曼巴可能表现出优势的各种任务。我们将 Mamba 分为四个角色来对视频进行建模:(1) temporal model, 2) temporal module, 3) multi-modal interaction network, and 4) spatial-temporal model. )

我们将 Mamba 分为四个角色来对视频进行建模,推导出一个由 14 个模型/模块组成的Video Mamba Suite,并在 12 个视频理解任务上对其进行评估。我们广泛的实验揭示了 Mamba 在纯视频和视频语言任务上的强大潜力,同时显示出有希望的效率-性能权衡。

PS:这篇文章是一篇以实验为主体推动的文章,他每章的命名都与传统CV论文或者Mamba论文不同,他将Mamba应用到很多Video领域,覆盖面很光,等于为很多视频研究领域提供了预训练和baseline,在实验中他提出了一个新的Mamba块DBM从作者给出的结果来看结果是很好的,这篇论文推荐看原文代码:https://github.com/OpenGVLab/video-mamba-suite![]() https://github.com/OpenGVLab/video-mamba-suite

https://github.com/OpenGVLab/video-mamba-suite

这篇文章比较长,本来想看完自己的部分就结束了

但是为了丰富自己的视野和帮助万一有需要的人于是完整翻译将在下几篇中给出

《Video Mamba Suite》论文笔记(2)Mamba对于多模态交互的作用-CSDN博客

《Video Mamba Suite》论文笔记(3)Mamba作为时序适配器的作用-CSDN博客

《Video Mamba Suite》论文笔记(4)Mamba在时空建模中的作用-CSDN博客

Why

现有的Video UnderStaning工作可以被分为三类

1:时空分离建模 - frame-based feature encoding + RNN/GRU/LSTM(cannot capture joint spatiotemporal information)

2:时空合并建模 - C3D(效果不如3好,因为使用的是static local operators,说的就是卷积神经网络的卷积核是固定的,所以缺乏一些动态处理能力)

3:时空合并建模 -Transformers(计算开销太大,“由于长视频中Vision Transformer的计算效率有限”)

为了评估 Mamba 是否可以成为视频理解领域中 Transformer 的可行替代方案,在这项工作中,我们进行了一组全面的研究,探索 Mamba 在视频建模中可以扮演的不同角色,同时研究 Mamba 可能展现出良好性能的不同任务。

Challenge

Idea

我们将 Mamba 分为四个角色来对视频进行建模,推导出一个由 14 个模型/模块组成的Video Mamba Suite,并在 12 个视频理解任务上对其进行评估。我们广泛的实验揭示了 Mamba 在纯视频和视频语言任务上的强大潜力,同时显示出有希望的效率-性能权衡。

原文翻译

Abstract

理解视频是计算机视觉研究的基本方向之一,在大量致力于探索 RNN、3D CNN 和 Transformer 等各种架构的工作的努力下。新提出的状态空间模型架构,例如 Mamba,展现出了其能够将长序列建模方面的成功扩展到视频建模领域的良好特性。为了评估 Mamba 是否可以成为视频理解领域中 Transformer 的可行替代方案,在这项工作中,我们进行了一组全面的研究,探索 Mamba 在视频建模中可以扮演的不同角色,同时研究 Mamba 可能展现出良好性能的不同任务。我们将 Mamba 分为四个角色来对视频进行建模,推导出一个由 14 个模型/模块组成的Video Mamba Suite,并在 12 个视频理解任务上对其进行评估。我们广泛的实验揭示了 Mamba 在纯视频和视频语言任务上的强大潜力,同时显示出有希望的效率-性能权衡。我们希望这项工作能够为未来视频理解研究提供有价值的数据点和见解。代码是公开的:https://github.com/OpenGVLab/video-mamba-suite。

Keywords:Video Understanding· State Space Model · Mamba

1 Introduction

视频理解是计算机视觉研究中的一个基本问题,它需要从视频中捕捉时空动态来定位活动或推断其演变。目前对视频理解架构的探索可以分为三类。第一类工作采用基于框架的特征编码,然后通过循环网络(如GRU和LSTM)进行时间依赖性建模。由于这种类型的分割时空建模不能捕获联合时空信息,另一种工作使用卷积神经网络中的3D核同时考虑空间和时间相关性[25,73]。

继Transformer模型在语言和图片的处理上取得了巨大成功之后,video transformers在视频理解领域也取得了长足的进步,Video transformer表现出比RNN和3D-CNN更强的能力。Video Transformers将视频封装在一系列tokens中,注意力机制可以实现全局上下文交互和数据依赖的动态计算。因此,该模型擅长以统一的方式处理视频中的时间[10,78,89,90]或时空[6,68]信息。由于长视频中视频变压器的计算效率有限,出现了几种变体[2,6,20,55],以平衡速度性能的权衡。

近年来,状态空间模型(ssm)在自然语言处理(NLP)中显示出其优势。现代ssm[32]在NLP中表现出强大的表征能力,特别是在长序列建模中,同时保持线性时间复杂度。这是因为它们的选择机制可以消除存储完整上下文的需要。值得注意的是,Mamba[30]将时变参数纳入SSM,并提出了一种硬件感知算法,以实现高效的训练和推理。Mamba令人印象深刻的缩放性能表明它是一个有前途的Transformer的替代品。同时,Mamba强大的性能和效率使其非常适合视频理解任务。然而,尽管一些初步尝试探索如何将Mamba应用于图像建模[53,96],但其在视频理解中的有效性仍不清楚。缺乏对曼巴在视频理解方面的潜力的全面研究,阻碍了对其在各种视频相关任务中的能力的进一步探索。

在本文中,我们没有提出一种新的方法。相反,我们对SSM(以Mamba模型作为代表)在视频理解背景下的潜力进行了广泛的调查。我们的目标是评估Mamba在这个领域是否可以成为Transformers的可行替代品。为了实现这一目标,我们探索了曼巴在理解视频中可能扮演的不同角色,以及调查曼巴可能表现出优势的各种任务。我们将 Mamba 分为四个角色来对视频进行建模:(1) temporal model, 2) temporal module, 3) multi-modal interaction network, and 4) spatial-temporal model. )1)时间模型,2)时间模块,3)多模态交互网络,4)时空模型。对于每个角色,我们研究了它在不同视频理解任务上的视频建模能力。为了确保与Transformers进行公平比较,我们仔细选择了基于标准或改进的变压器架构的对应模型。我们的探索派生了一个视频 Mamba Suite,其中包含 14 个模型/模块,用于 12 个视频理解任务。我们希望我们的视频 Mamba Suite 可以作为未来在视频理解领域探索基于 SSM 的模型的宝贵资源。

2 Related Work

2.1 Video Modeling

视频建模是实现深度视频理解的基石,并且随着时间的推移经历了重大的发展。最初,TSN[82]采用统一的视频采样,并利用二维网络[35,40]建立多帧共识来生成视频表示。在那之后,视频卷积网络取得了实质性进展。[48,75,81]等方法侧重于将时间模块集成到二维网络中以促进时空建模。相反,[9,25,60,73,74,87]等方法要么增强2D卷积网络的核[35,40,86],要么从头开始训练3D卷积网络以提取时空特征。

然而,卷积网络受其依赖静态局部算子的限制,导致其表示能力有限。受到language transformers[8,17,62,63,70]和image transformers[11,18,20,34,54,69,84]有效性的启发,研究人员研究了Video Transformers的各种结构[2,6,45,55]。值得注意的是,结合时空联合注意的video transformer在这些结构中表现出优越的能力。因此,随后的研究工作[24,46,68,80,85]深入研究了基于这种结构的不同预训练方法。然而,与联合注意力相关的二次计算复杂性构成了一个重大障碍,阻碍了视频转换器处理更长的上下文的可扩展性,这与LLMs(Large language models)面临的问题相似[71,72]。一些研究已经开发了基于Transformer的变体[2,6,55],专门用于建模通常超过128帧的长视频。

或者,另一种方法是设计具有线性复杂度的模型架构。例如,RetNet[67]和RWKV[59]利用指数衰减技术来捕获全局信息。状态空间模型[31-33]还提供了线性复杂度,Mamba[30]采用高效的实现来促进数据相关的推理。在视觉领域,一些作品 [1, 19, 96] 探索了具有线性复杂度的视觉编码器。XCiT [1] 通过计算输入标记之间的交叉方差实现了与线性复杂度的全局交互。最近,[53,96] 对基于 Mamba 的视觉应用进行了初步探索。在这项研究中,我们研究了创建一个基于 Mamba 的视频模型以进行视频理解。

2.2 State-Space Models(SSMs)

作为状态空间模型(SSMs)时代的前跑者,[32]引入了一种新的模型,称为结构化状态空间序列(S4),它为cnn和变压器提供了捕获远程依赖的替代方案。S4 模型展示了序列长度线性缩放的一个有前途的特征。在此基础上,[65]提出了一种称为S5的高级层,它将MIMO SSM与高效的并行扫描集成到S4架构中。该开发旨在克服 SSM 的约束,提高其有效性。此外,[26] 贡献了一种新颖的 SSM 层 H3,显着缩小了 SSM 和基于Transformer的注意力在语言建模中的性能差距。[57] 通过在门控状态空间层中引入额外的门控单元来扩展 S4 模型,以增强其表现力。最近,[30] 引入了一个依赖于数据的 SSM 层,并开发了一个名为 Mamba 的通用语言模型。Mamba 在不同大小的大规模真实数据上的性能上优于Transformer,并展示了序列长度的线性缩放。在这项研究中,我们的目标是将 Mamba 在语言领域的成功扩展到视频理解。具体来说,我们构建了一个通用的框架,称为 Video Mamba Suite ,用于开发、验证和分析 Mamba 在视频理解方面的性能。

只有有限的工作使用SSM进行视频理解,而这些工作主要关注长期视频分类[41,79]。[41]扩展了S4架构,并将多尺度时间S4解码器纳入视频序列分类。[79]引入了一个掩码对比学习框架来增强状态空间模型。我们的研究将 SSM 的应用范围扩展到更广泛的视频理解任务。我们以 Mamba [30] 为例,涵盖了 SSM的多个用法 和更多与视频相关的任务,超越了只关注长视频的分类这项任务。

3 Preliminaries

3.1 State Space Model

在本节中,我们将介绍基于结构化状态空间 (SSM) 的模型,特别是 S4 [32] 和 Mamba [30] 模型。这些模型从处理序列或函数的连续系统中汲取灵感。假设一个系统随着时间的推移接受一系列输入 x(t),并产生一系列输出 y(t),同时通过隐藏状态 h(t) 转换输入。

该系统使用矩阵 A^N×N 来定义隐藏状态的演变,B^N×1 和 C^1×N 分别将输入和隐藏状态投影到输出。这个过程可以概括为 h′(t) = Ah(t) + Bx(t), y(t) = Ch(t)。

S4 和 Mamba 被设计为这些连续系统的离散等价形式。它们包含一个时间尺度参数 Δ,将连续参数 (A, B) 转换为它们的离散参数 (A拔, B拔)。转换使用 zero-order hold技术,得到离散公式,A拔 = exp(∆A), B拔 = (∆A)^−1(exp(∆A)−I)·∆B。一旦参数被离散化,在每个离散时间步t的系统行为如下所示:ht = A拔ht−1 + B拔xt, yt = Cht,该公式展现了隐藏状态是如何更新和产生输出的

最后,输出是通过全局卷积过程计算的,涉及结构化卷积核![]() 。

。

该内核由转换后的投影参数构造并应用于整个输入序列 x 以产生最终输出序列 y,即 y = x * K。这里,M 是输入序列 x 的长度。通过将连续动态转换为离散步骤,S4 和 Mamba 模型允许处理具有复杂依赖关系的序列。

3.2 Mamba Block

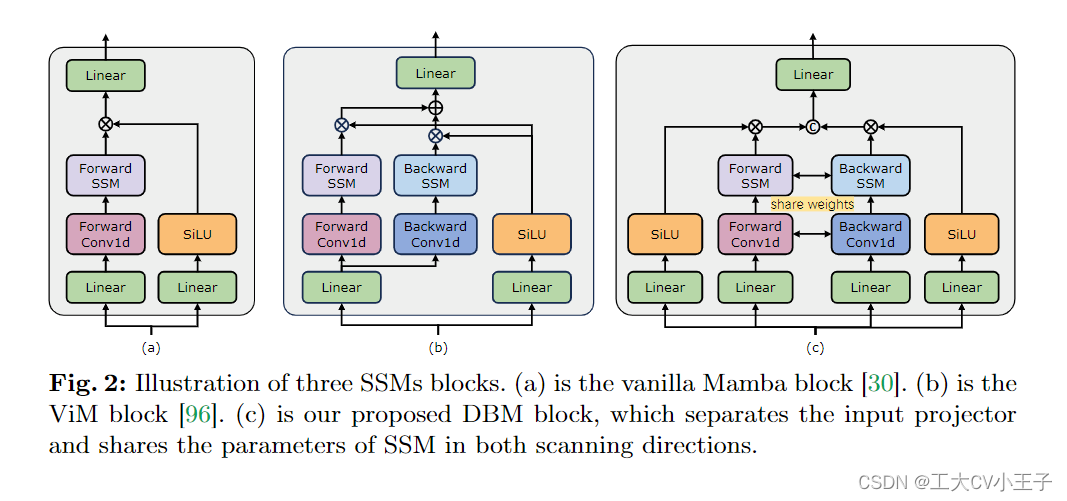

Mamba块[30]结合了线性注意算子和MLP块,灵感来自门控注意单元(GAU)[38],如图2(A)所示。该架构涉及通过可控扩展因子 E 扩展模型维度 D。对于每个块,大部分参数 (3ED2) 都在线性投影 层(2ED2 用于输入投影,ED2 用于输出投影),而内部 SSM 的贡献较小。相比之下,SSM 参数的数量(Δ、B、C 和矩阵 A 它们的投影的参数总量)要小得多。

3.3 Vim Block

ViM 块 [96],如图 2 (b) 所示,在 Mamba 块中添加了一个带有附加参数的后向选择性扫描分支。在此基础上,两个扫描方向的特征共享相同的线性投影和门控层。给定输入 x,对于每个方向,ViM 块首先将一维卷积应用于输入 x 并获得 x′o。然后块分别线性投影 x′o 到 Bo、Co、Δo。然后使用 Δo 分别变换 Ao拔 和 Bo拔。接下来,SSM 计算前向扫描特征 yf 和后向扫描特征 yb。最后,这两个特征都由门控层门控并取平均值以获得输出标记序列(output token sequence)。

3.4 DBM Block

我们进一步研究了一种分解的双向 Mamba 块,表示为 DBM,如图 2 (c) 所示。与 ViM 块相比,它采用逆设计。给定输入序列 x,DBM 块最初使用不同的线性层来分离前向特征 xf 和后向特征 xb。然后将这些特征通过具有共享参数的SSM模块进行双向扫描,得到x 'f和x 'b。随后,这两个特征在连接以生成输出标记序列之前经过两个不同的层进行门控操作。这个块引入了方向偏差并削弱了特定的动态。在我们在第 4.1 节中详述的实验中,我们观察到 DBM 块在小规模数据集上的性能有所提高。

4 Video Mamba Suite

在本节中,我们将介绍 Video Mamba Suite ,其中包含各种基于 Mamba 的模型,用于一组不同的视频理解任务。该套件以四个不同的角色利用 Mamba:时间模型、时间模块、多模态交互模型和时空序列模型。每个角色将在以下各小节中讨论,逐渐揭示 Mamba 在视频理解方面的性能并突出其关键特征。由于空间限制,补充材料中提供了更多的实现细节和实验结果。

4.1 Mamba for Video Temporal Modeling

Tasks and datasets.我们评估了 Mamba 在五个视频时间任务上的性能:时间动作定位 (HACS Segment [91])、时间动作分割(GTEA [22])、密集视频描述(ActivityNet [36], YouCook [95])、视频片段描述(ActivityNet [36], YouCook [95])和动作预期(Epic-Kitchen-100 [13])。

Baseline and competitor.我们选择基于Transformer的对应模型作为每个任务的基线。具体来说,Transformer基线是ActionFormer[90]、ASFormer[89]、Testra[92]和PDVC[83]。为了构建 Mamba 挑战者,我们将基线模型的变换器块替换为基于 Mamba 的块,包括 vanilla Mamba [30]、ViM [96] 和我们的 DBM。请注意,在涉及因果推理的动作预期的上下文中,我们将基线的性能与普通 Mamba 块 [30] 进行比较。

Results and analysis.

我们在表 1 和表 5 中展示了四个任务的不同模型的比较结果。总体而言,虽然一些基于Transformer的模型已经结合了注意力变体来提高性能,但与 Transformer 系列中现有方法相比,该表展示了 Mamba 系列的卓越性能。

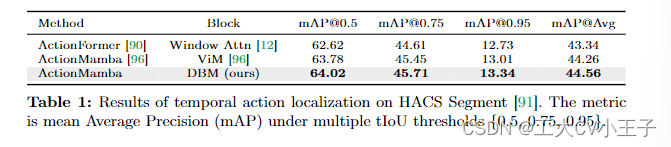

时间动作定位。 如表 1 所示,我们引入了 ActionMamba,它将 ActionFormer [90] 的 Transformer 块更改为 ViM 块,在 HACS 段数据集上实现了 44.26 的平均 mAP。使用我们的 DBM 块,ActionMamba 可以进一步提高平均 mAP 到 44.56。这显着优于其Transformer对应模型 1.22(44.56 对 43.34)。

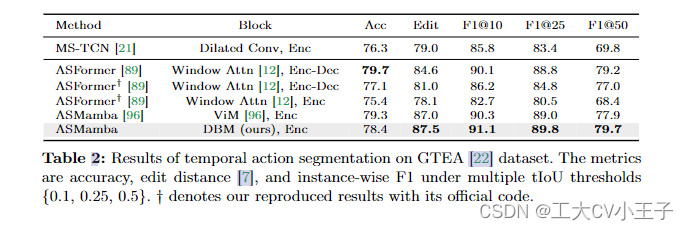

时间动作分割。表 2 报告了时间动作分割的结果。与我们复制的 ASFormer [89] 相比,我们提出的 ASamba 表现出更好的性能。由于 ASamba 是一个纯编码器,而 ASFormer 采用编码器-解码器结构,我们还尝试了 ASFormer 的编码器版本,其中观察到性能下降。结果表明,与 Transformer 相比,Mamba 的巨大潜力。

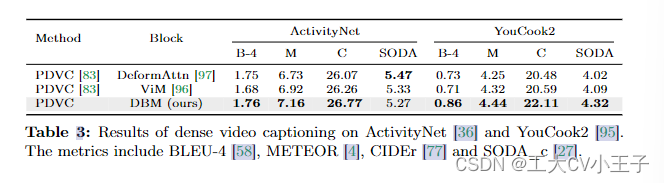

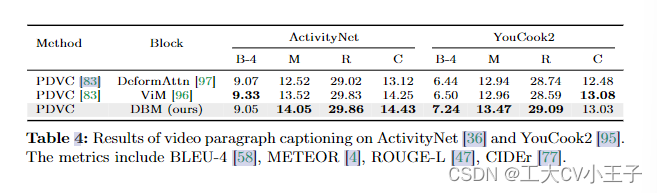

密集的视频字幕。表 3 显示了密集视频字幕的结果。基线 PDVC 模型 [83] 采用Deformable Transformer 对视觉信息进行编码。相比之下,我们的带有 DBM 块的双向 Mamba 在时间事件定位和字幕生成方面表现出更强的性能。

视频段落字幕。表 4 展示了视频段落字幕的结果比较。我们还采用 PDVC 作为基线模型 [83],仅使用字幕损失训练模型。与字幕和定位都至关重要的密集视频字幕任务不同,视频字幕只专注于提取细粒度的视觉信息来生成字幕。表 4 中的结果表明,与时间可变形编码器相比,我们的双向 Mamba 为字幕带来了更强的特征表示。

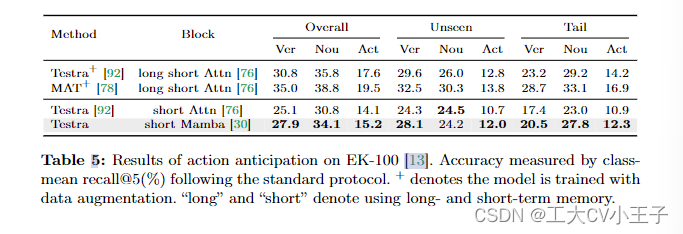

行动预期。我们通过动作预期任务进一步评估了 Mamba 在因果建模方面的能力。通过将 5 秒时间特征作为输入,我们将拥有因果自注意力块的Testra [92]和因果 Mamba [30] 块进行比较。如表 5 所示,结果证明了 Mamba 优越的因果推理能力,这与表 4 文本生成的结论一致。

由于本人研究内容为dence video captioning,所以理应读到这里就结束了

但是为了文章的完整性 余下翻译将在下几篇给出

《Video Mamba Suite》论文笔记(2)Mamba对于多模态交互的作用-CSDN博客

《Video Mamba Suite》论文笔记(3)Mamba作为时序适配器的作用-CSDN博客

《Video Mamba Suite》论文笔记(4)Mamba在时空建模中的作用-CSDN博客

原文地址:https://blog.csdn.net/Zssss12/article/details/138391646

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!