神经网络模型底层原理与实现9-可解释性

必要性:在金融、医药、自动驾驶方面,模型必须可解释,知道分类错在哪才可以更好的改进模型

解释的两类方法:

1.找出为什么模型认为图片是一只猫的原因

具体操作:a.把图片中的一部分删掉,如果分类错了很多,可得这一部分对分类是很重要的

b.数值表达形式:给输入一个dx,看输出dy与它的比值大小来确定这部分输入对分类结果的重要性

举个例子:左边这张图,人眼判断这是不是马可能是靠看这匹马,而机器判断是靠左下角的字,这样就不对了

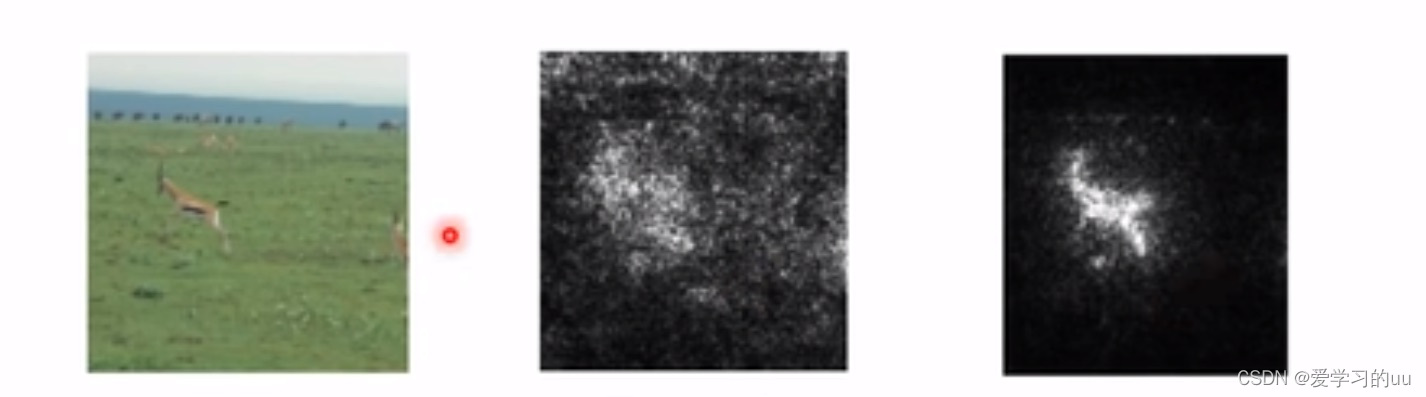

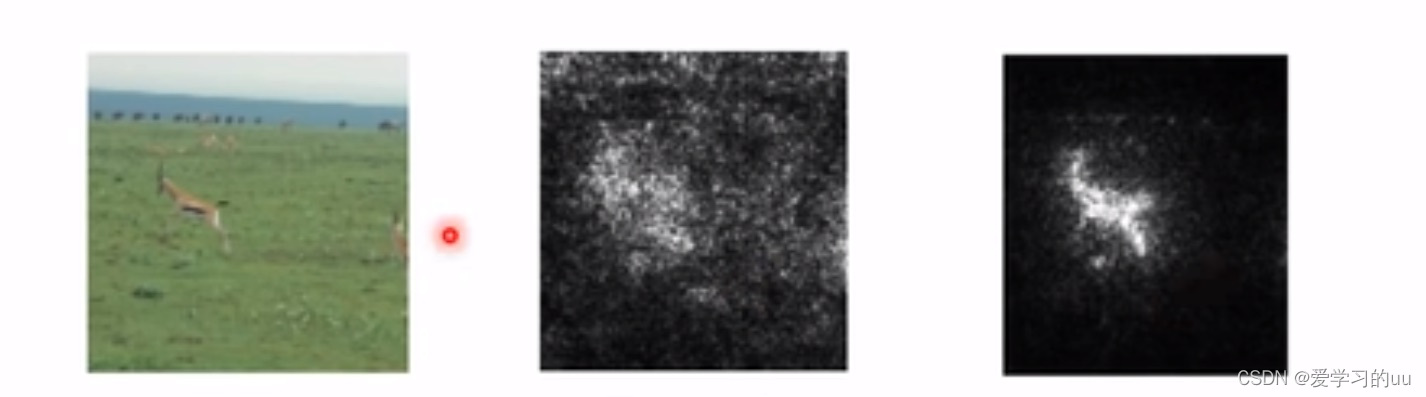

那如何在梯度图中去掉一些不重要的点:直接在原图中加入噪音,这样梯度图中零散的点就会消失(如第三张图)

c.在深度学习中,还可以把中间几层的结果抽出来,用PCA等方法降纬,看特征是什么

2.根据模型参数得出一只猫长啥样

方法:生成一张图使得经过一层后,左下角这个式子值尽可能大(方法和梯度下降法一致,只是取反方向)

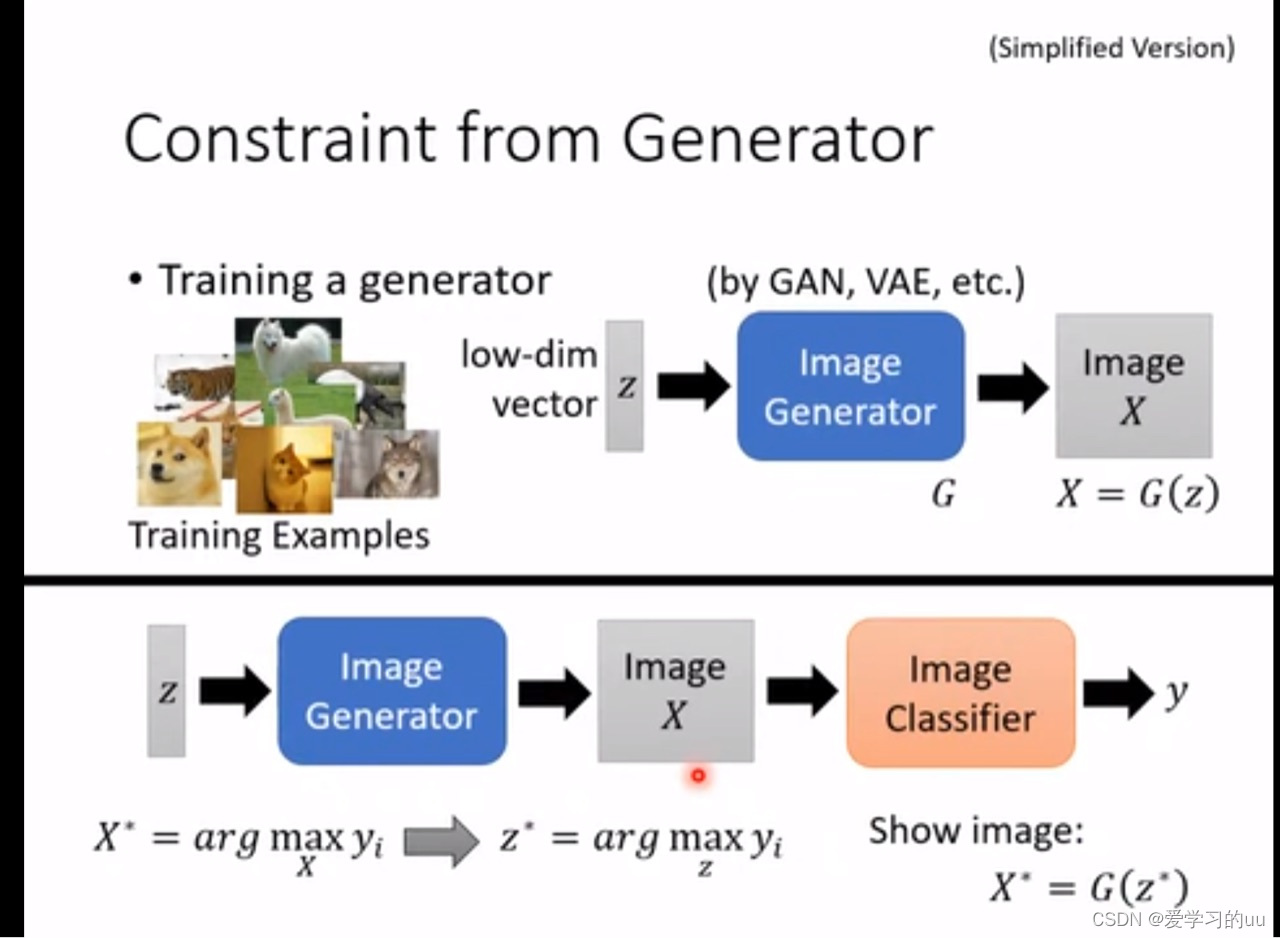

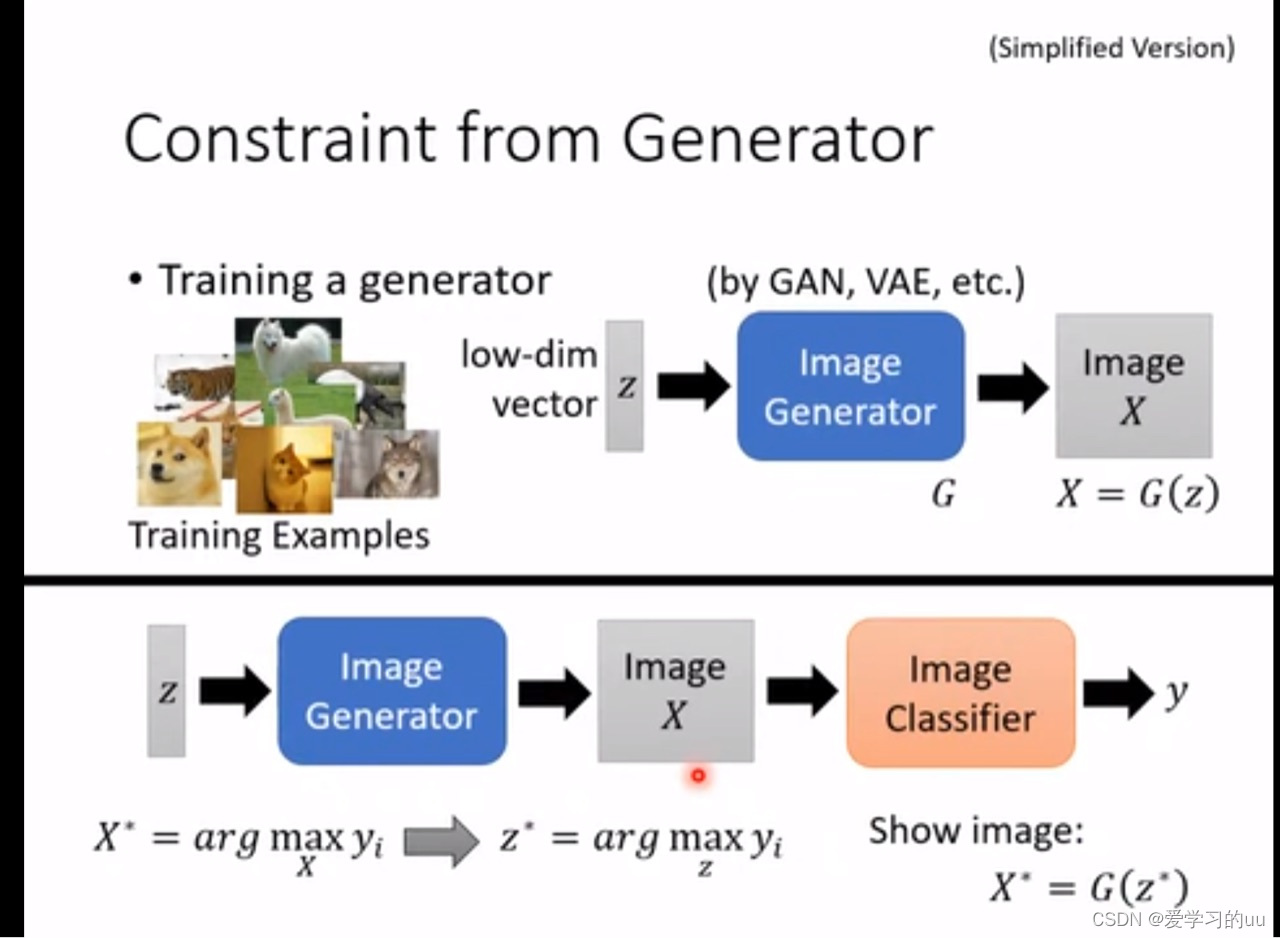

具体实现中可使用GAN:把原始图片输入(作为z),训练image generator,使其可以根据目标产生X,再通过分类器得类别y

3.其他方法:用一个可解释的模型(比如树)来替代深度学习模型的效果(可以只模仿一小个区域内的效果,整体模仿树模型可能做不到

原文地址:https://blog.csdn.net/m0_60792028/article/details/137668384

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!

-

【第34章】Spring Cloud之SkyWalking分布式日志

前面已经完成了请求的链路追踪,这里我们通过SkyWalking来处理分布式日志;场景描述:我们有三个服务消费者,提供者和用户服务,三个服务都有自己的日志文件,但是我一个请求会贯穿三个服务,不能说我一个

阅读更多2024-09-21

-

C++模板初阶

在之前的代码实现当中当我们要让一个函数能处理不同类型的数据时就只能使用函数重载,并且在此数据的类型还必须是我们重载的函数内拥有的,否则就无法实现。在之前实现顺序表、链表等数据结构时我们使用的是type

阅读更多2024-09-21

-

探索IT世界:从技术基础到职业发展

信息技术(IT)已经深深融入我们的日常生活,成为全球各行各业的核心力量。无论是智能手机应用、网络服务,还是企业的大型系统,IT技术无处不在。如果你是初学者,想要了解IT行业的广度和深度,那么这篇文章将

阅读更多2024-09-21

-

SQL 语法学习:深入了解与大数据处理的桥梁

SQL 是用于管理和操作关系型数据库的标准语言。它主要用于查询、插入、更新、删除数据库中的数据,并管理数据库的表结构等。SQL 最初由IBM公司开发,之后逐渐演变成了各大数据库管理系统(如MySQL、

阅读更多2024-09-21

-

Vue 项目中引入 Axios 详解

在 Vue 项目中,`axios` 是一个非常流行的 HTTP 客户端,用于向服务器发送请求并处理响应。本文将详细说明如何在 Vue 项目中引入 Axios 插件,以及如何进行基本的配置,包括构建、配

阅读更多2024-09-21

-

go 实现操作mysql并且防止sql注入

在最近使用go语言的同学,大家有没有操作数据库的时候遇到过sql注入的问题,sql注入会把数据库搞崩,或者是把数据库的数据全部查出造成不必要的随时,今天小程同学就给大家带来一个go中防sql注入的最好

阅读更多2024-09-21

-

Python学习

1.计算机的作用是计算,编程的目的为了更方便的计算,计算的对象是数据2.变量是程序在运行过程中临时用于储存数据的东西。

阅读更多2024-09-21

-

【RabbitMQ】应用

P: ⽣产者, 也就是要发送消息的程序C: 消费者,消息的接收者Queue: 消息队列, 图中⻩⾊背景部分. 类似⼀个邮箱, 可以缓存消息;

阅读更多2024-09-21

-

鹏哥C语言39---分支/循环语句练习:猜数字游戏

/---------------------------------------------------------------------------------------------------

阅读更多2024-09-21

-

自然语言处理-基于注意力机制的文本匹配

任务三:基于注意力机制的文本匹配输入两个句子判断,判断它们之间的关系。参考(可以只用LSTM,忽略Tree-LSTM),用双向的注意力机制实现。参考》 第7章实现要求:Pytorch知识点:注意力机制

阅读更多2024-09-21