李沐动手学习深度学习——4.1练习

1. 计算pReLU激活函数的导数。

pReLU激活函数公式根据课本有如下:

p

R

e

L

U

(

x

)

=

max

(

0

,

x

)

+

α

min

(

0

,

x

)

\mathrm{pReLU}(x) =\max(0, x)+\alpha \min(0,x)

pReLU(x)=max(0,x)+αmin(0,x)

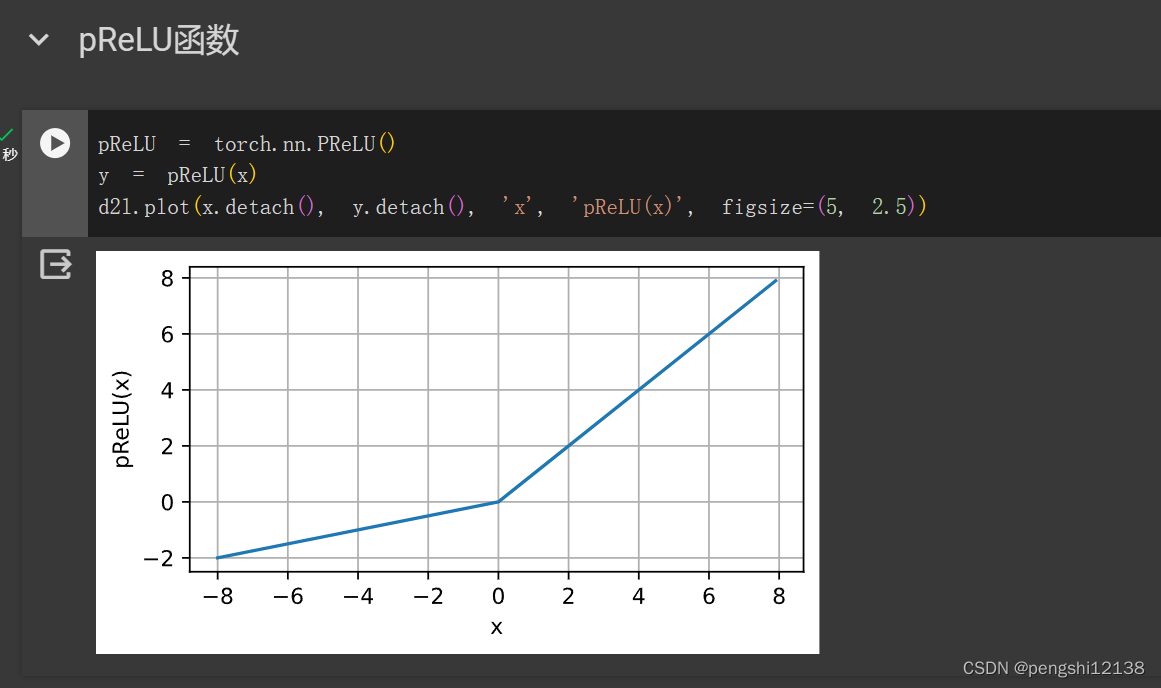

对应的函数图像为:

对应的导数计算为:

d

p

R

e

L

U

d

x

=

{

1

,

x

≥

1

α

,

x

<

1

\frac{\mathrm{d} \mathrm{pReLU}}{\mathrm{d} x} =\left \{ \begin{array}{ll} 1,& x\ge1\\ \alpha ,& x<1 \end{array} \right.

dxdpReLU={1,α,x≥1x<1

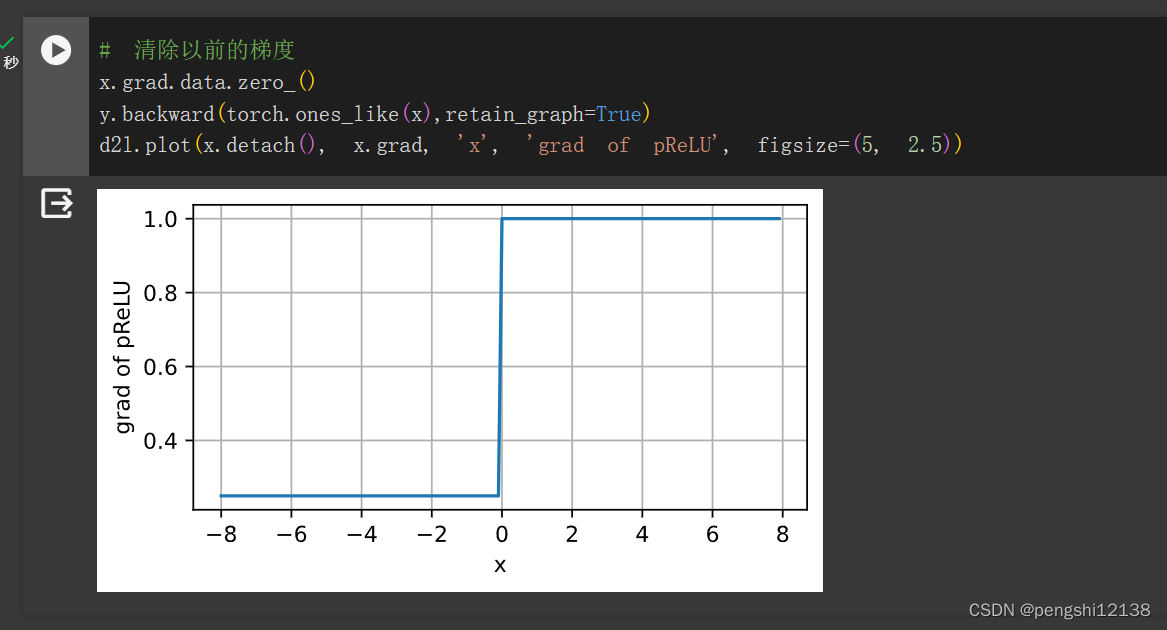

对应的梯度图像如下:

2. 证明一个仅使用ReLU(或pReLU)的多层感知机构造了一个连续的分段线性函数

- 单个ReLU构成的多层感知机是分段线性函数

- 同层多个组合ReLU构成的多层感知机同样是分段线性函数

- 多层多个组合ReLU函数构成的多层感知机,具有多个维度,同样也是分段函数

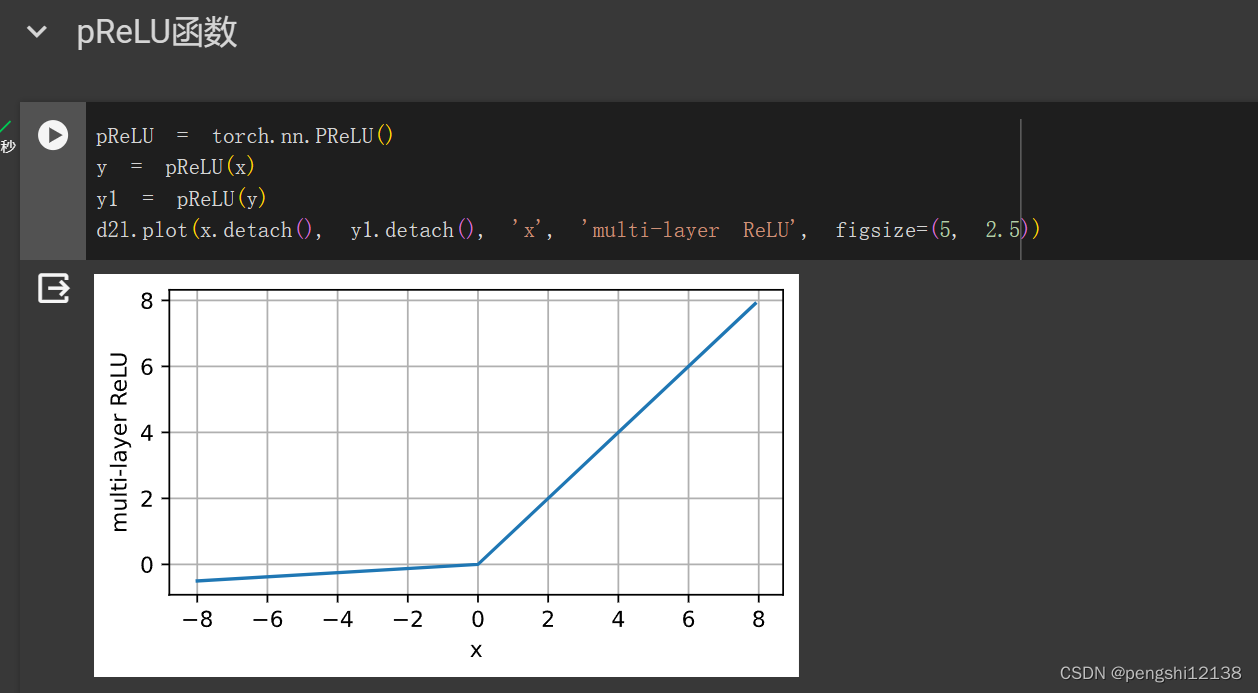

叠加两层的ReLU函数如图下,以此类推。

3. 证明

t a n h ( x ) + 1 = 1 − exp ( − 2 x ) 1 + exp ( − 2 x ) + 1 = 2 1 + exp ( − 2 x ) = 2 s i g m o d ( 2 x ) \begin{split} &\mathrm{tanh}(x) + 1 = \frac{1-\exp(-2x)}{1+\exp{(-2x)}} + 1 \\ &= \frac{2}{1+\exp{(-2x)}} \\ &= 2\mathrm{sigmod}(2x) \\ \end{split} tanh(x)+1=1+exp(−2x)1−exp(−2x)+1=1+exp(−2x)2=2sigmod(2x)

4. 假设我们有一个非线性单元,将它一次应用于一个小批量的数据。这会导致什么样的问题?

数据量不够,拟合效果会比线性单元更差,梯度估计不稳定。

原文地址:https://blog.csdn.net/weixin_45496725/article/details/136414395

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!