LLM每周速递!大模型最前沿:推理加速、模型微调/对齐、开源LLM、大模型Agent、多模态

来源: AINLPer公众号(每日干货分享!!)

编辑: ShuYini

校稿: ShuYini

时间: 2024-11-10

引言

紧跟技术发展趋势,快速了解大模型最新动态。一周的时间又要结束,今天继续总结最近一周的研究动态,本片文章攻击梳理了11篇有关大模型(LLMs)的最新研究进展,其中涉及涉及大模型混合上下文学习(ICL)、大模型推理加速、大模型推理时对齐、多模态模型、上下文LoRA微调、开源大模型、强化学习(RLHF)优化等热门研究。

清华|混合稀疏Attention

https://arxiv.org/pdf/2406.14909

大语言模型在处理长文本时,注意力机制的计算成本和存储需求很高。稀疏注意力机制可以降低这些成本,但是目前的稀疏注意力通常使用统一的稀疏模式,对所有注意力头都一样处理,难以适应不同注意力头的需求,导致精度和效率失衡。

为此,本文作者提出了一种新的方法《MoA: Mixture of Sparse Attention for Automatic Large Language Model Compression》,通过混合不同的稀疏度,仅用 25% 的注意力密度就能实现接近 100% 的上下文记忆效果。

混合上下文学习

论文:https://arxiv.org/pdf/2411.02830

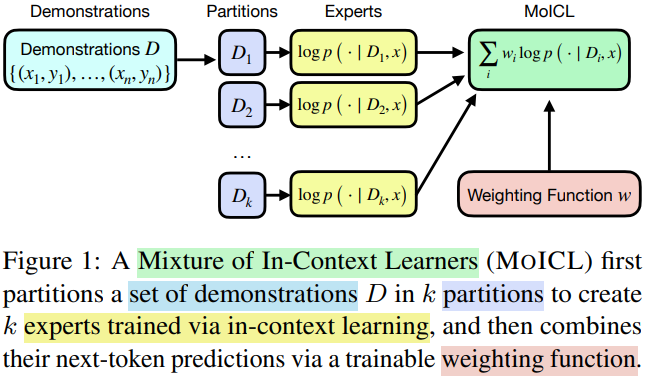

无需对大模型进行微调,上下文学习主通过给大模型(LLM)提供相关示例来实现希望的输出。面对大量的示例,大模型照单全收,随着示例越来越多,就会导致Transformer LLM的复杂度呈平方级增长,进而消耗大量的内存资源。

针对以上问题,这篇文章针对此问题提出了“混合上下文学习”(MOICL)模型。通过动态判断不同示例集对任务贡献,选择最优提示,进而减少示例数量来缩短推理时间,相比一些基线ICL和LENS在准确度大幅提升,且在计算效率上提升了13%。

UMASS|长文档推理提示框架

https://arxiv.org/pdf/2305.14564

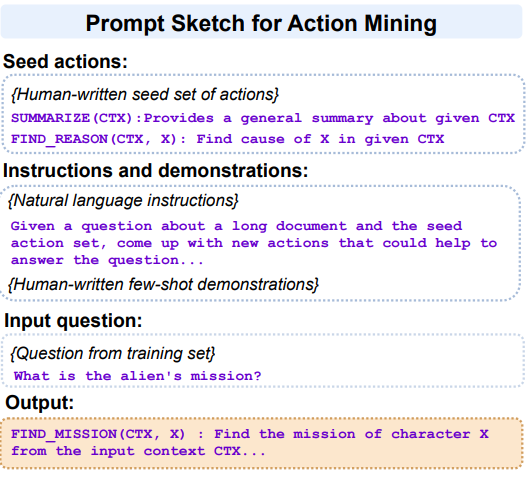

传统链式思维提示法(chain-of-thought prompting)通过分解步骤提高模型效果,但在长文档推理中效果有限。

为此,本文为了提升大模型在长文档推理中的表现,提出了一个名为 PEARL 的提示框架。PEARL 包括动作挖掘、计划制定和计划执行三个阶段,将复杂问题分解为一系列具体动作(如“总结”、“查找事件”),并依次执行以获得答案。实验表明,PEARL 在长文档推理任务上表现优于传统方法,是提升 LLM 处理长文档推理的一项初步探索。

字节|残差连接平替,加速收敛

https://arxiv.org/pdf/2409.19606

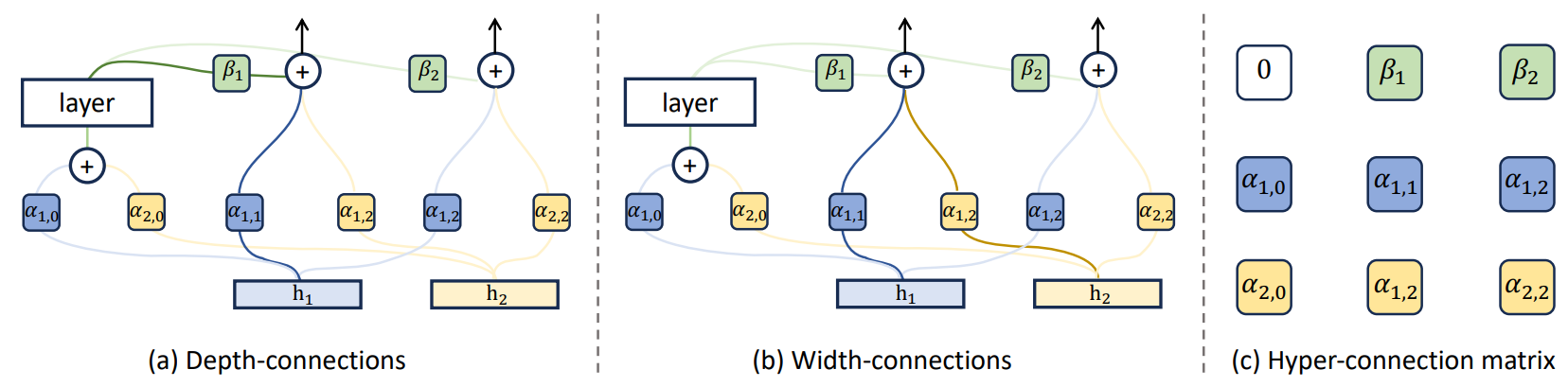

残差连接主要用于缓解梯度消失问题,增强网络训练的稳定性。但现有残差连接变体在梯度消失和表示崩溃之间存在权衡问题,无法同时解决这两个问题。

本文作者提出了**超连接(Hyper-Connections)**概念,旨在解决上述残差连接跷跷板式困境。超连接适用于大语言模型(LLMs)的预训练,并且在Dense模型和MoE模型的实验中显示出显著的性能提升,最高可将预训练收敛速度提升80%。

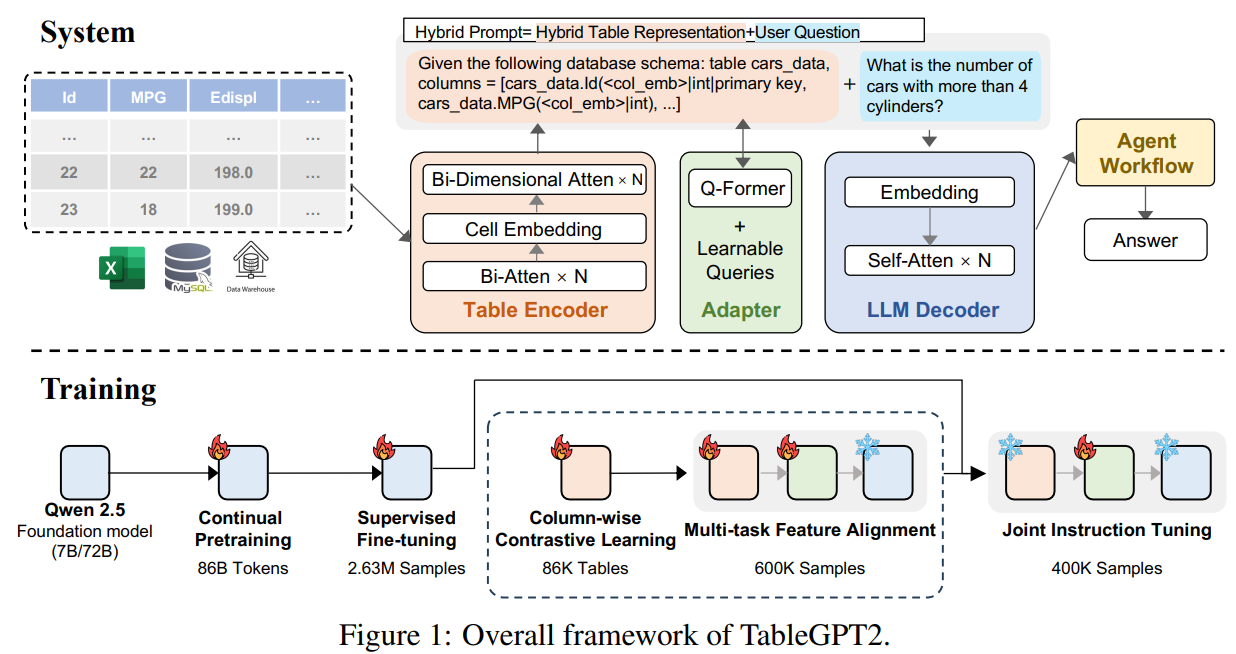

浙大|开源TableGPT2系列,媲美GPT-4o

https://arxiv.org/pdf/2411.02059

TableGPT2 是 TableGPT 的新一代版本,它具备7B和72B版本(Base Modle:Qwen)。初始版本的 TableGPT 就已经引入了结构化特定领域语言(DSL)和专用表格编码器等方法,可以管理复杂的基于表格的请求。

本文作者将结构化数据(包括数据库、数仓、表格、json 等)视为了一种独立模态,TableGPT2 创新性地加入了一个单独的模态模块,专门用于读取和解释表格数据。性能表现较之前代已有大幅提升:在某些基准上,TableGPT2 能够媲美甚至优于 GPT-4o!

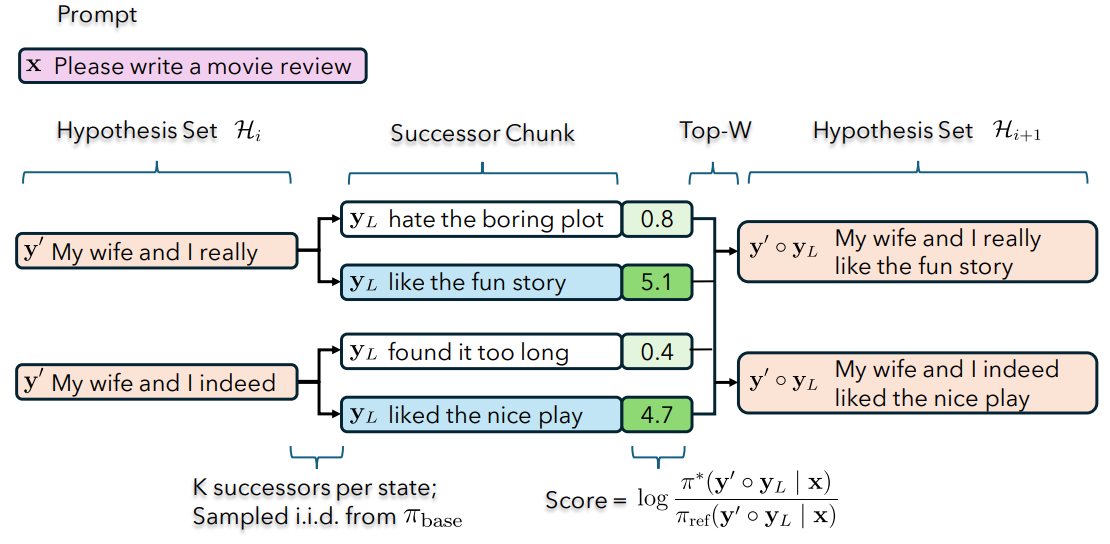

上海AI Lab| 推理时对齐

https://arxiv.org/pdf/2405.19262

当前大模型参照少则7B、8B,多则100+B,要实现对预训练模型的微调对齐,需要大量的计算资源。这对于一些小型实验室、研究机构来说是非常困难的,那么能否有一种方法既能实现大模型对齐还能节约计算资源呢?前几天刚刚分享了一篇CMU提出的推理时对齐方法,即通过改变解码策略直接在推理时进行对齐,避免了直接微调大型模型的复杂性。

本文提出的“弱到强搜索”(weak-to-strong search)方法与CMU的思路有异曲同工之妙,该方法是由**「上海人工智能实验室」** 提出,简单来说就是将大模型的对齐过程转变为推理阶段的一种贪婪搜索方式,即**「首先微调一个小模型,然后在大模型解码过程中,引导大模型去最大化微调前后小模型的输出对数概率差,从而实现类似于微调大模型的效果」**。

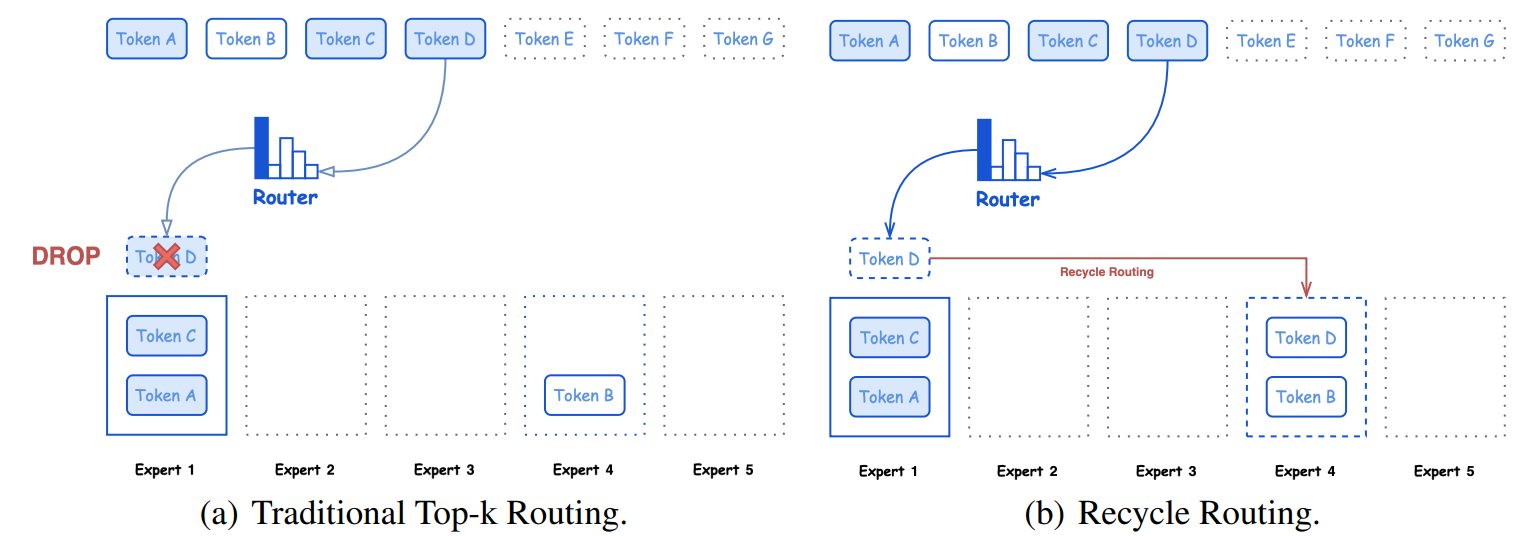

腾讯 | 开源MoE架构大模型:Hunyuan(混元)

https://arxiv.org/pdf/2411.02265

本次腾讯混元 - Large 共计开源三款模型:Hunyuan-A52B-Pretrain,Hunyuan-A52B-Instruct 和 Hunyuan-A52B-FP8,可支持企业及开发者精调、部署等不同场景的使用需求,可在 HuggingFace、Github 等技术社区直接下载,免费可商用。该模型在路由训练策略、长文本优化、推理加速等方面做了相关优化。

在 CMMLU、MMLU、CEval、MATH 等多学科综合评测集以及中英文 NLP 任务、代码和数学等 9 大维度全面领先,超过 Llama3.1、Mixtral 等一流的开源大模型。

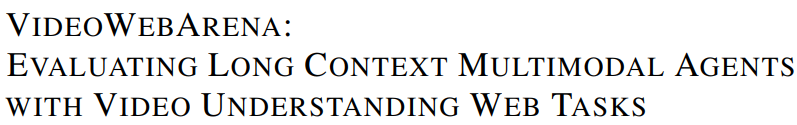

CMU && MIT | 多模态Agent视频理解能力评估基准:VideoWA

视频可以提供文字和图片无法传达的信息,但许多Agent基准测试忽略了长时视频理解。

为此,本文提出了VideoWebArena (VideoWA),用于评估Agent对长时视频的理解能力。VideoWA包含基于视频教程的2,021个任务,分为“技能保留”和“事实保留”两类:前者测试Agent能否通过模仿完成任务,后者测试能否从视频中提取关键信息。实验显示,当前模型在这些任务上的表现远低于人类水平,凸显了提升长时多模态模型Agent能力的需求。

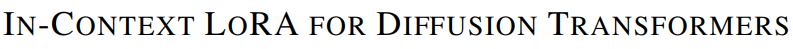

通义千问 | 扩散Transformer上下文LoRA微调

https://arxiv.org/pdf/2410.23775

扩散Transformer上下文LoRA微调 昨天分享的一篇文章通义提出来的DiTs,即利用扩散Transformer进行任务无关的图像生成。然而刚过几天,该框架又升级了,作者认为DiTs生成的图像清晰度仍然不理想。

通过实验,作者发现现有的文本到图像 DiTs 无需调优也能有效进行上下文生成。 为此,作者提出了一种简单流程:(1)串联图像而非令牌;(2)对多图像进行联合描述;(3)用小数据集进行任务特定的 LoRA 微调,而非大数据集的全参数调优。该模型称为“上下文 LoRA”(IC-LoRA),无需对原始 DiT 模型做任何修改,仅需调整训练数据。此流程能生成更高保真度的图像集,符合提示要求

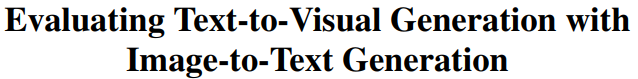

CMU | 文生图评估优化

https://arxiv.org/pdf/2404.01291

尽管生成式AI有很大进展,评估仍然困难,缺乏有效指标和标准基准。常用的CLIPScore在处理复杂提示时不准确,容易混淆对象和关系。

为此,本文作者提出了VQAScore,它使用视觉问答模型通过简单问题来判断图像和文本的匹配度。VQAScore不仅简单,还在8项图像-文本对齐基准上表现出色,且其自研模型(CLIP-FlanT5)优于GPT-4V等强基线模型。此外,VQAScore还能用于视频和3D模型,除此之外,本文还推出了GenAI-Bench基准,包含1600个复杂组合提示和超过15,000条人工评分,用于评估如Stable Diffusion、DALL-E 3等生成模型。

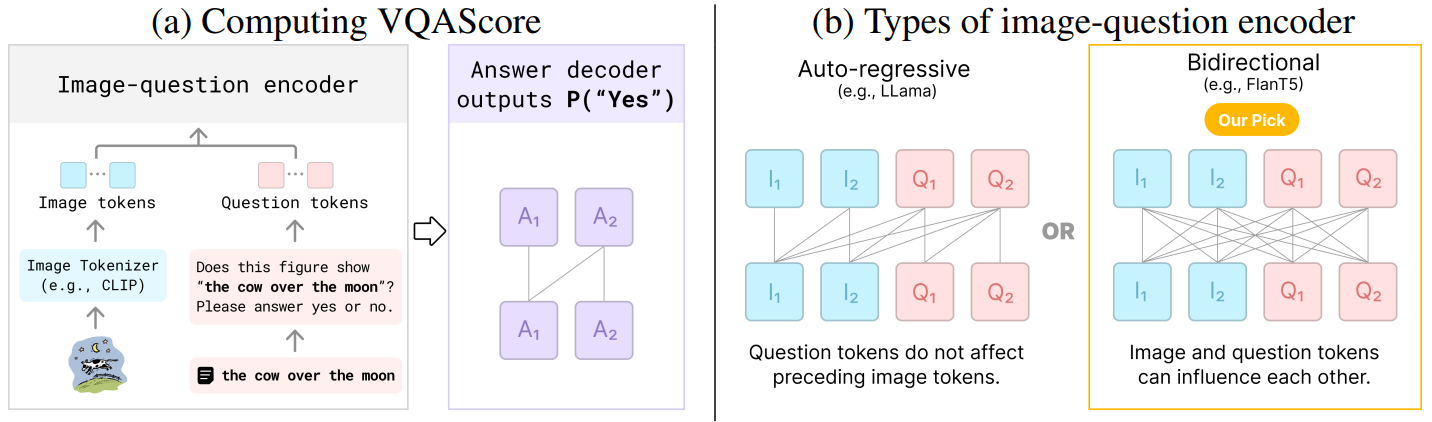

Google && 芝大 | 提出可扩展开放式RLHF框架:EVA

论文:https://arxiv.org/pdf/2411.00062

对基于 LLM 的 AI 来说,高质量的人类数据非常关键,但已有研究预计这些高质量数据将在未来几年耗尽。

为了提升语言模型的对齐能力,人们已经提出了许多偏好优化算法,但它们都默认使用固定的提示词训练分布。这种固定的训练范式缺乏可扩展性,并不可避免地导致泛化问题和效率问题。 基于这些考虑,谷歌和芝大开发了一种可扩展的开放式 RLHF 框架 eva,即 Evolving Alignment via Asymmetric Self-Play,也就是「通过非对称自博弈实现的演进式对齐」。

AINLPer的星球

这是ShuYini花费300多天创建的自然语言处理AI知识星球!现已有860+多个主题,13个专栏,涉及每日论文分享、大模型整理、热门综述、学术会议、模型实操等。

AINLPer星球,旨在每日多新,第一时间分享最前沿的自然语言处理、大模型/AIGC、行业发展、智能问答、深度学习、面试找工作等方向的资料,发论文/搞科研,强烈推荐!!

双十一特惠

现星球双十一特惠开放加入,新人立享50元优惠券,仅50个名额,赶快扫描下方二维码加入吧!

加入星球,您将获得

1.最前沿、最优质的论文推送 [支持PDF一键下载];

2.最新的行业动态,例如:大模型、Agent、检索增强(RAG)、多模态、推理加速;

3.从入门到精通的人工智能学习资料(自然语言处理、深度学习、智能对话等领域),最专业的知识问答咨询;

4.最新的大模型实战项目(ChatGLM、LLaMA、RAG系统、GPT-Sovits等);

5.垂直领域方向以涵盖:大模型微调、大模型Agent、大模型增强、多模态、智能问答、检索增强(RAG)、热门综述、数据集基准、情感识别、情绪分析、Attention优化、Transformer、Mamaba、状态空间(SSM);

原文地址:https://blog.csdn.net/yinizhilianlove/article/details/143668239

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!