视频扩散模型介绍 Video Diffusion Models Introduction

视频扩散模型介绍 Video Diffusion Models Introduction

Diffusion 扩散模型中的一些概念

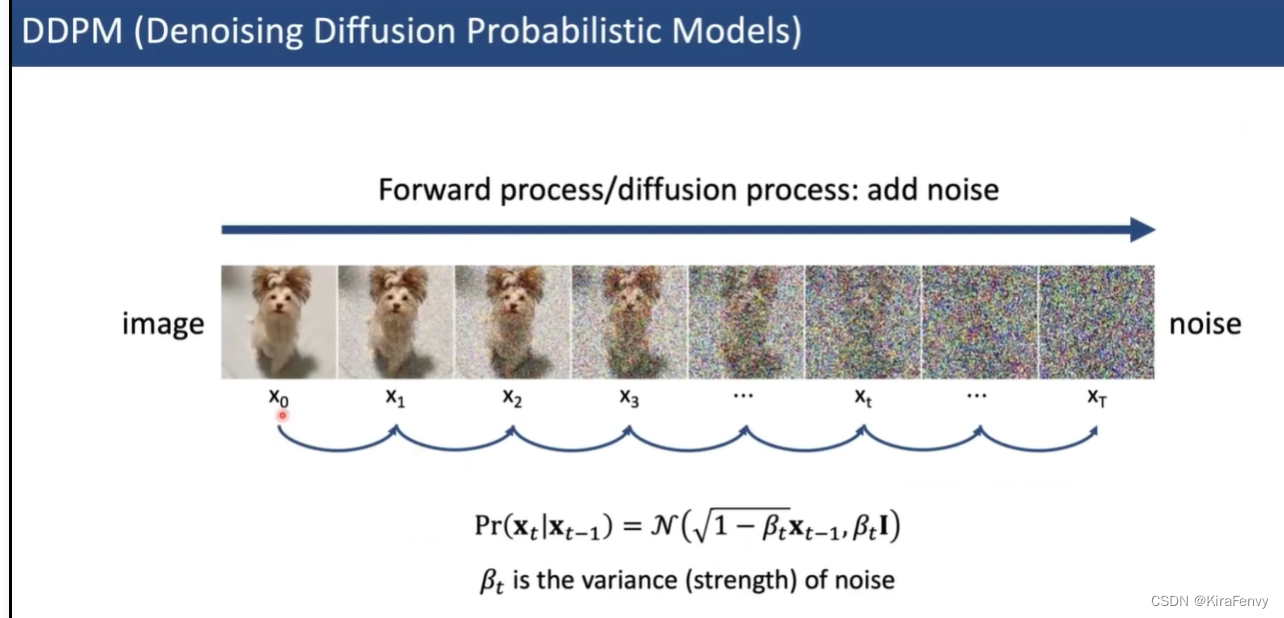

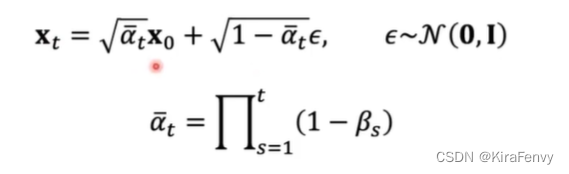

DDPM

扩散过程和去噪过程

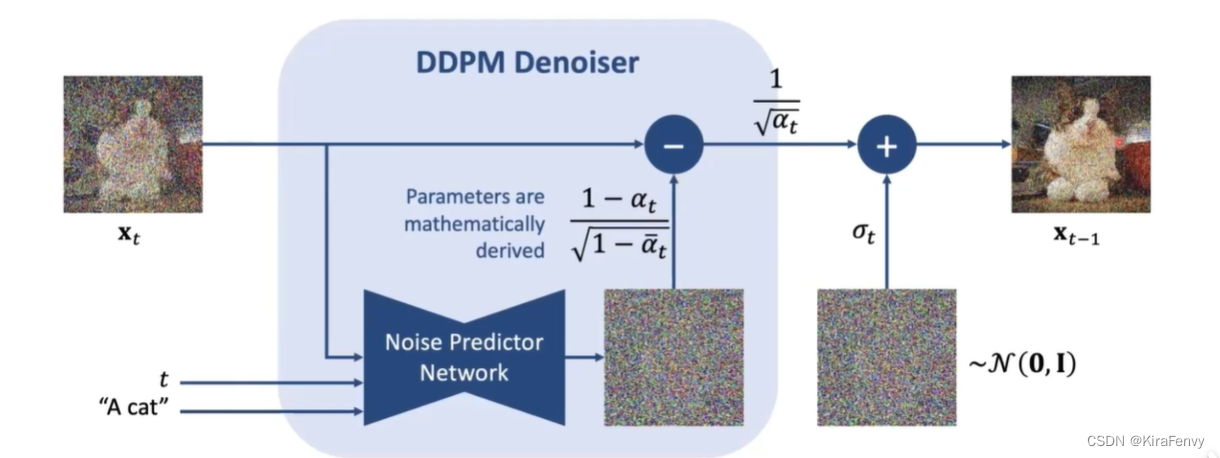

去噪器,预测出来噪声然后与原始图片相减,得到干净的图片

当然,去噪过程是逐步的,所以减去之后会重新加上“平均噪声”

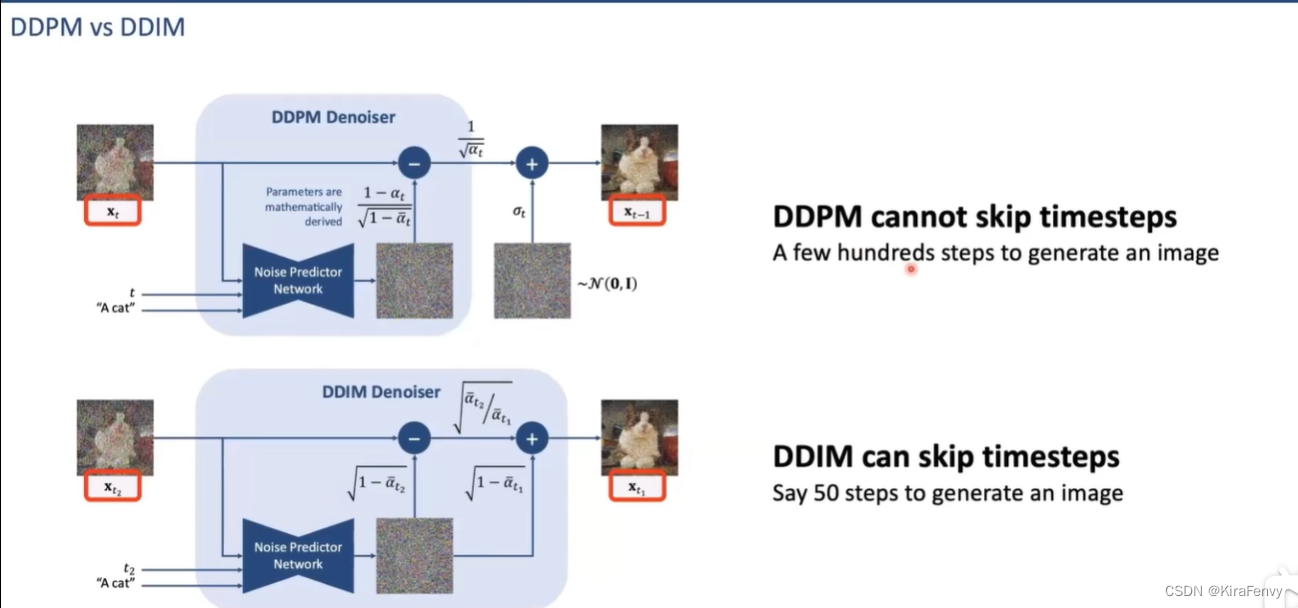

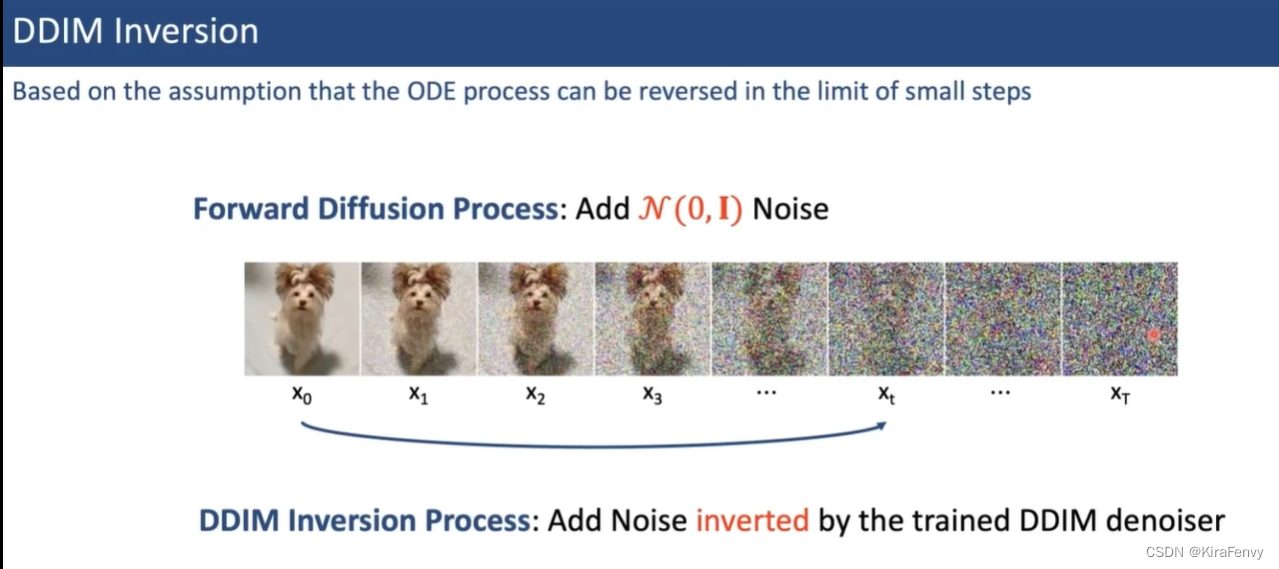

DDIM

跳步

DDIM和DDPM作对比:

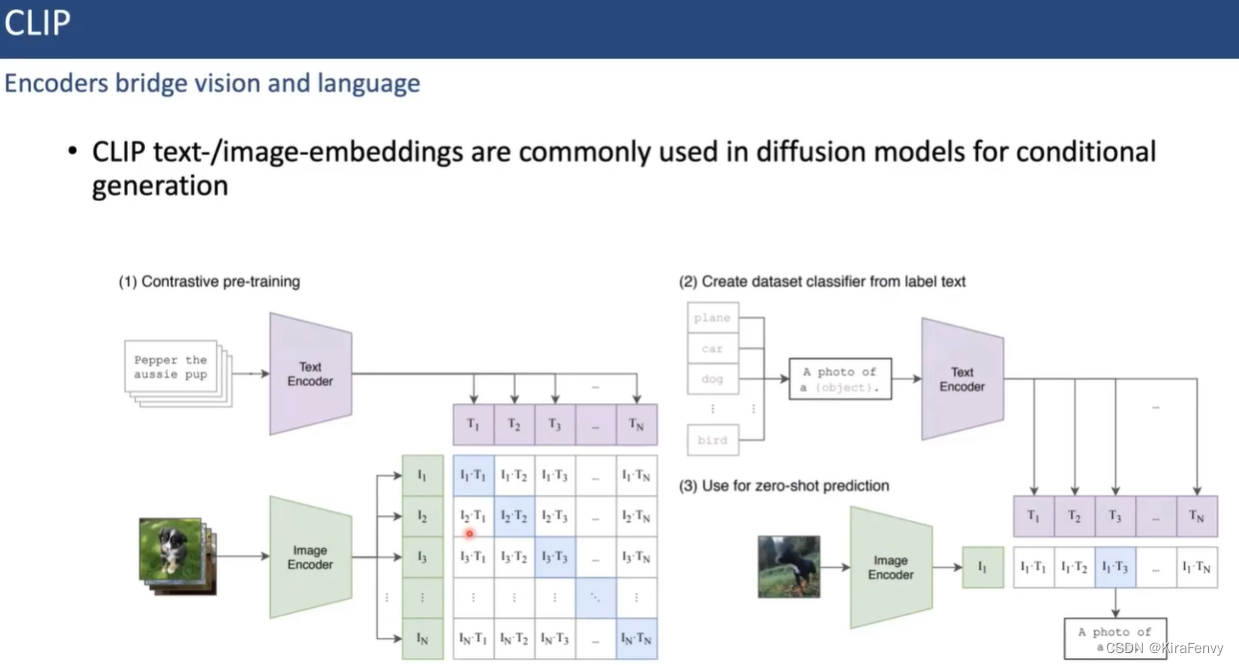

CLIP

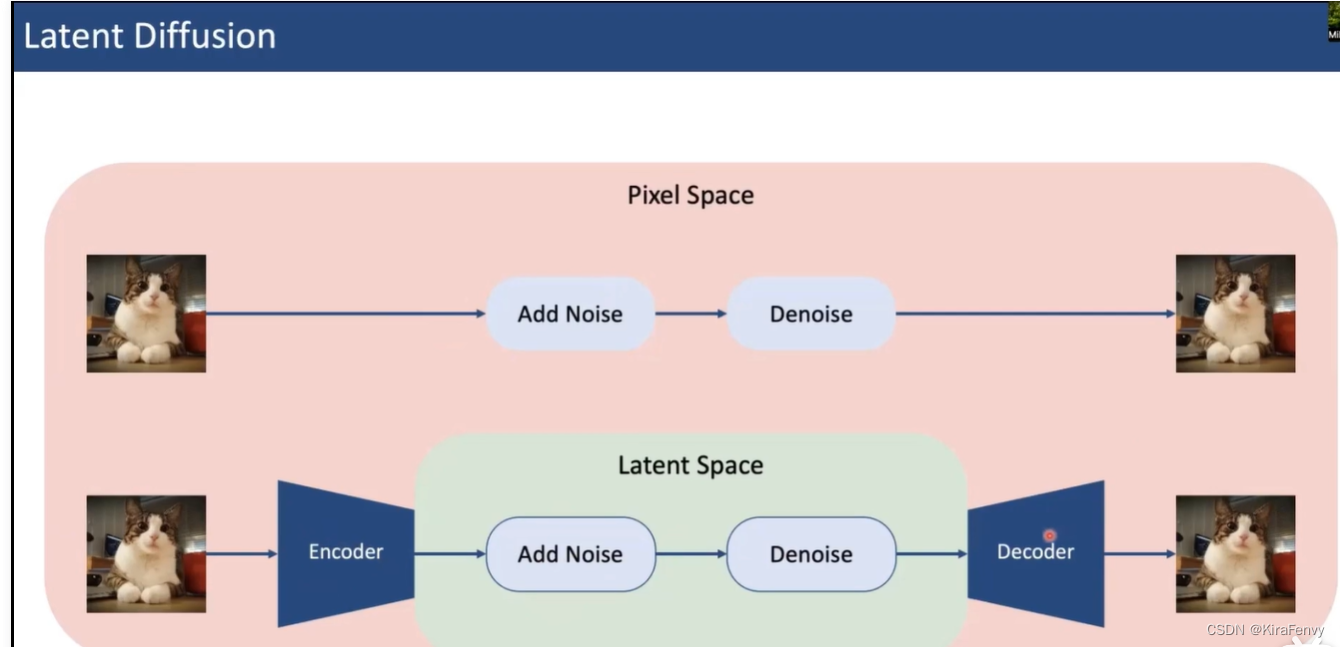

Latent Diffusion

不是直接在像素空间进行操作,多了编码解码,在latent空间操作加噪和去噪过程

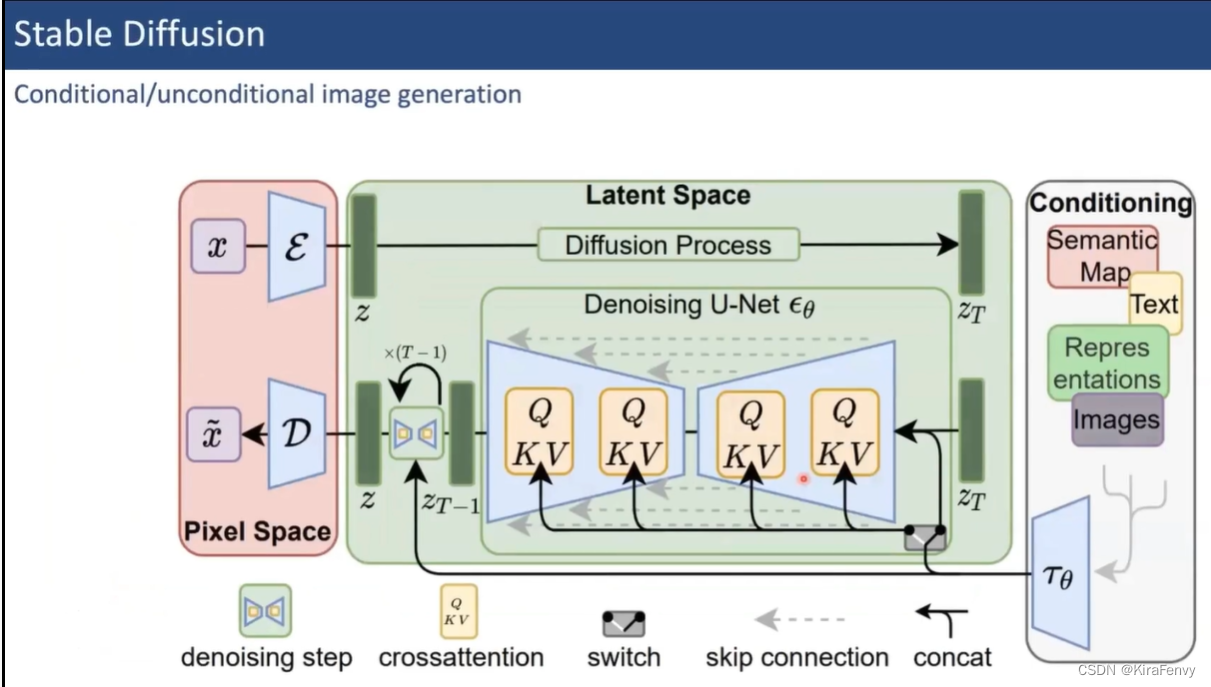

Stable Diifusion

LoRA

微调

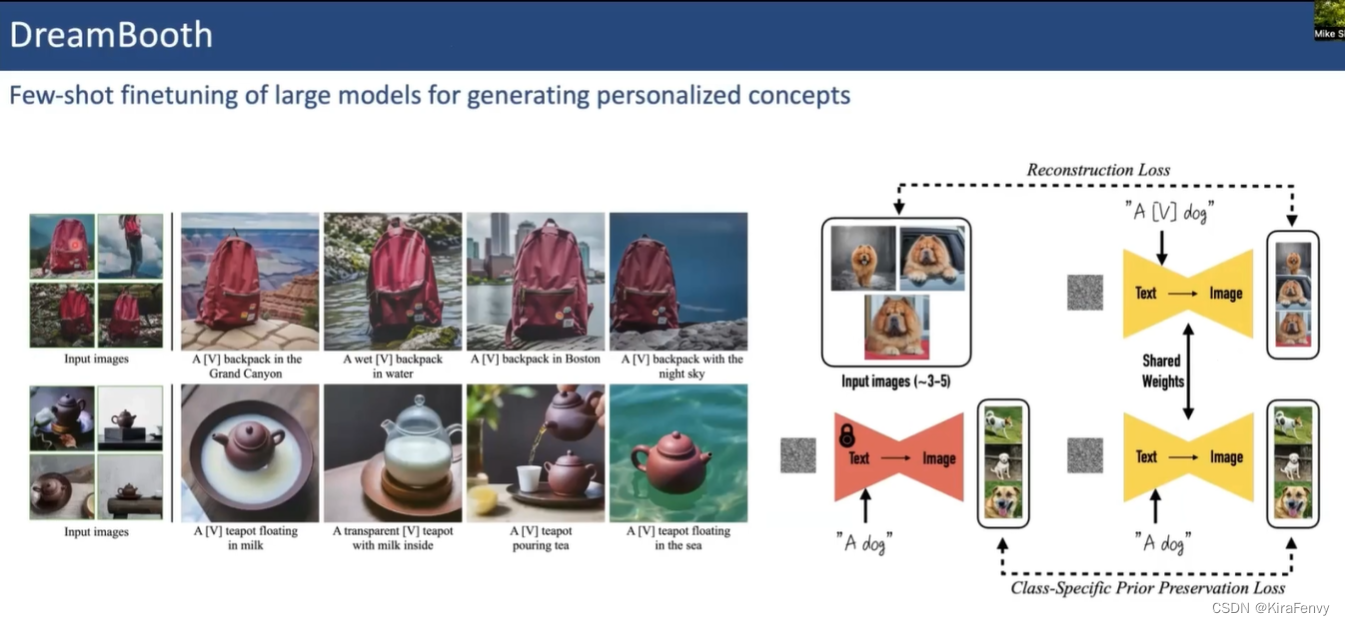

DreamBooth

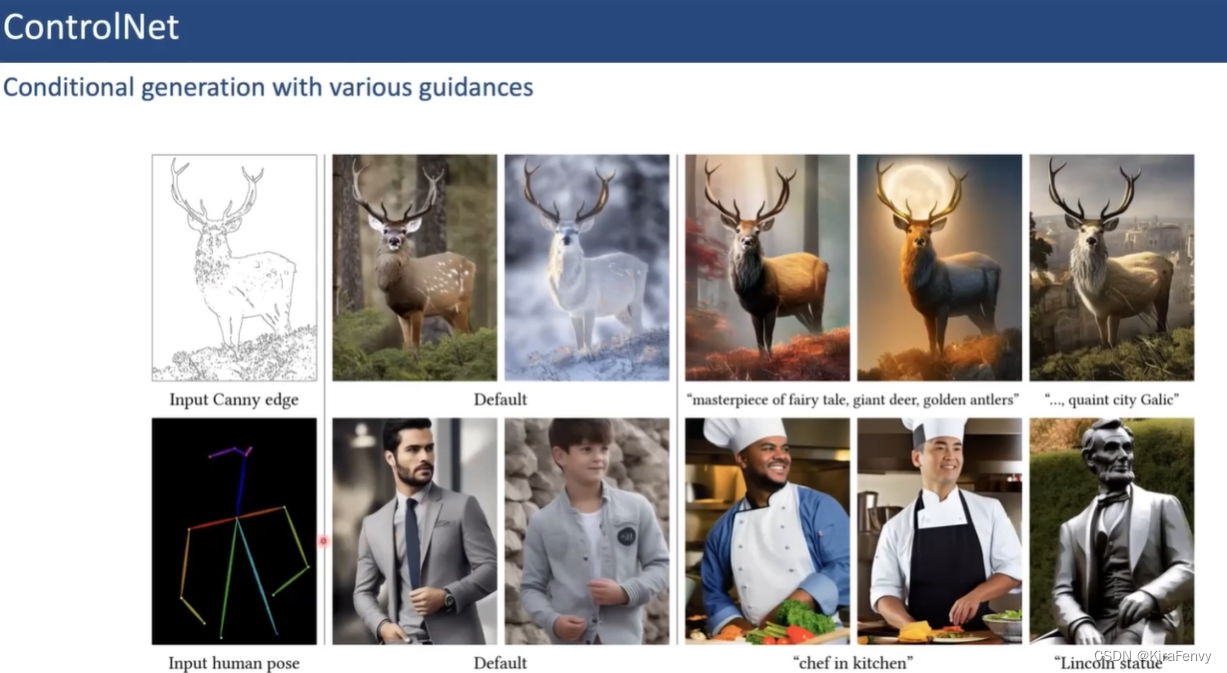

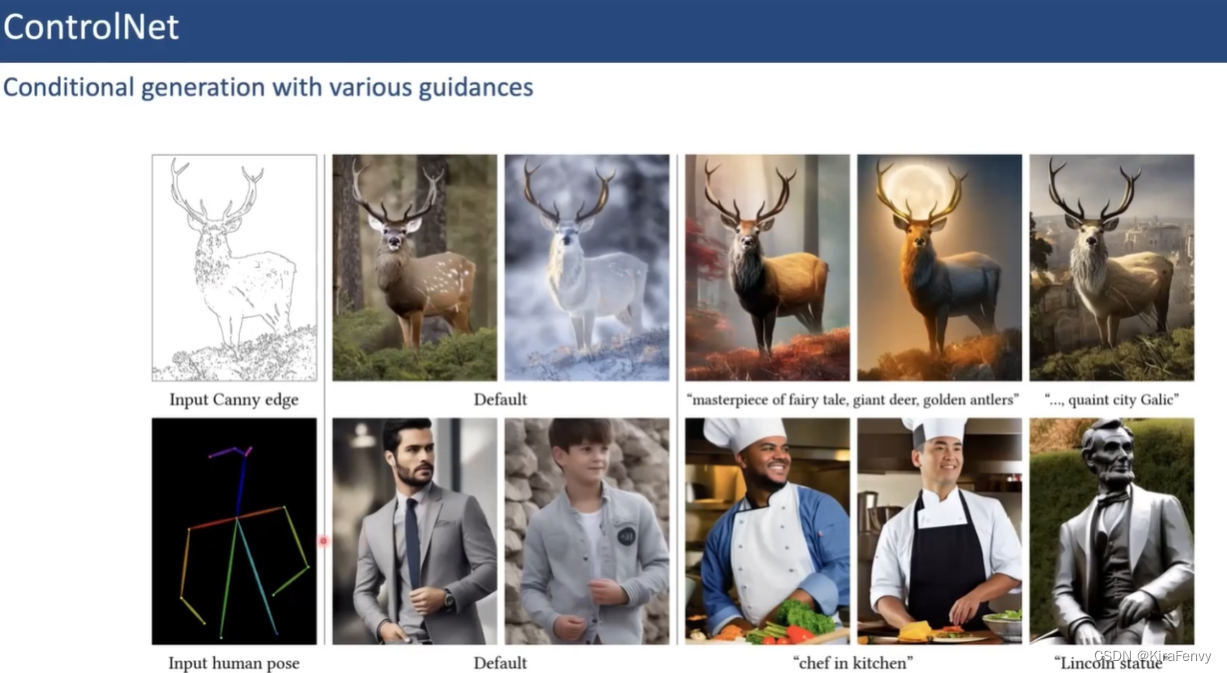

ControlNet

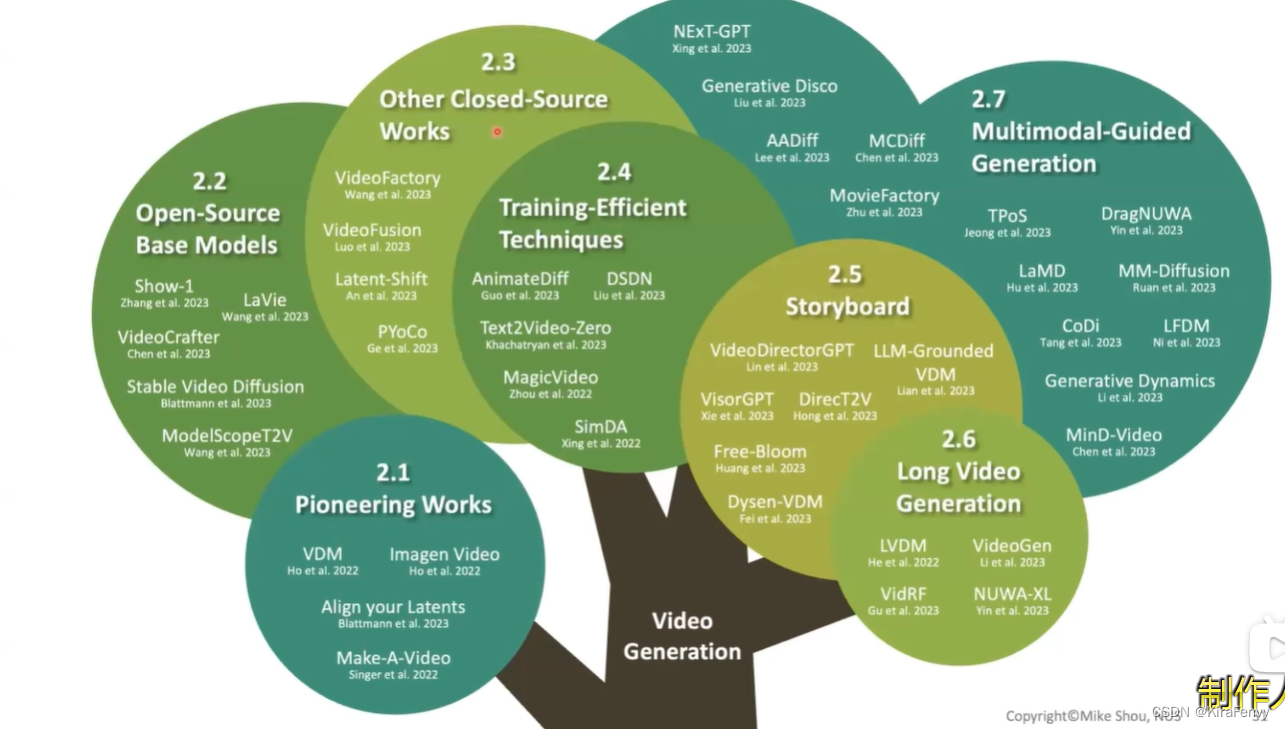

视频生成

一些已有的工作分类

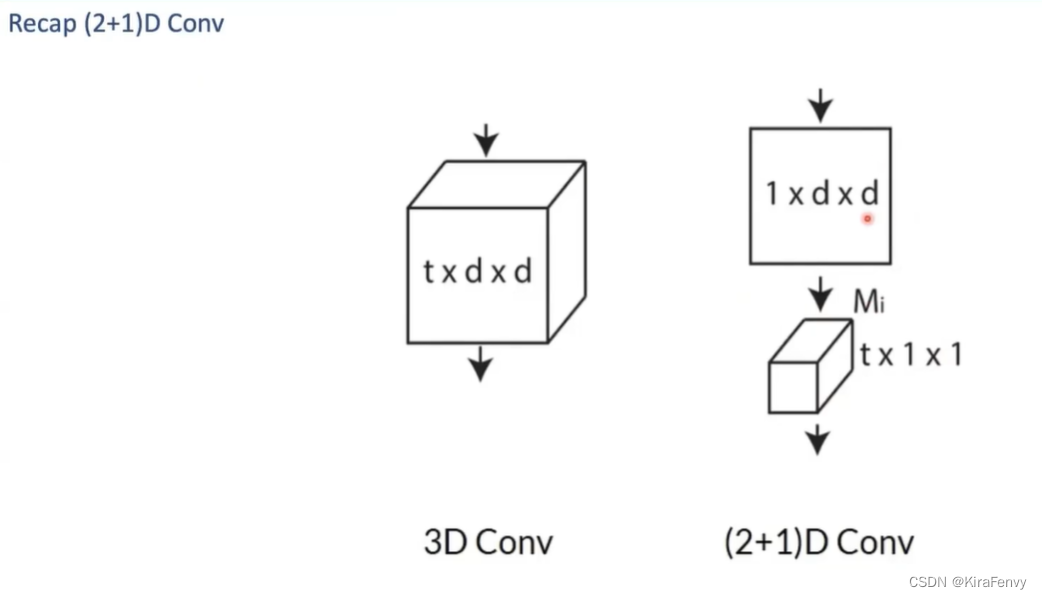

3D可以分成(2+1),就是从图片生成到视频生成的一种思路

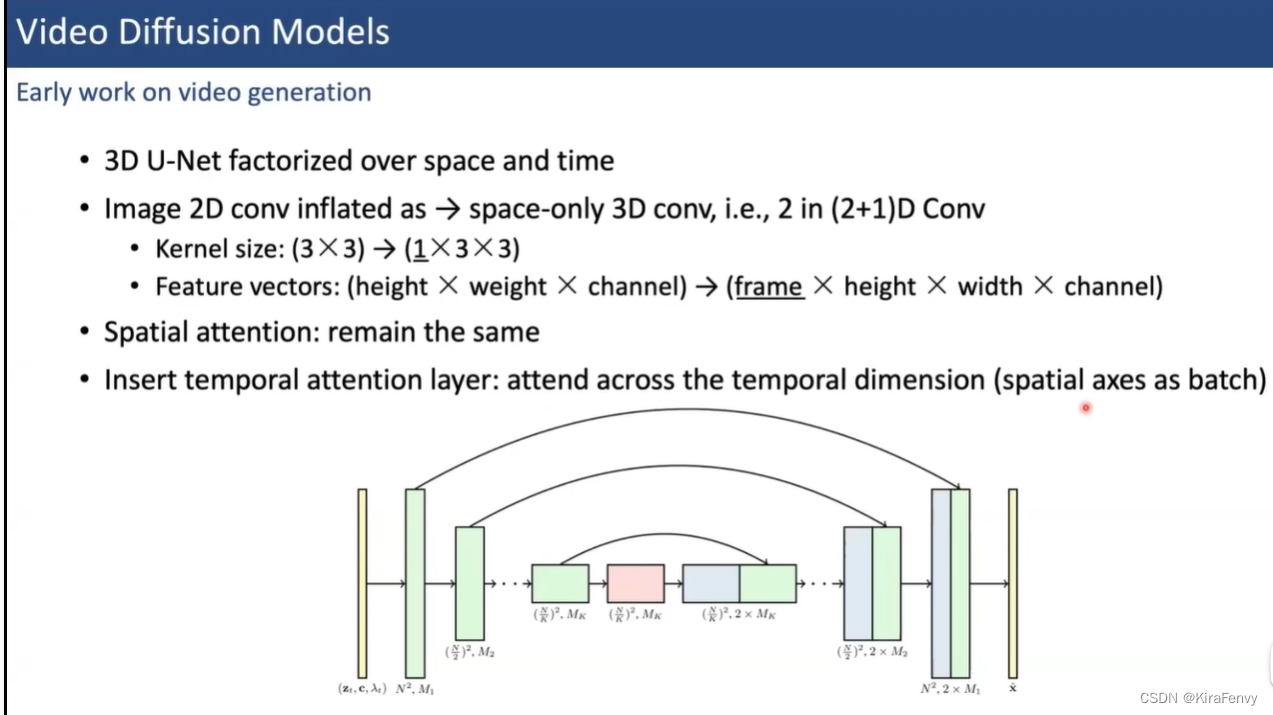

早期工作:

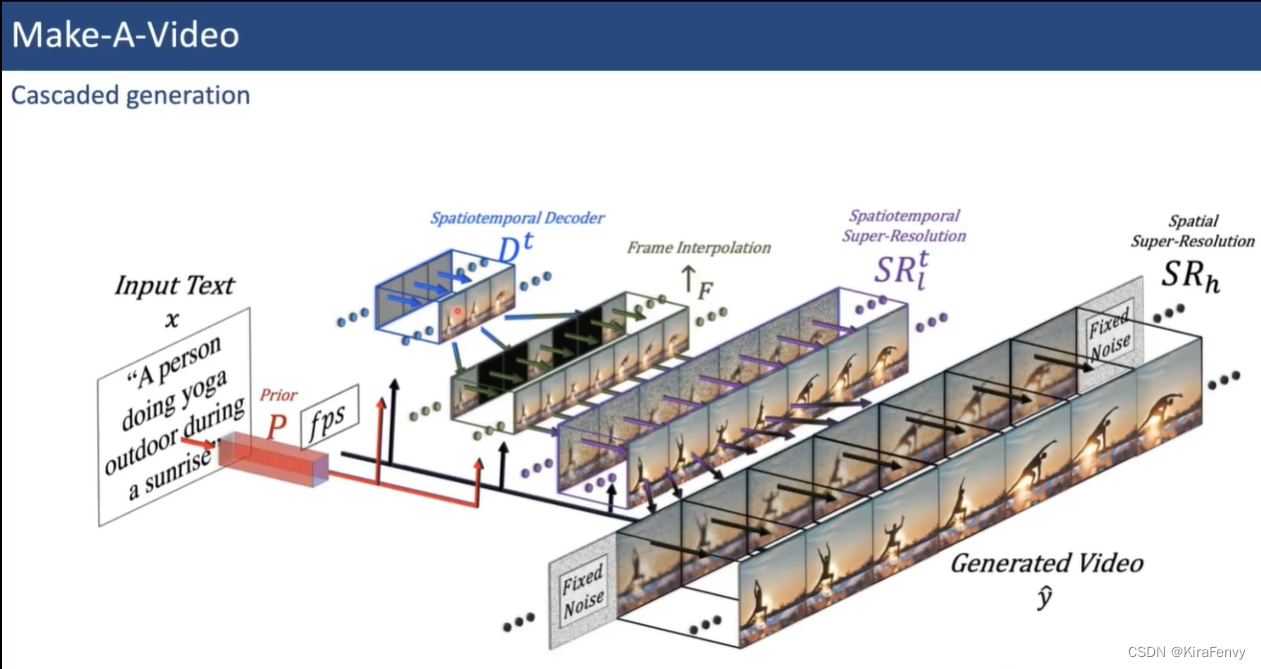

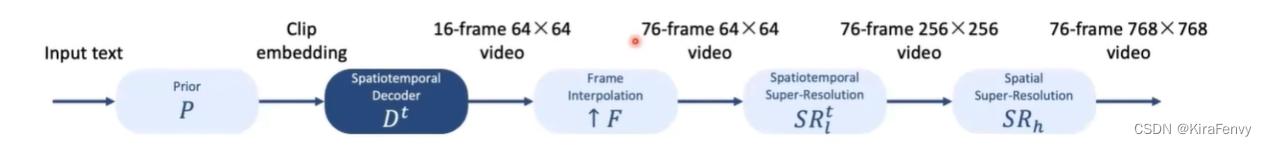

解码器+插帧+超分辨率模块

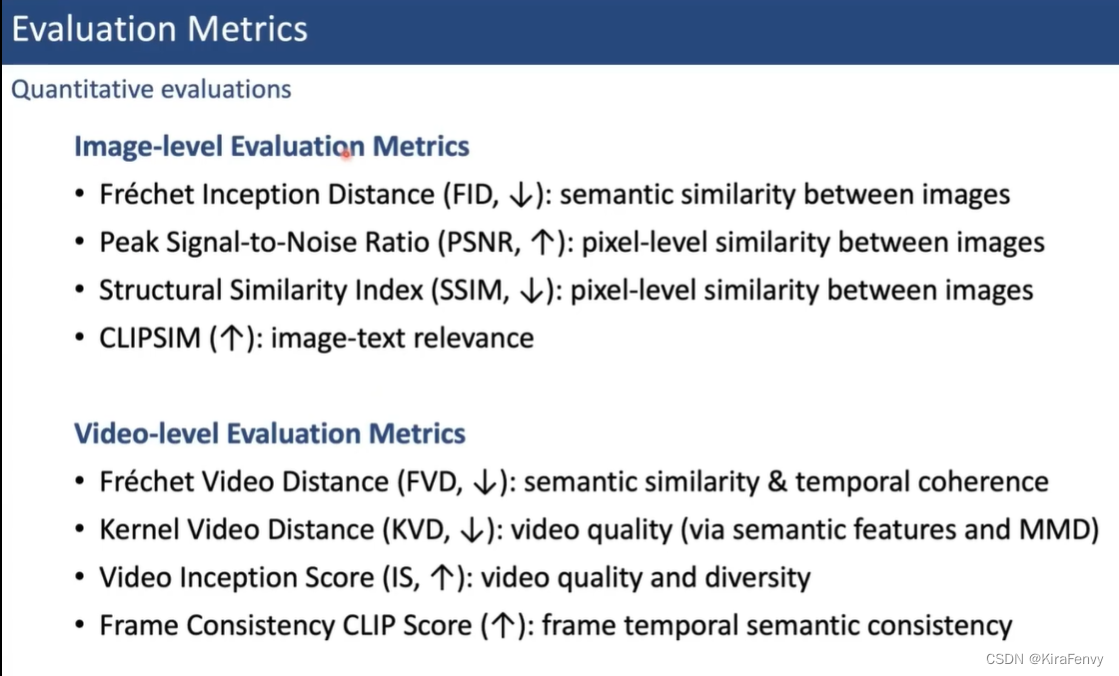

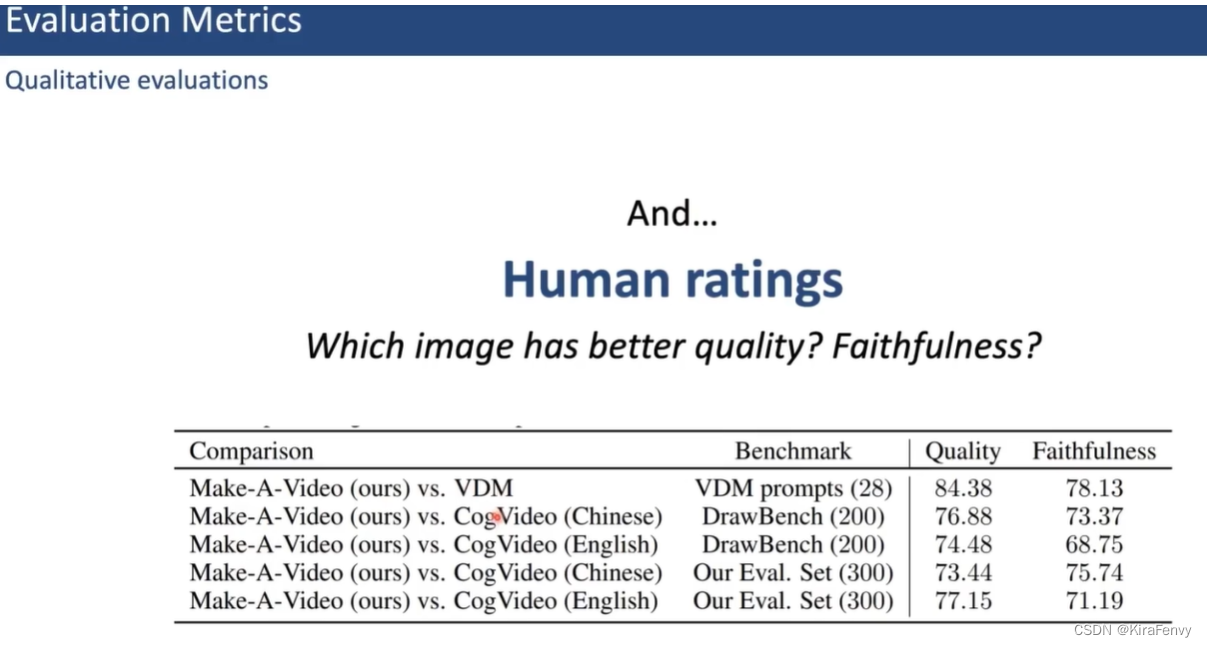

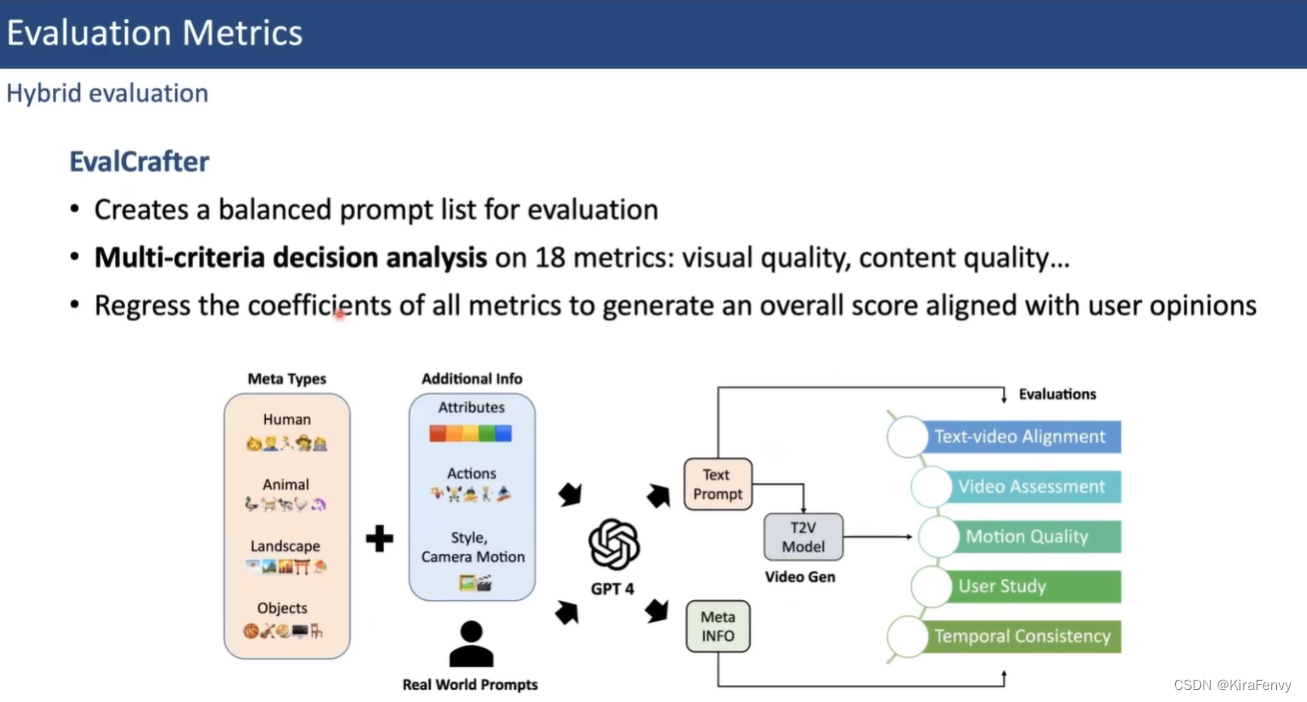

评估标准

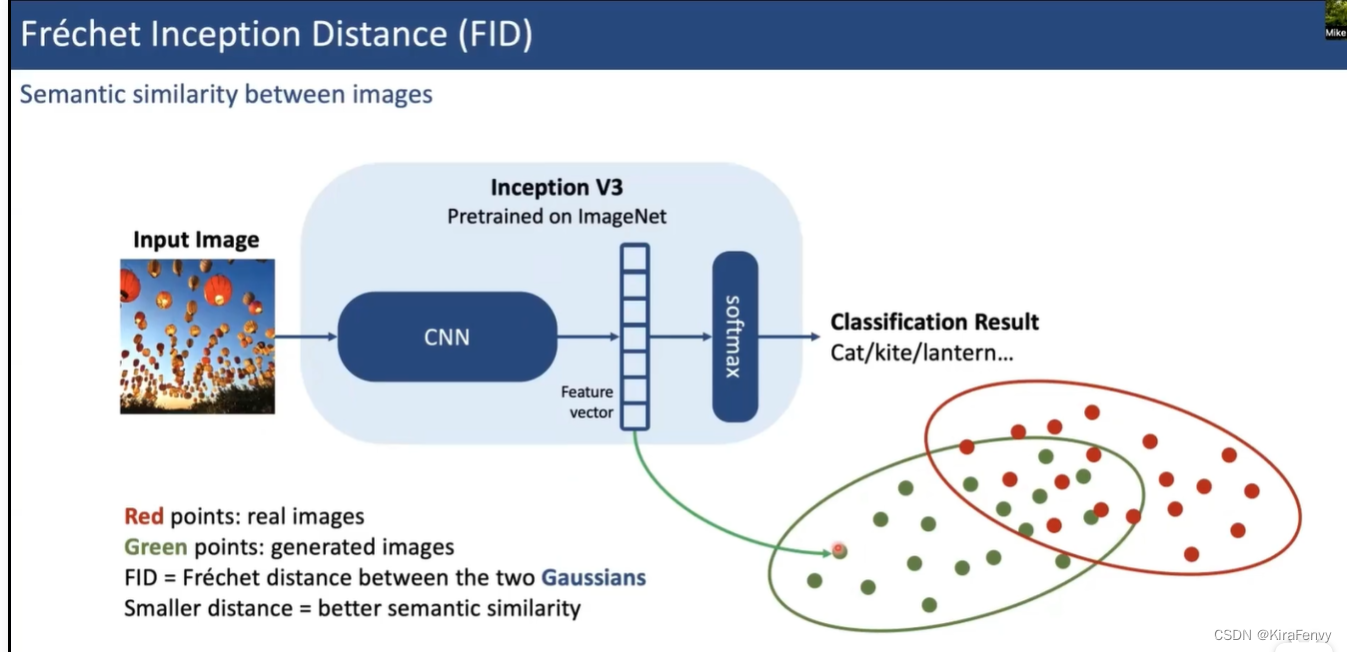

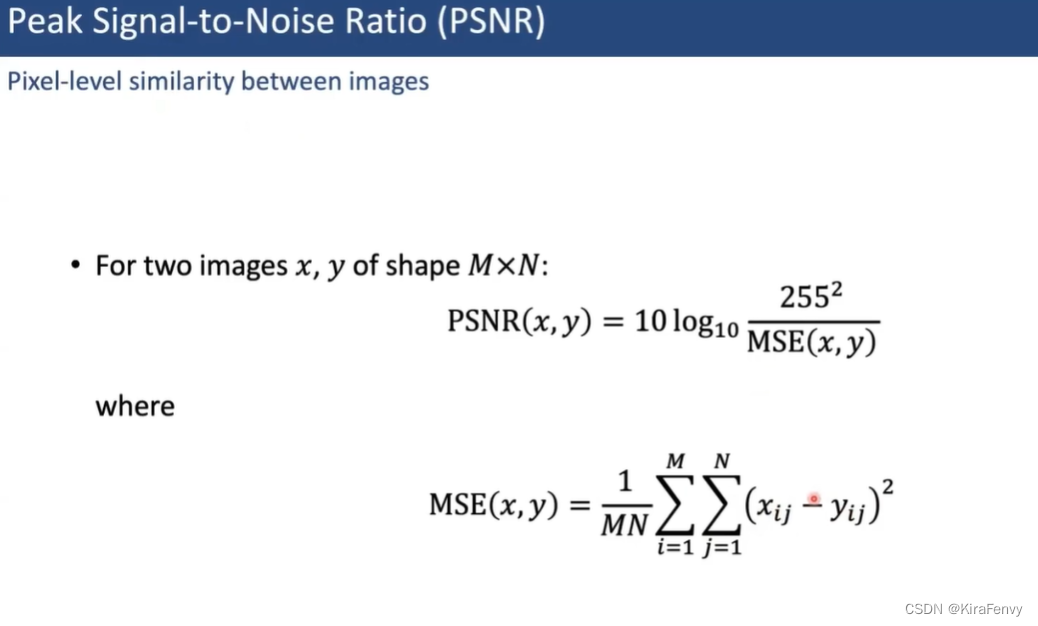

图片层面

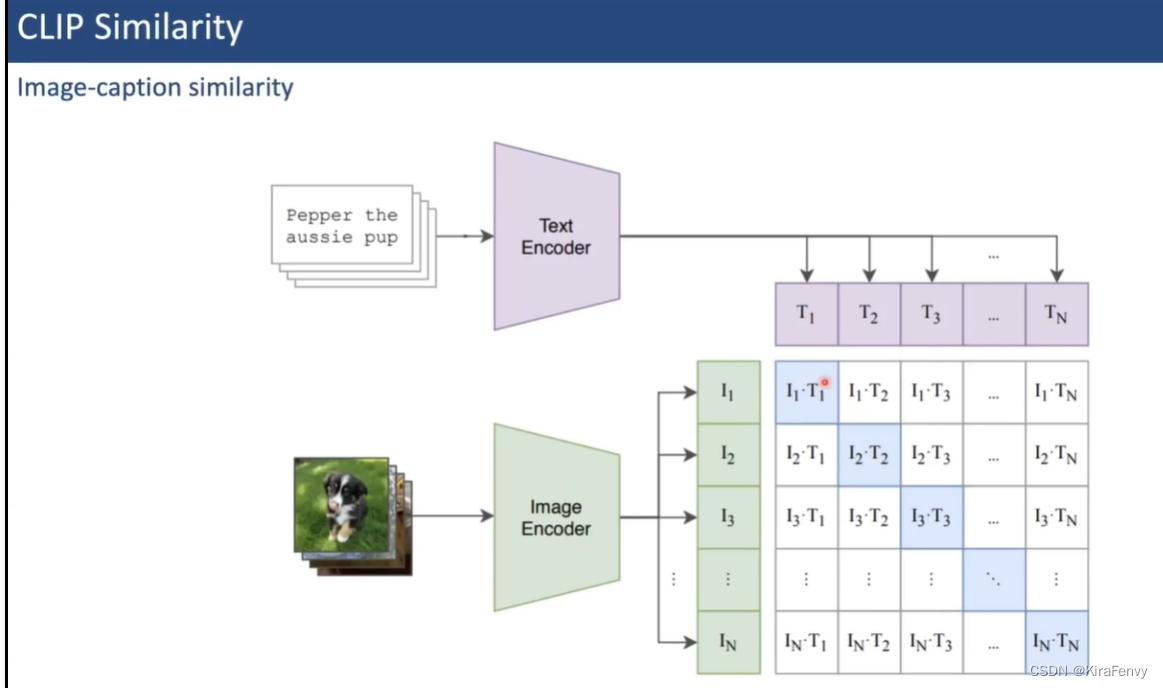

语义相似度

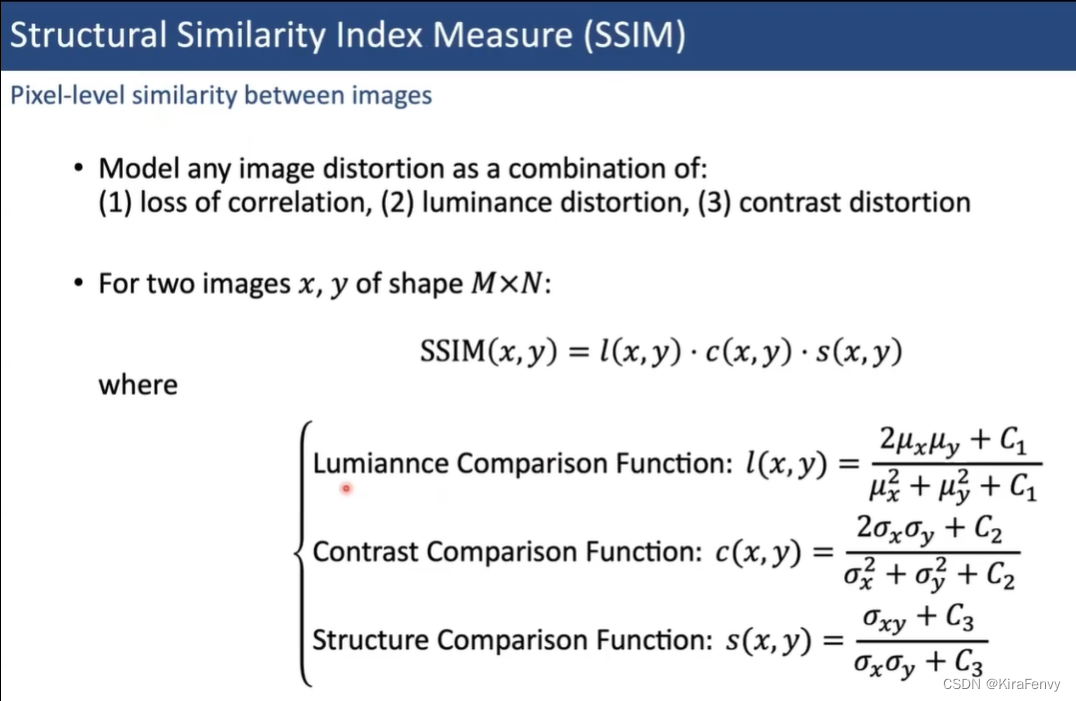

像素相似度

视频层面

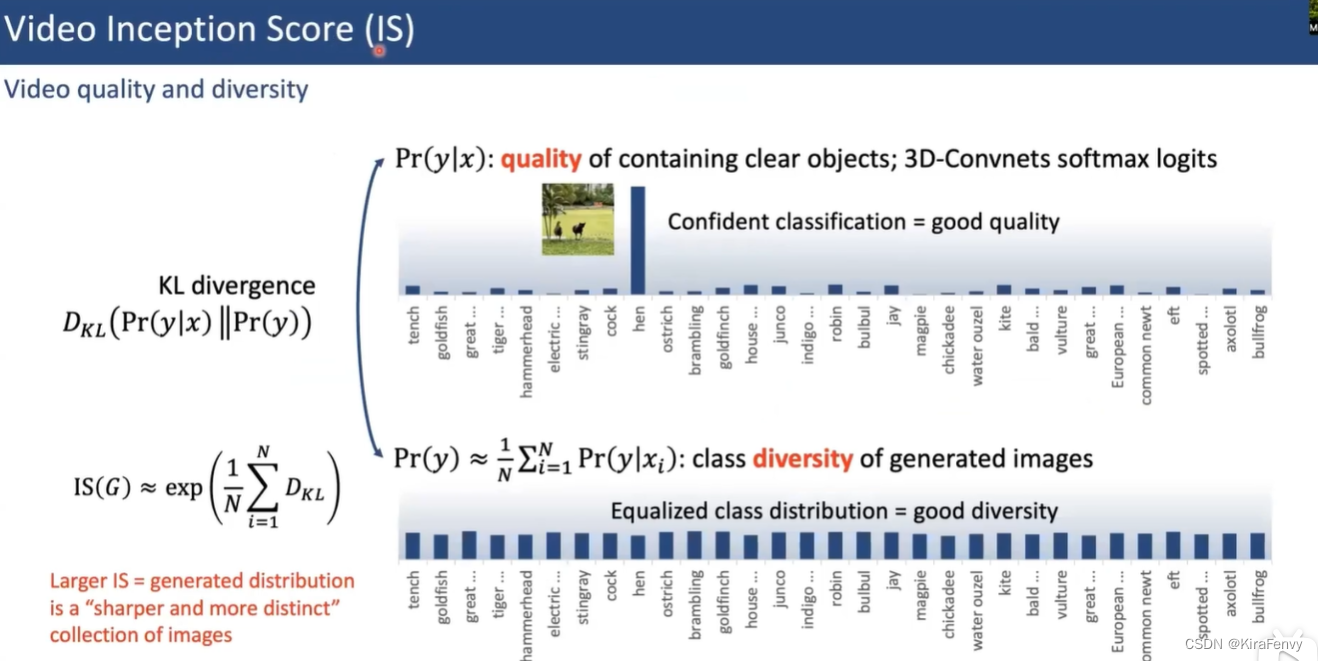

视频生成的质量和多样性

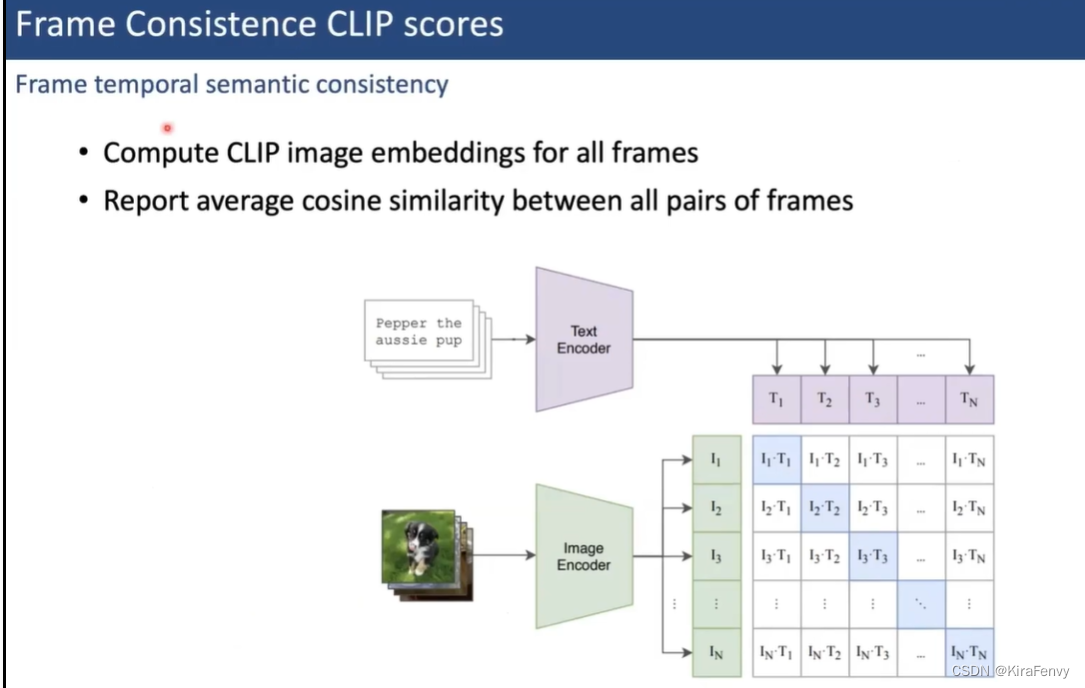

一致性

组合评估

前人的工作

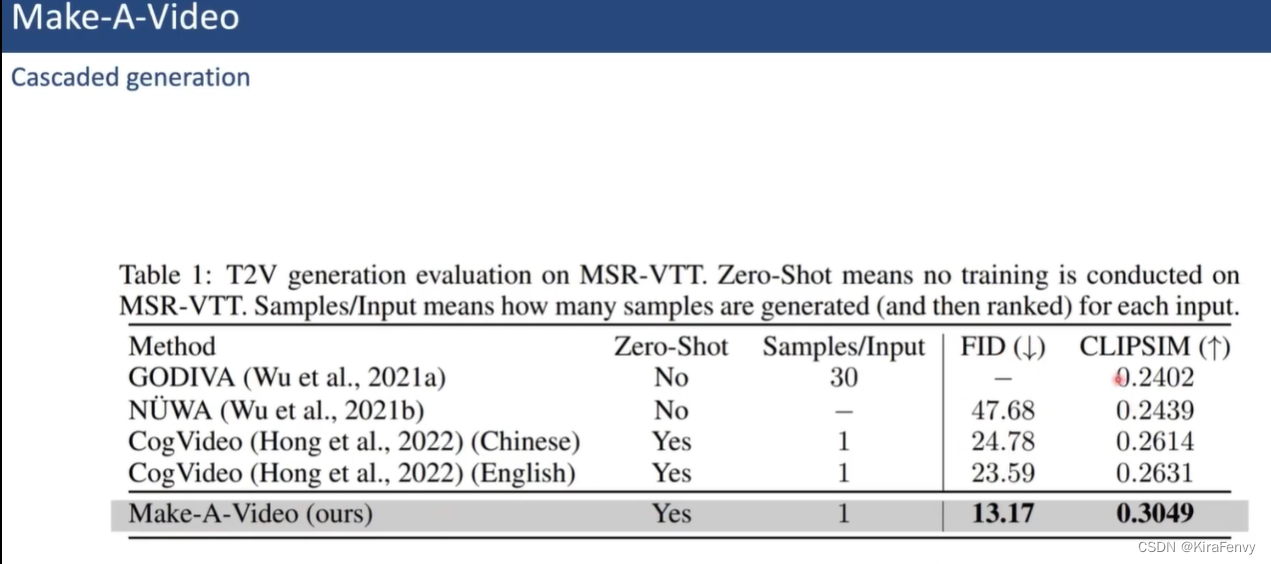

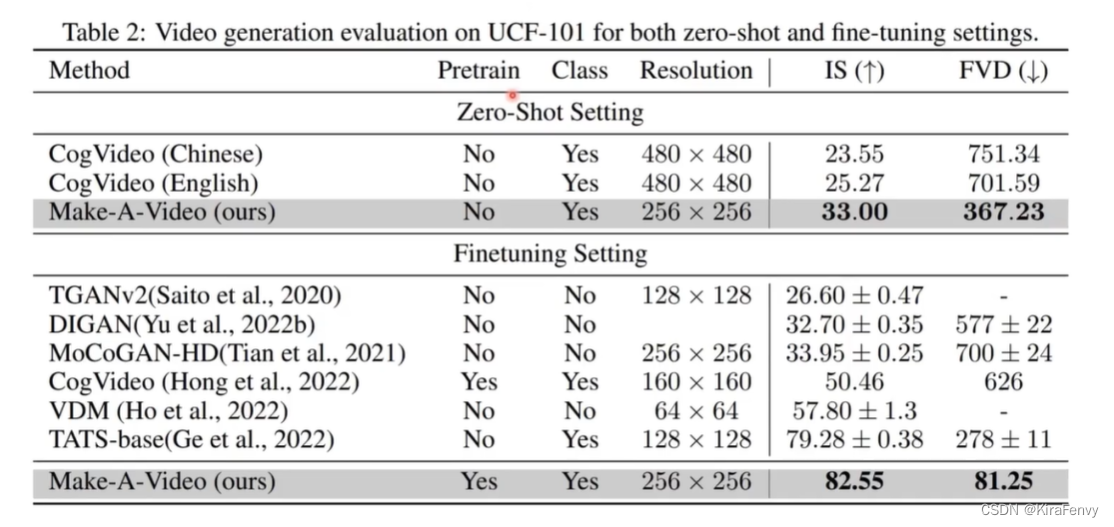

Make-A-Video

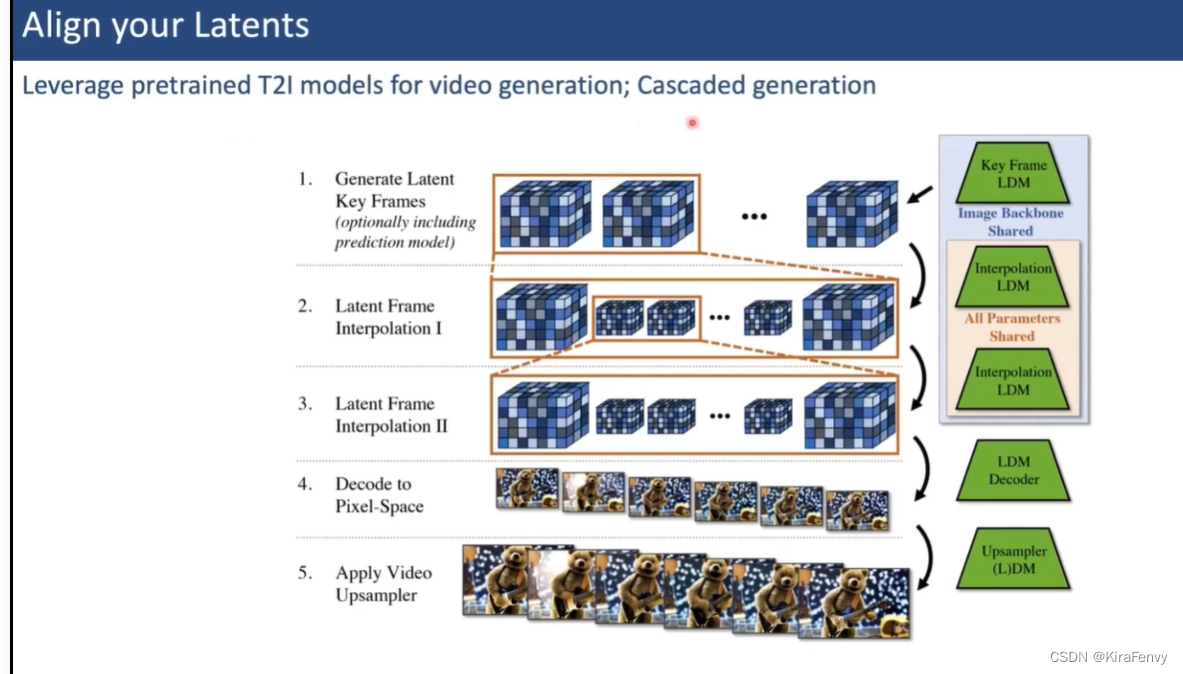

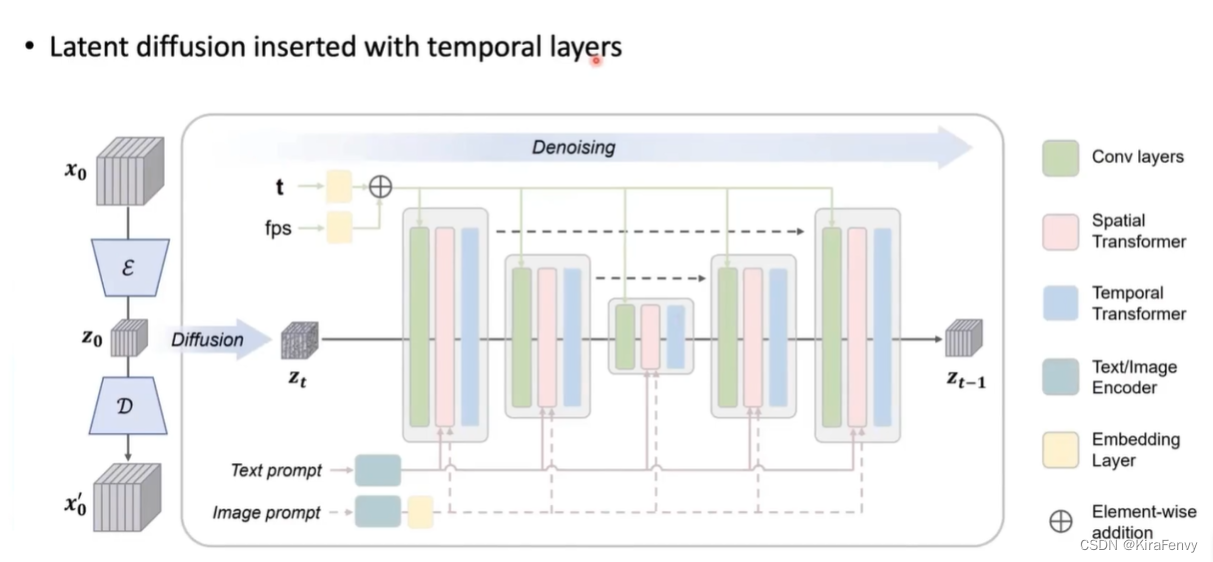

Align your Latents

开源视频生成模型

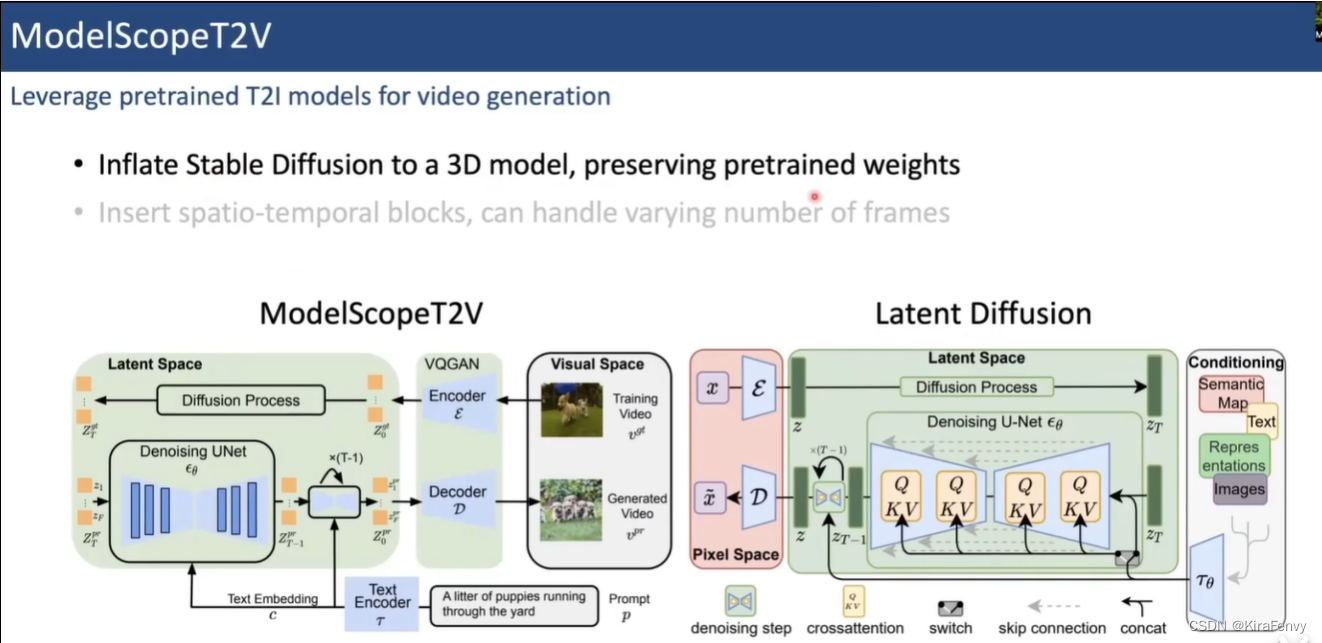

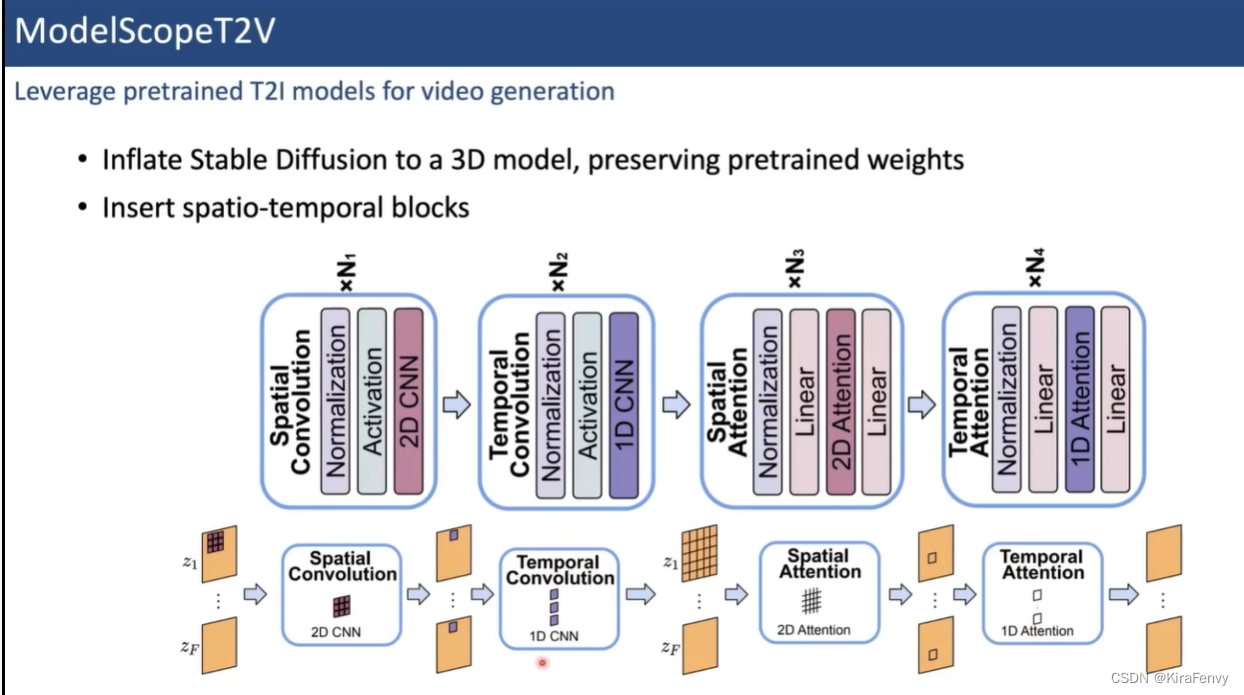

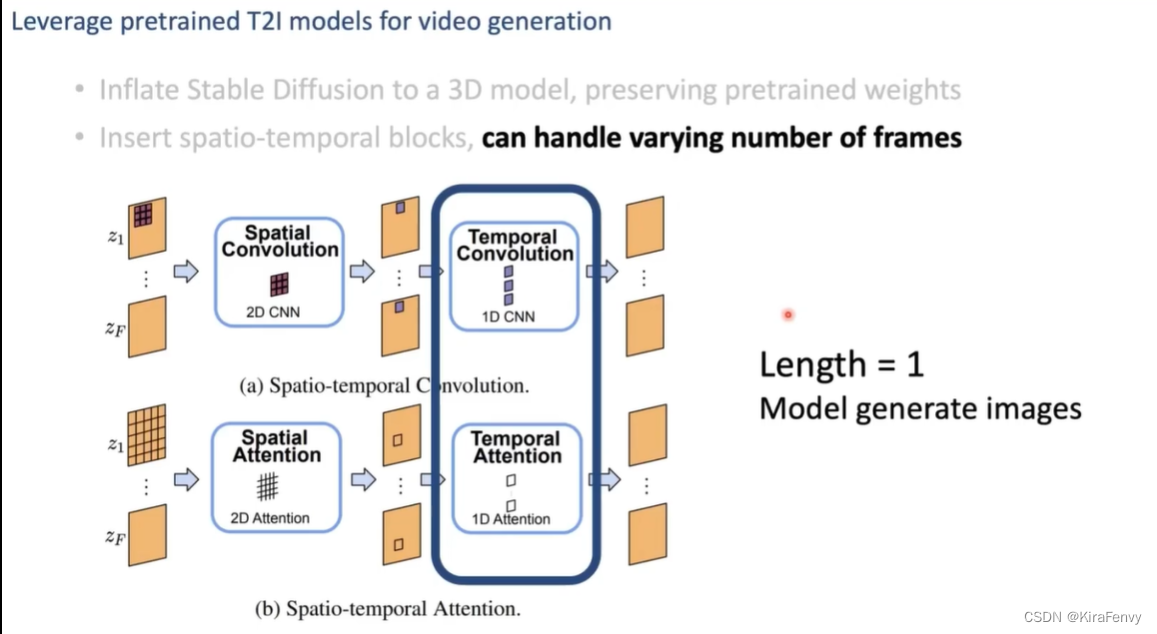

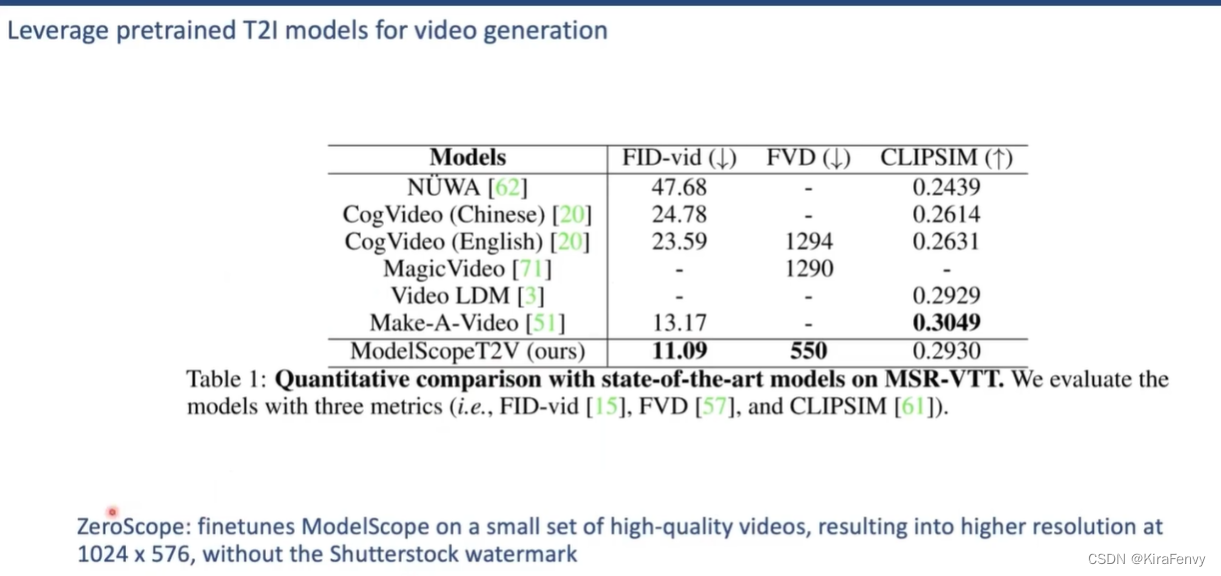

ModelScopeT2V(阿里)

可变temporal attention

下面是模型效果,ZeroScope是从ModelScope 用10K的小数据集fine-tune出来的

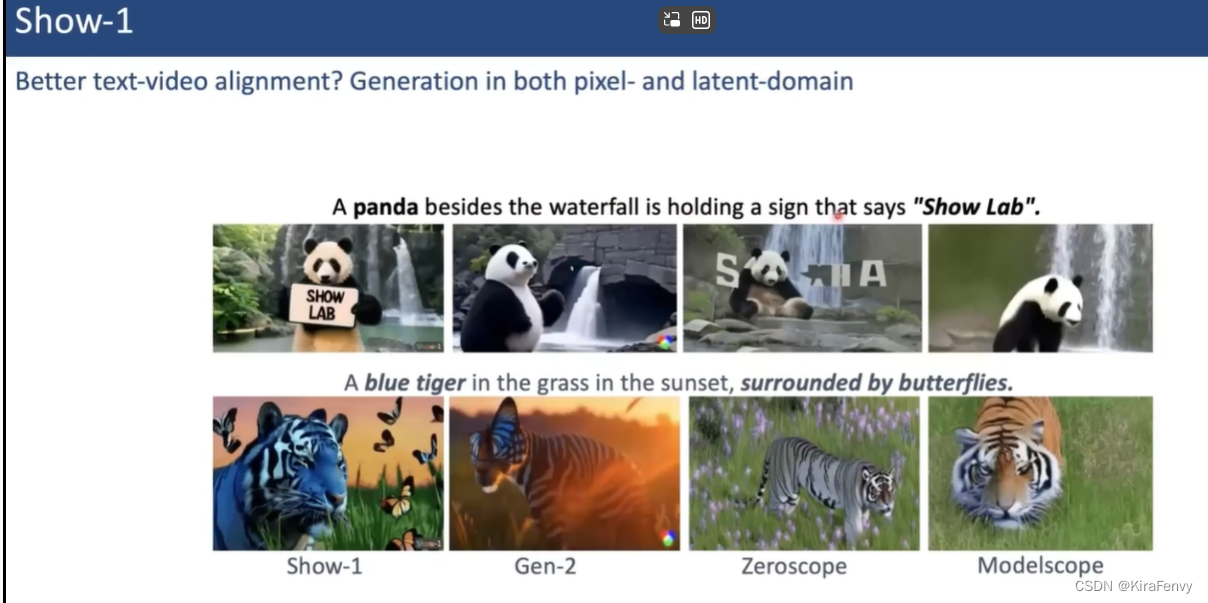

Show-1

VideoCrafter(tx)

LaVie

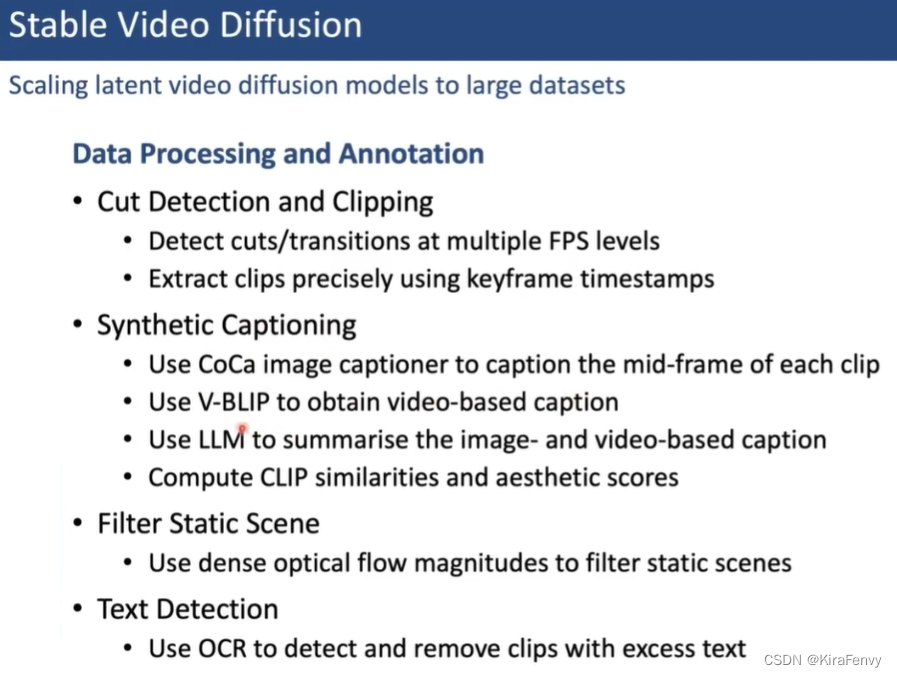

Stable Video Diffusion

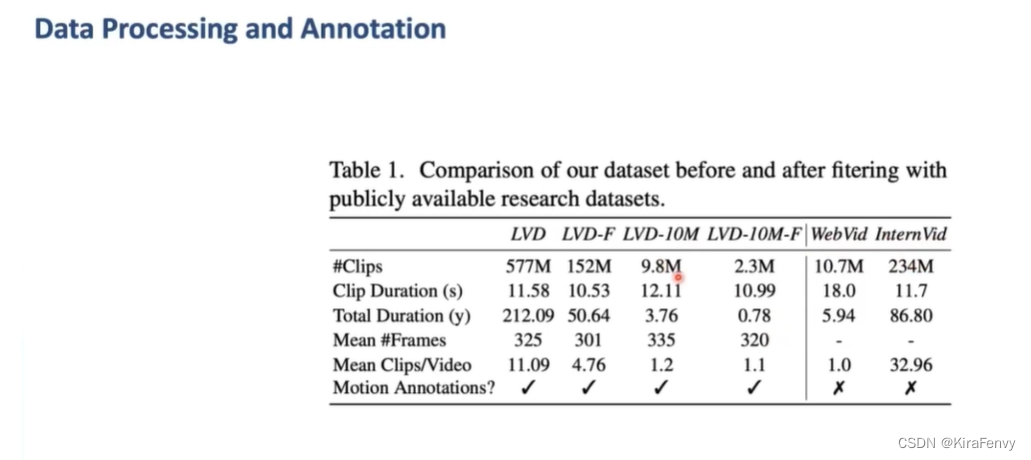

数据处理

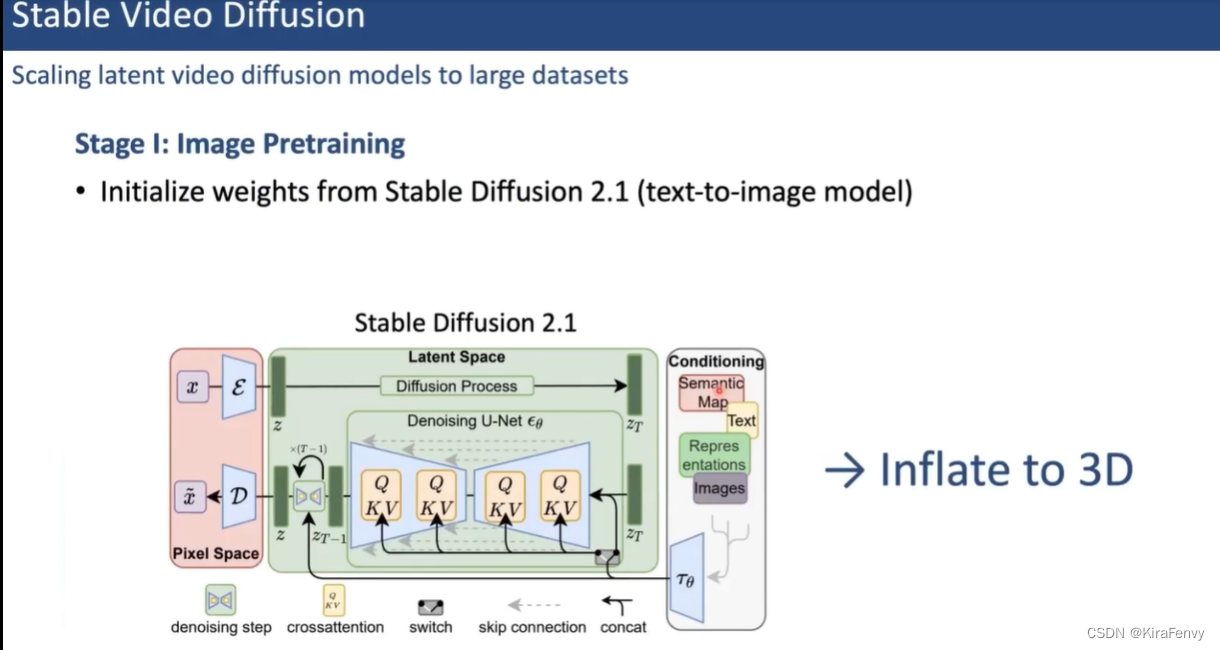

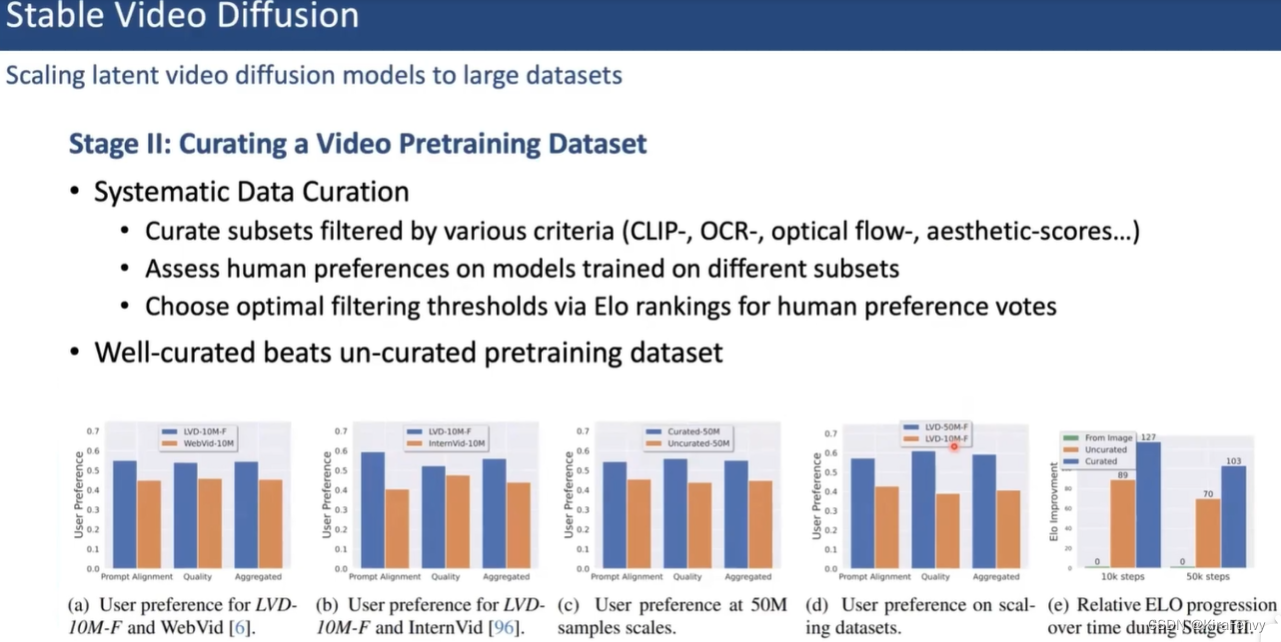

训练过程:

先初始化参数

训练过程

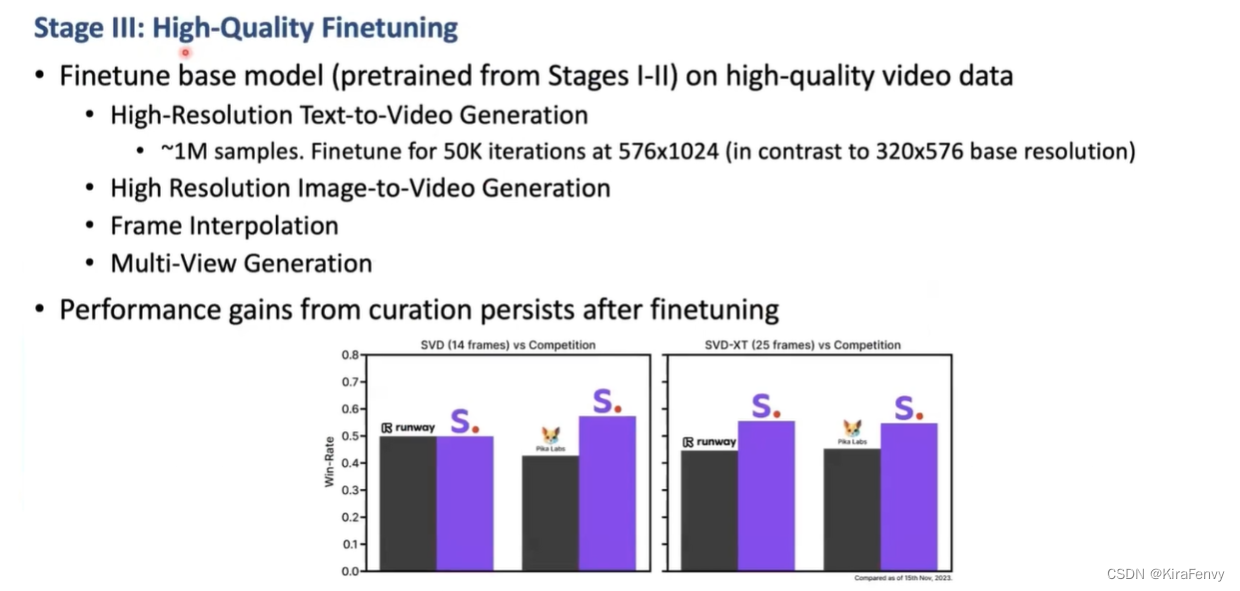

fine-tune阶段

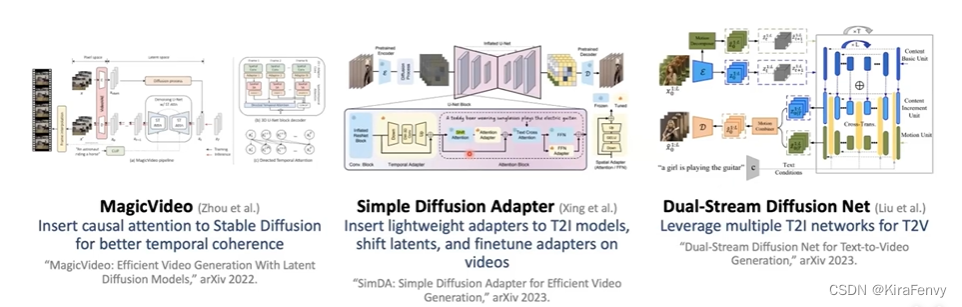

高效的生成方法

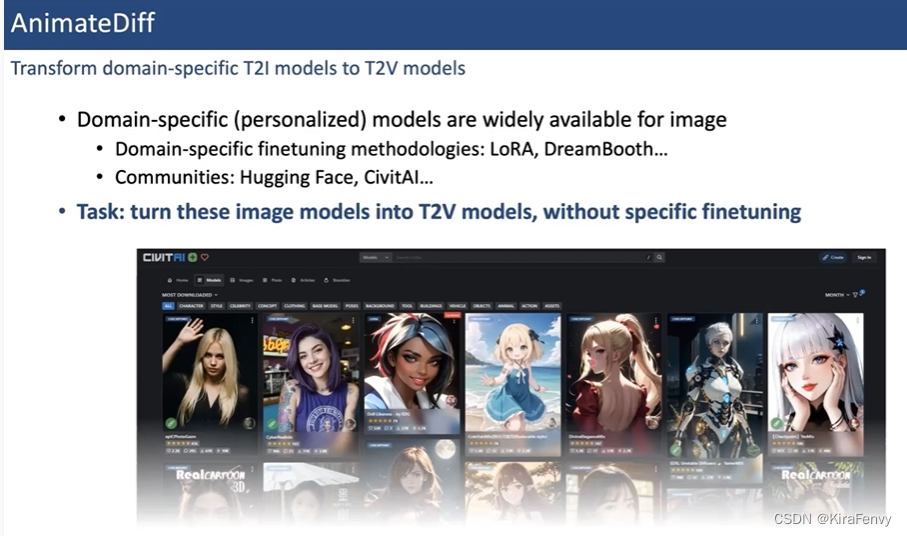

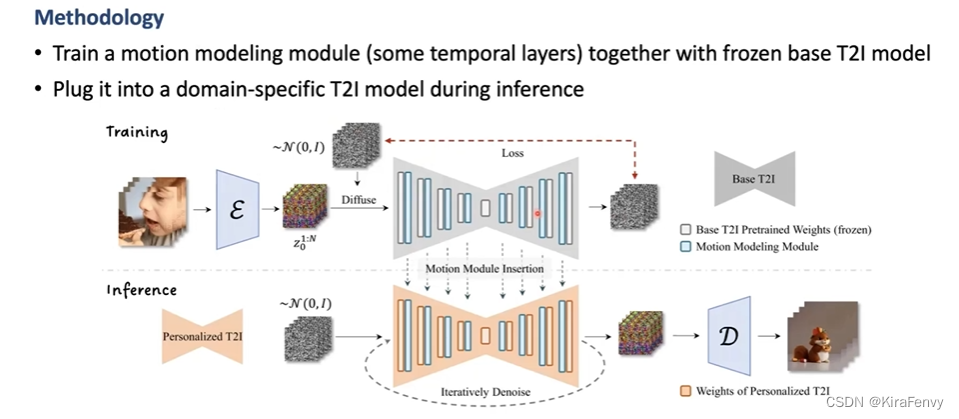

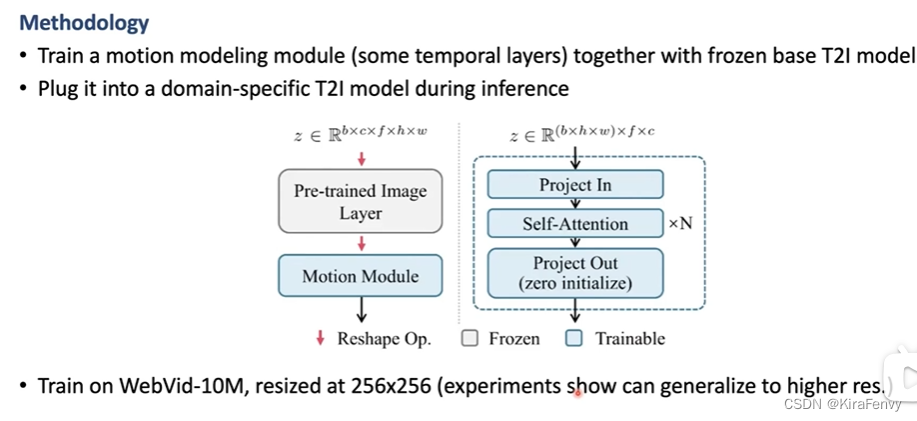

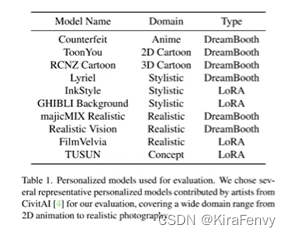

AnimateDiff

把文生图片模型转化为文生视频模型而不需要单独train

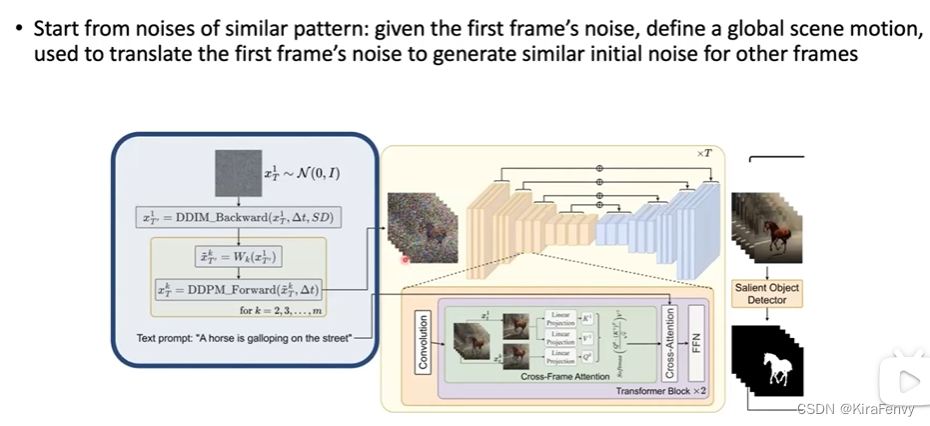

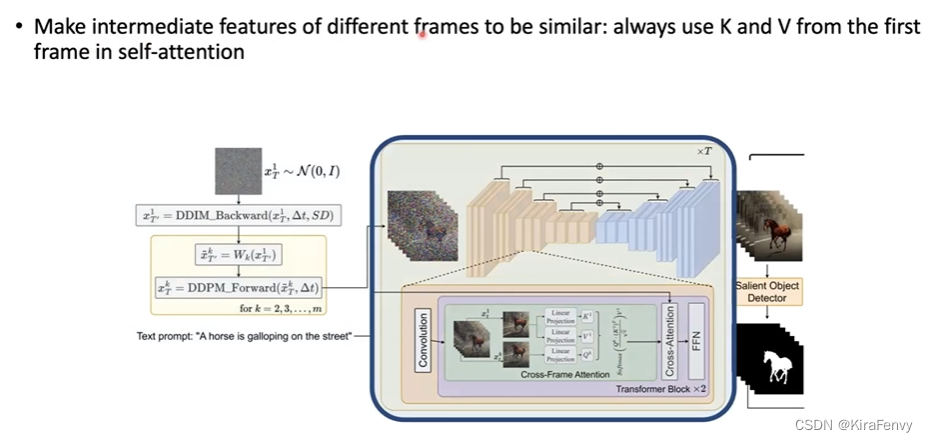

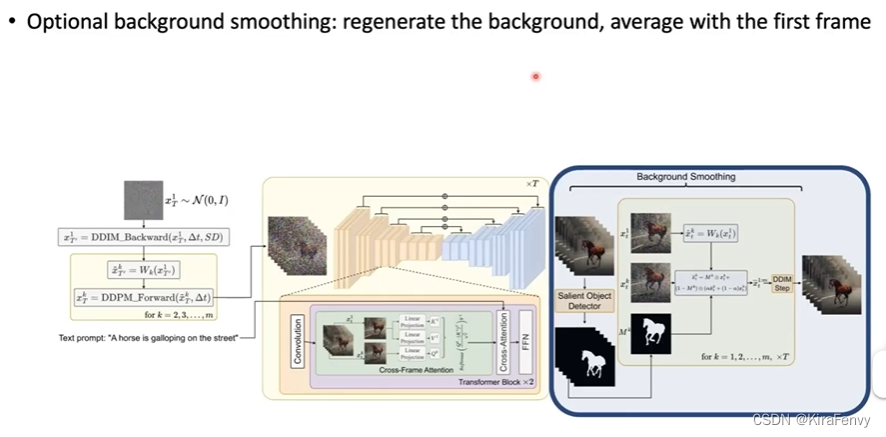

Text2Video-Zero 无需训练

动机:如何在不用fine-tune的情况下使用Stable Diffusion

做法:给定第一帧noise后,人为定义全局scene motion

其他

Storyboard

前面生成的视频都是几秒钟长度的视频,如果时间要增长,有哪些工作做了

文本->电影脚本->视频

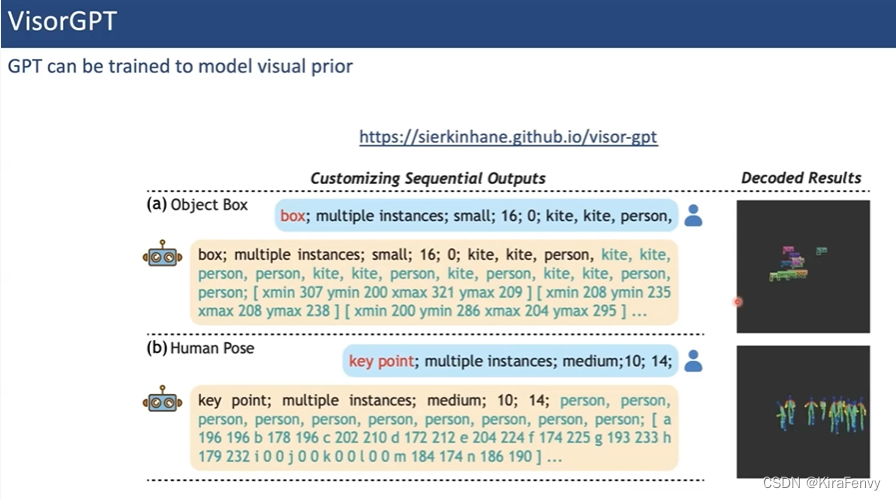

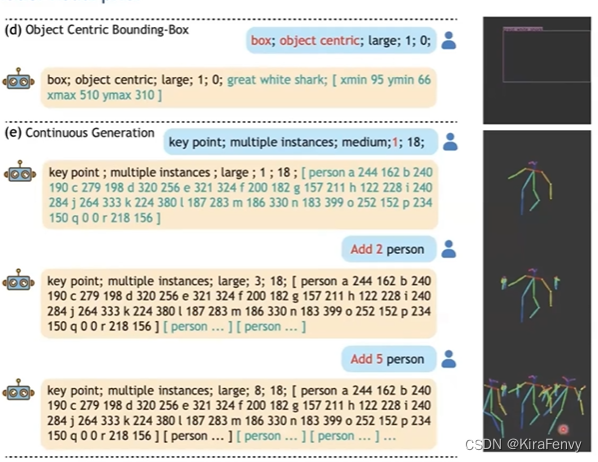

VisorGPT

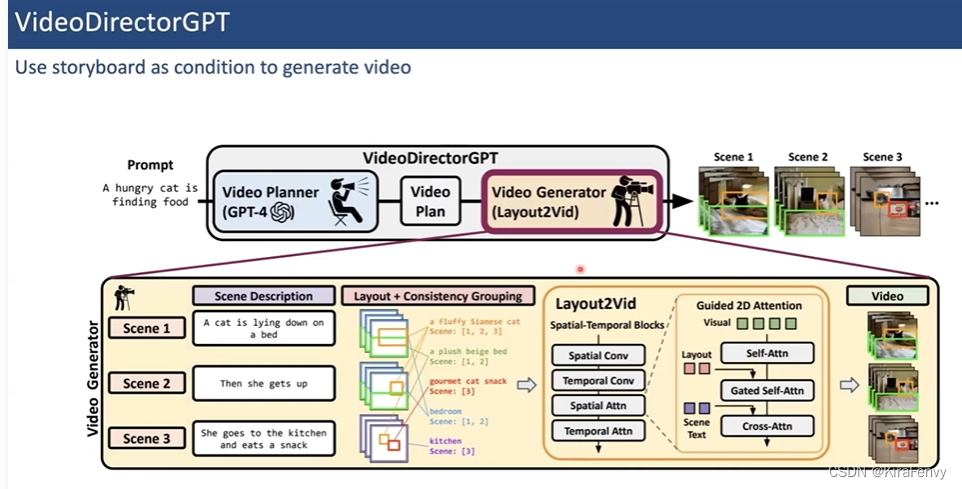

VideoDirectorGPT

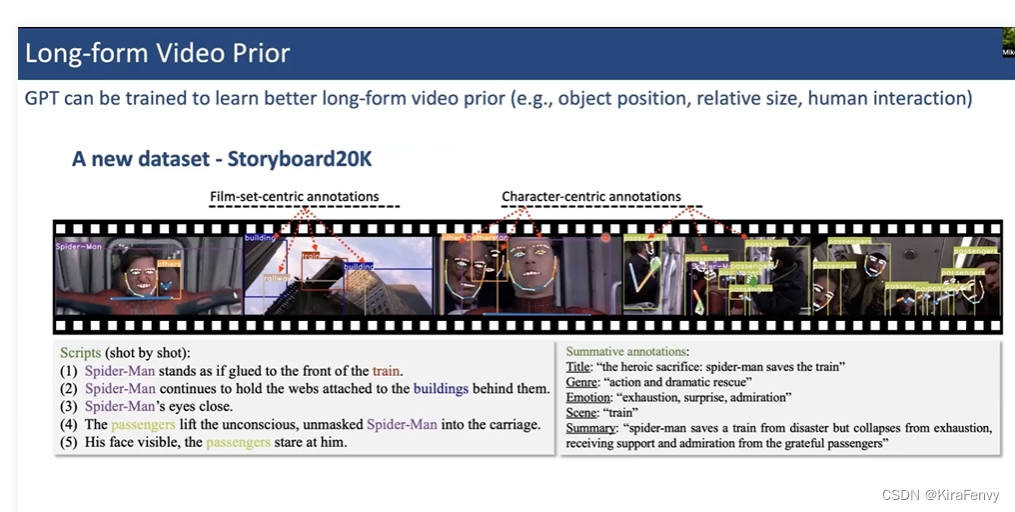

Long-form Video Prior

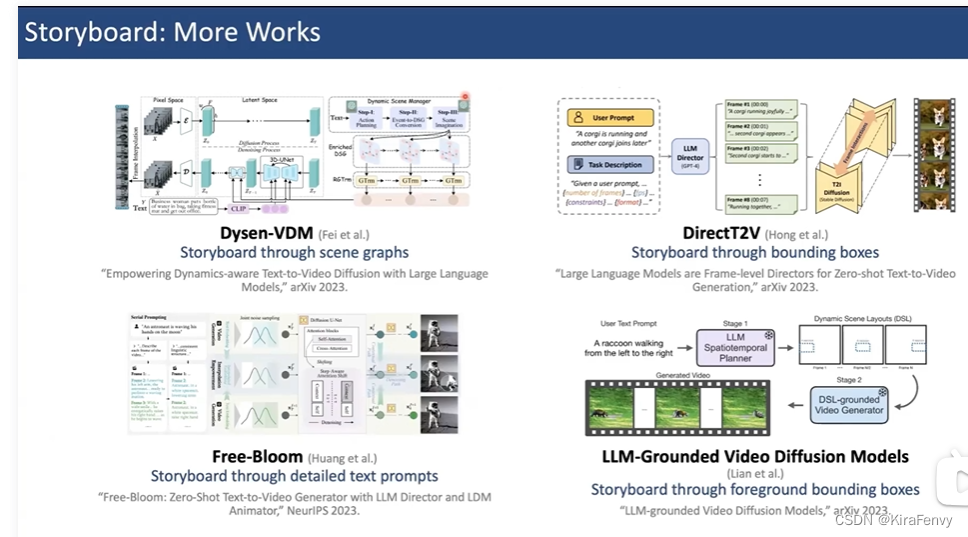

其他工作

长视频生成

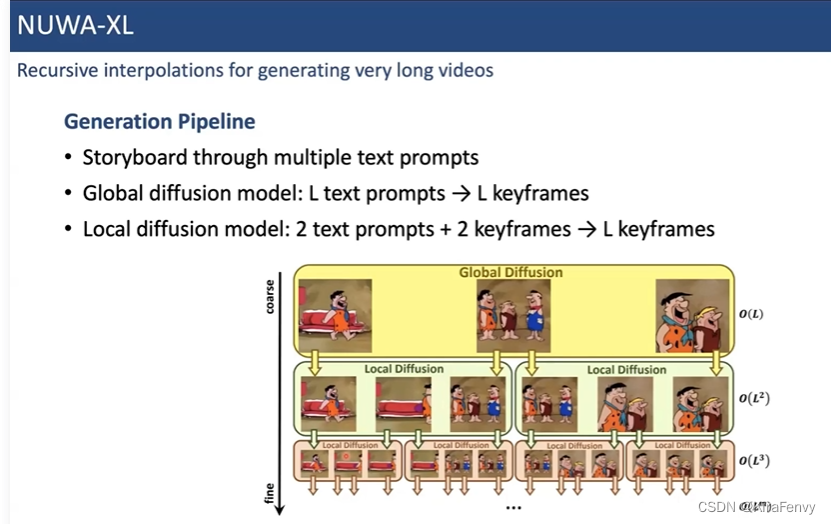

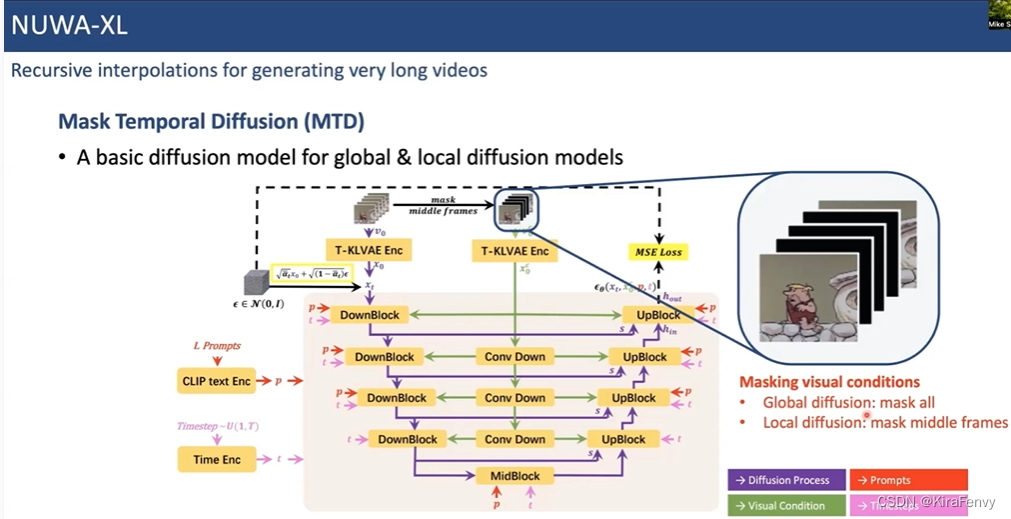

NUWA-XL

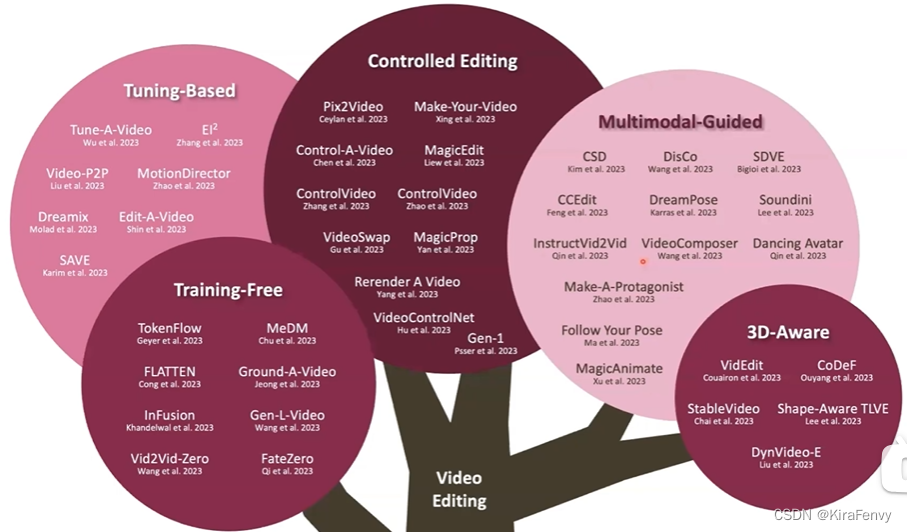

Video Editing

Tuning-based

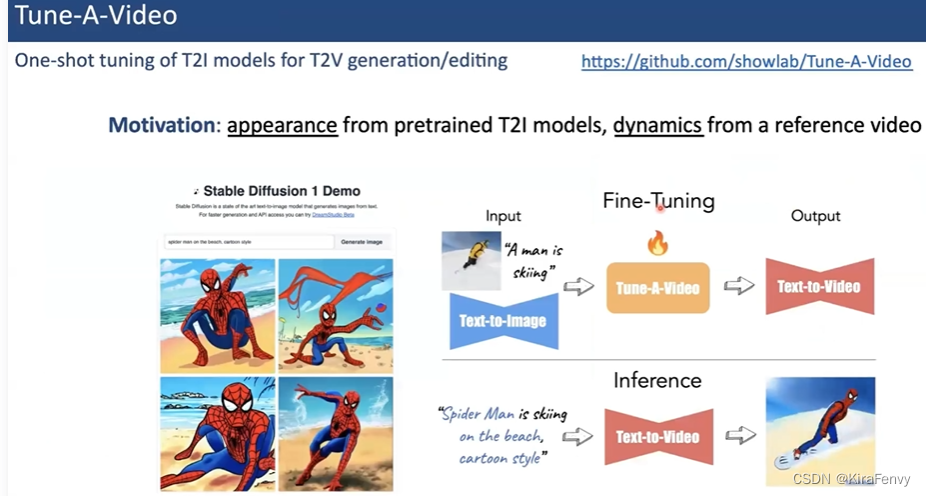

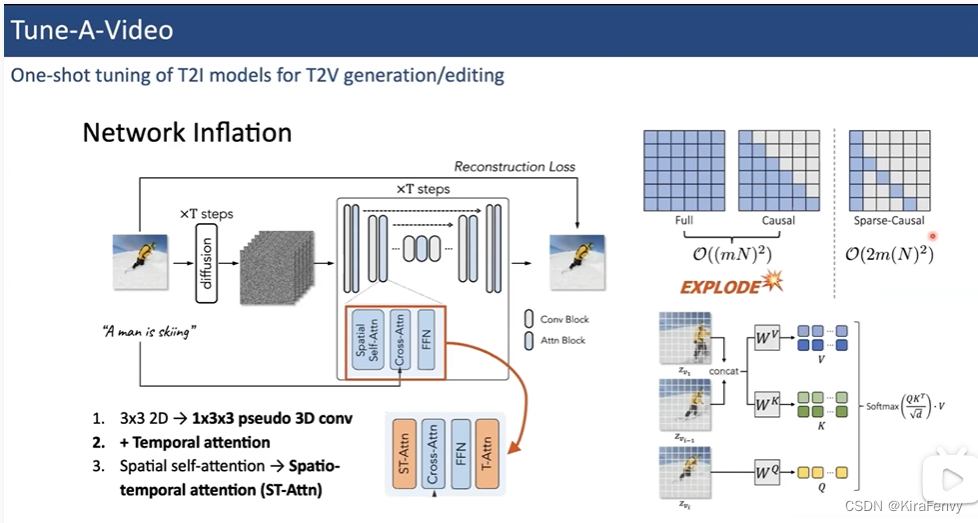

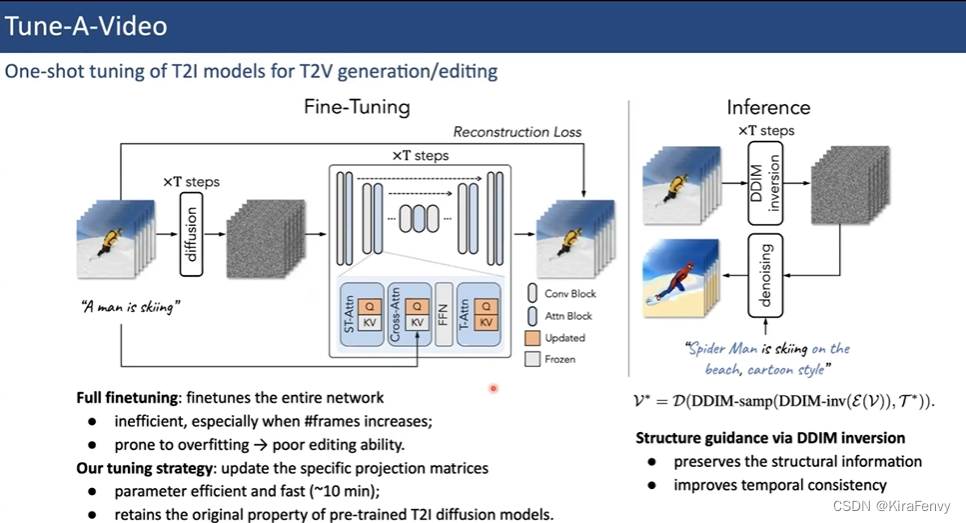

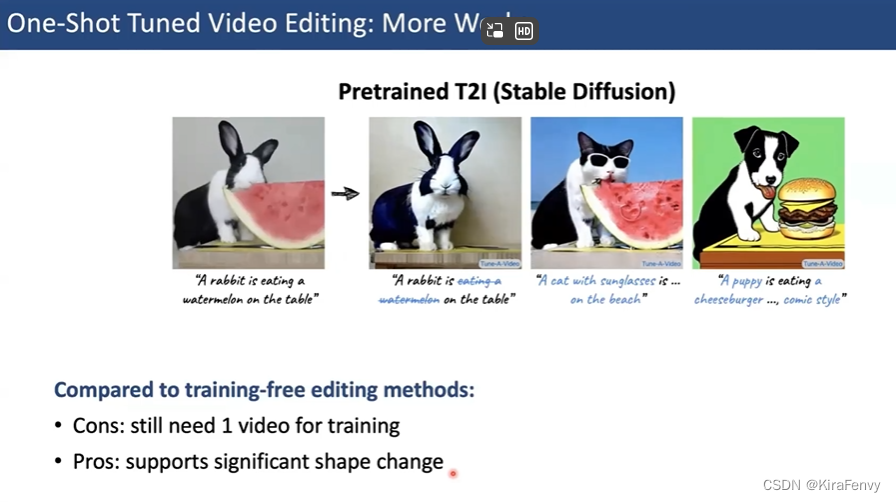

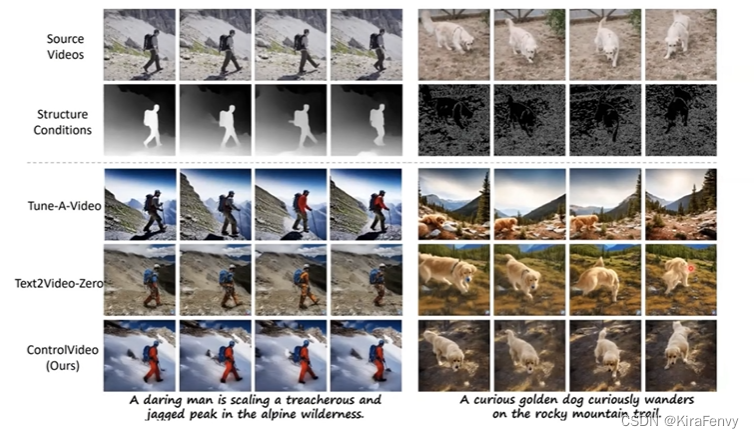

Tune-A-Video

Sparse-Casual的attention方式节约内存空间,只跟第一帧和前一帧做attention

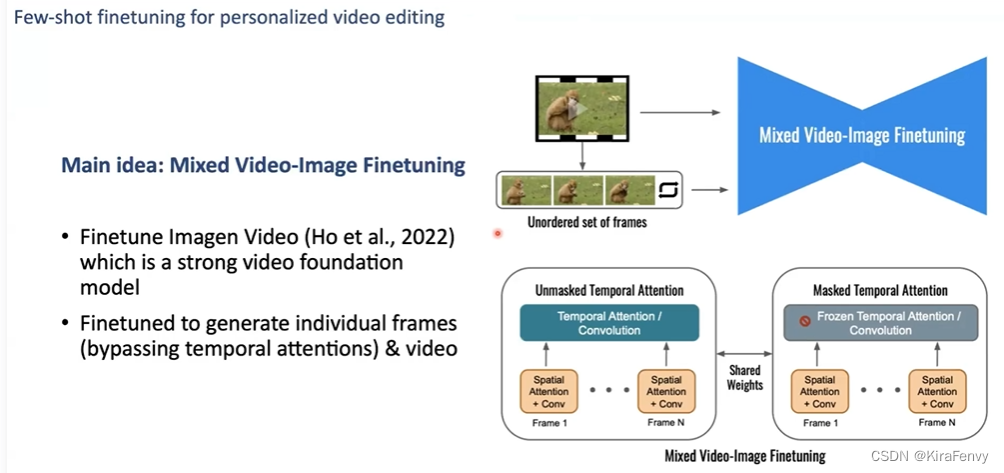

Dreamix

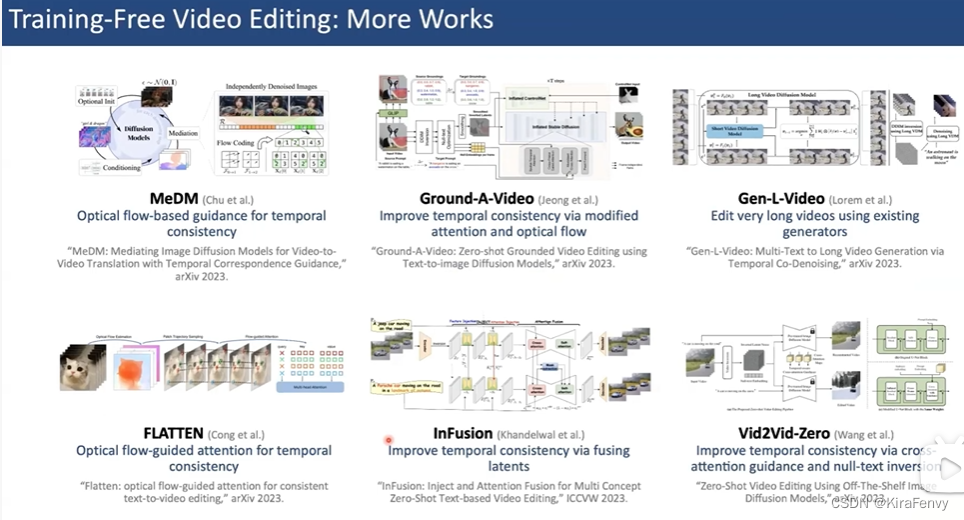

Training-Free

TokenFlow

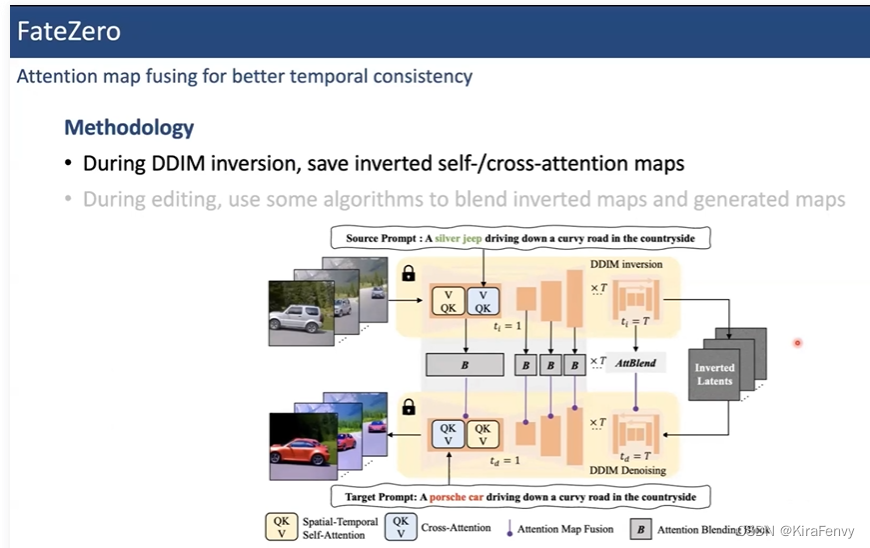

FateZero

其他工作

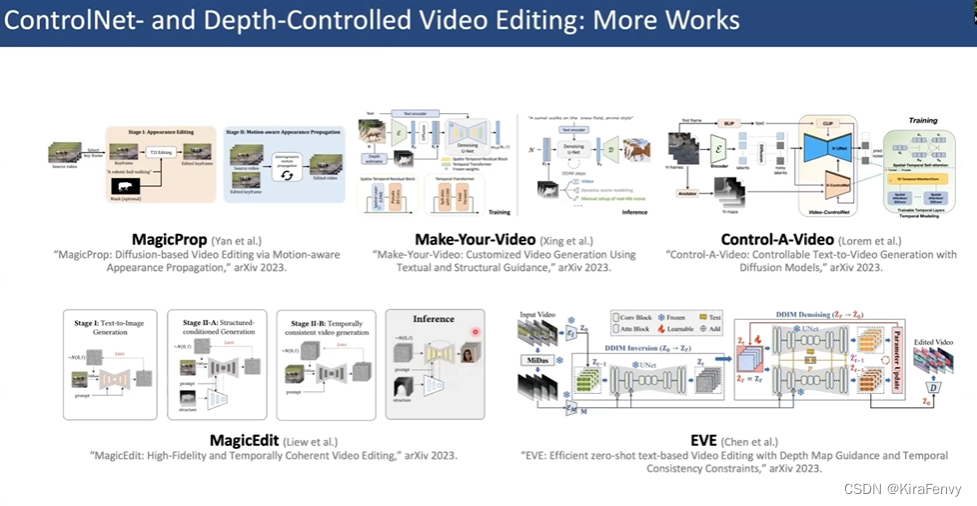

Controlled Editing

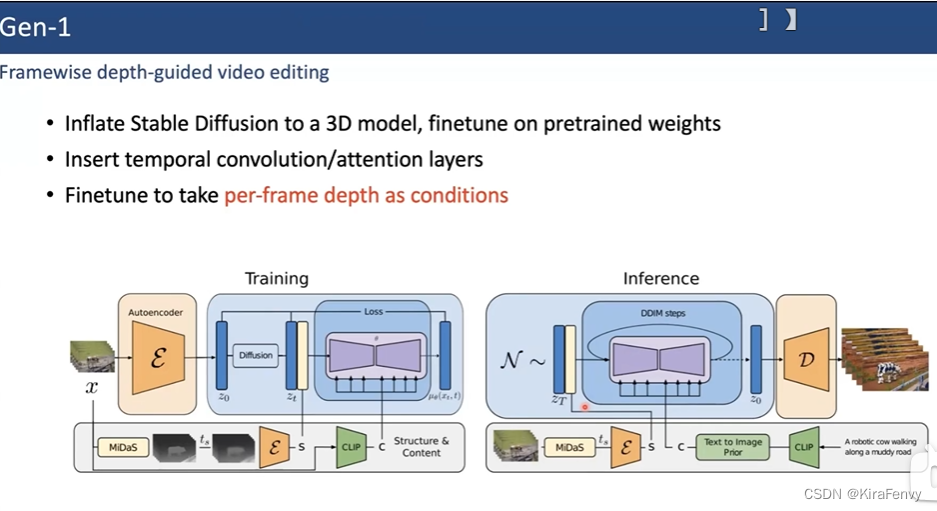

Gen-1

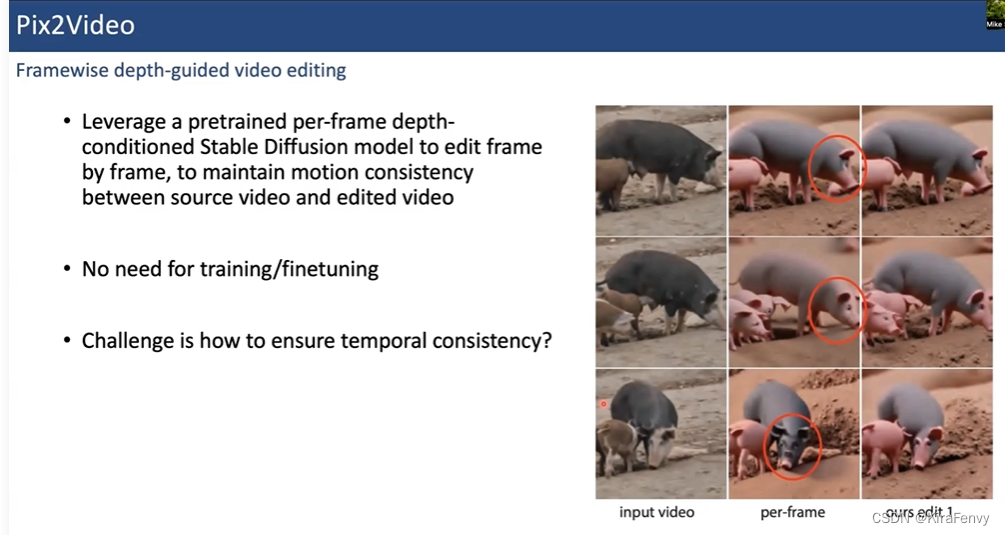

Pix2Video

Control场景里也有不需要训练的方法

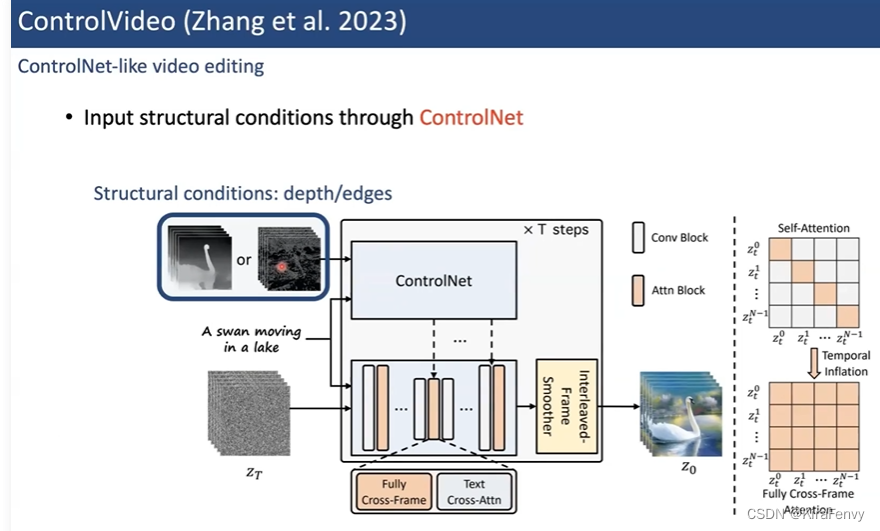

ControlVideo

另外一种不需要训练的方法

VideoControlNet

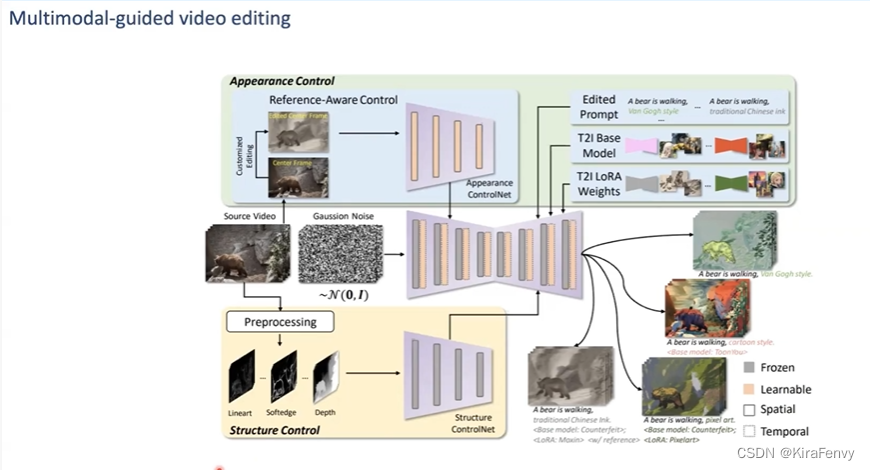

CCEdit

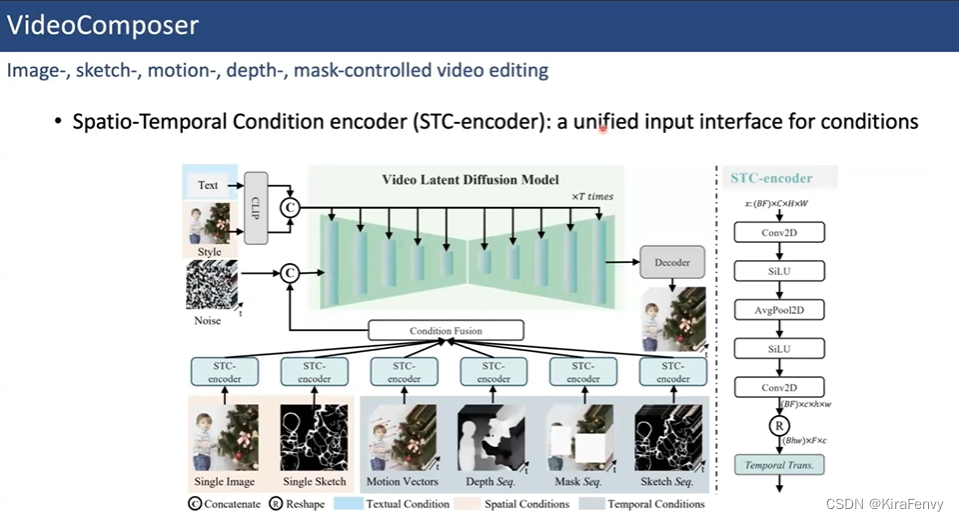

VideoComposer

其他工作

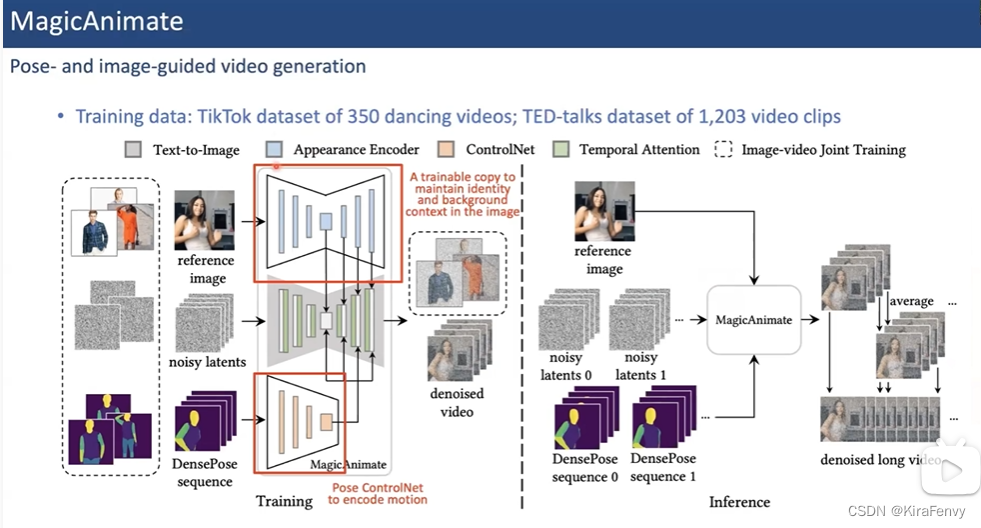

Pose Control姿态控制

MagicAnimate

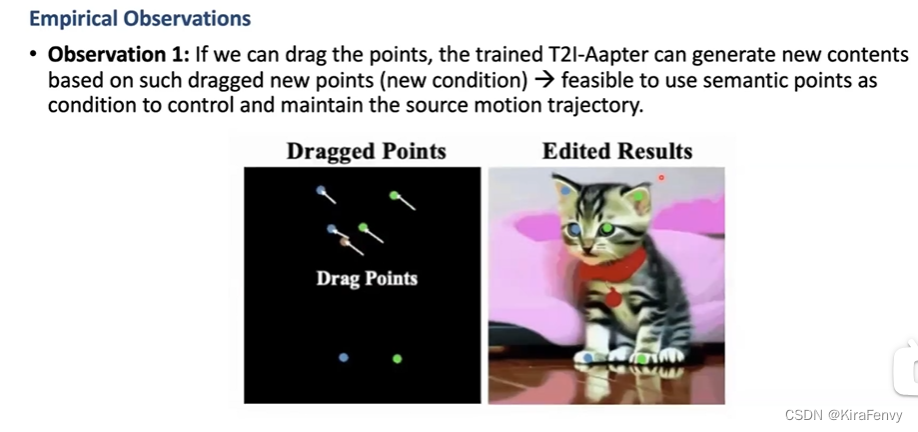

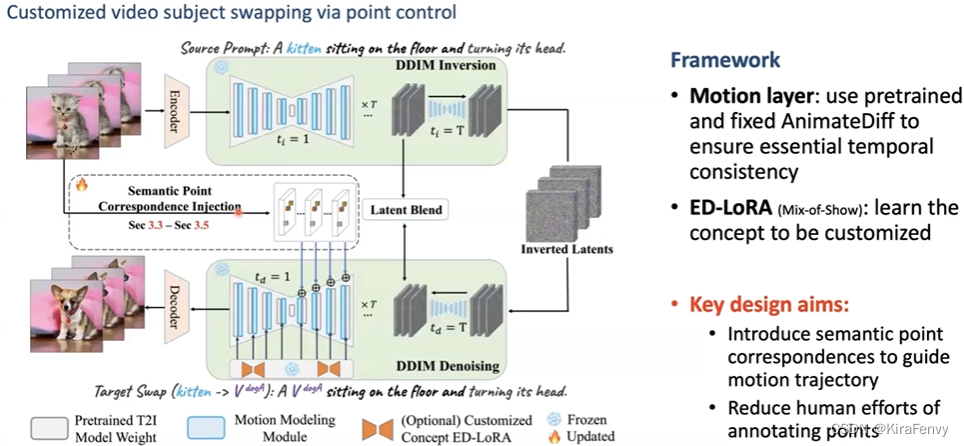

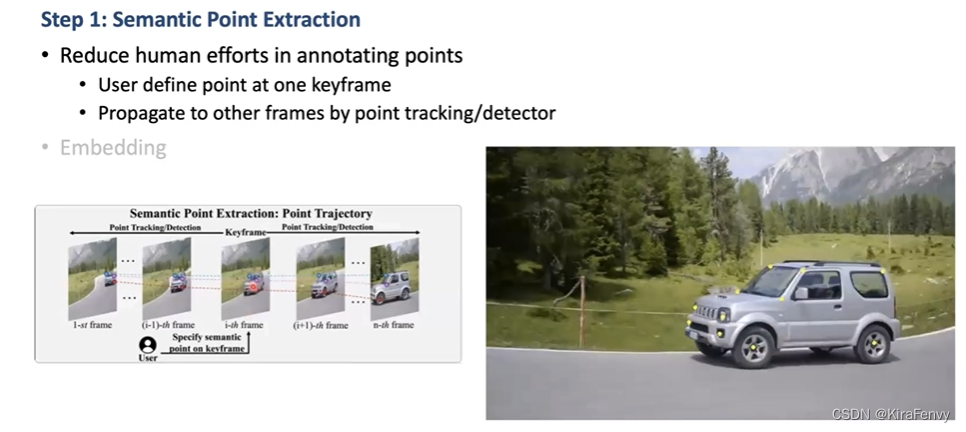

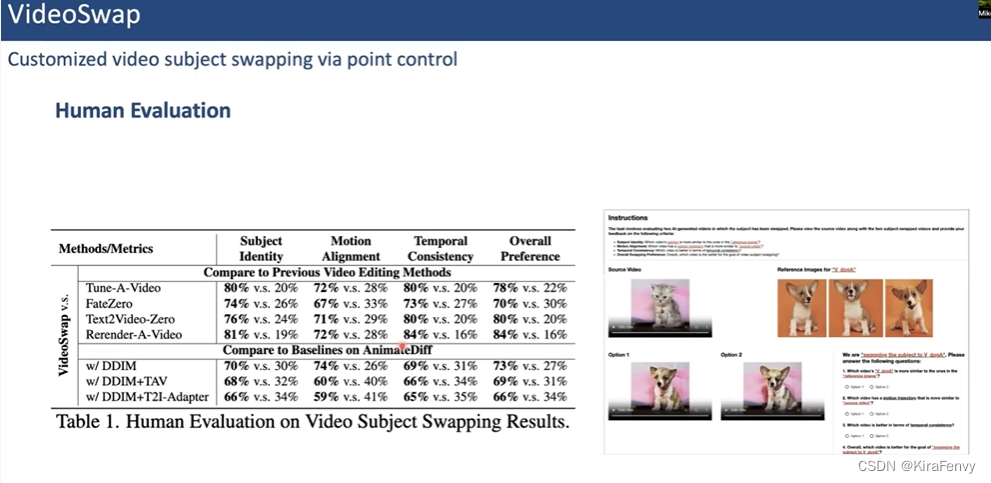

PointControl

比如图中想把猫换成狗但是背景保留

只在关键帧标注

3D-Aware

原文地址:https://blog.csdn.net/m0_51371693/article/details/136478507

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!