论文学习笔记1:Federated Graph Neural Networks: Overview, Techniques, and Challenges

文章目录

- 一、introduction

- 二、FedGNN术语与分类

- 三、GNN-ASSISTED FL

- 四、FL-ASSISTED GNNS

- 五、FL Clients With the Same Nodes

- 六、FL Clients With Different Nodes but the Same Network Structure

- 七、FL Clients With Different Network Structures

一、introduction

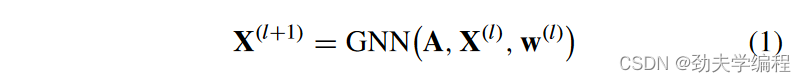

GNN作为一共深度学习模型,主要是用于对图数据进行特征嵌入和推理,通过聚合其他相邻结点的信息来更新给定节点的嵌入。

A是图邻接矩阵,w是第l层的可训练模型权重

FL作为一种协同ML范式,主要有横向FL(HFL)和纵向FL(VFL)。

HFL中客户端样本空间重叠小,特征空间重叠大。

VFL中客户端样本空间重叠大,特征空间重叠小。

在HFL中FL主要有两种设置,集中FL和分散FL。集中FL是服务器协调客户端共同学习模型,分散FL则是客户端在没有集中服务器的情况下互相通信共同学习模型。

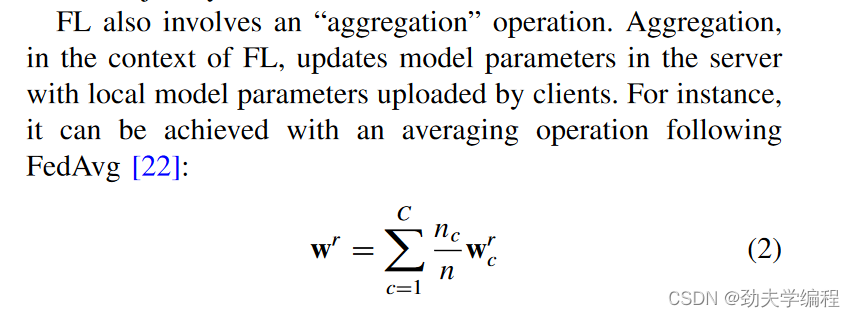

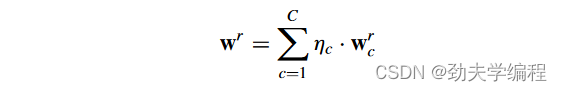

涉及聚合操作的主要使用FedAvg,如上图公式。

二、FedGNN术语与分类

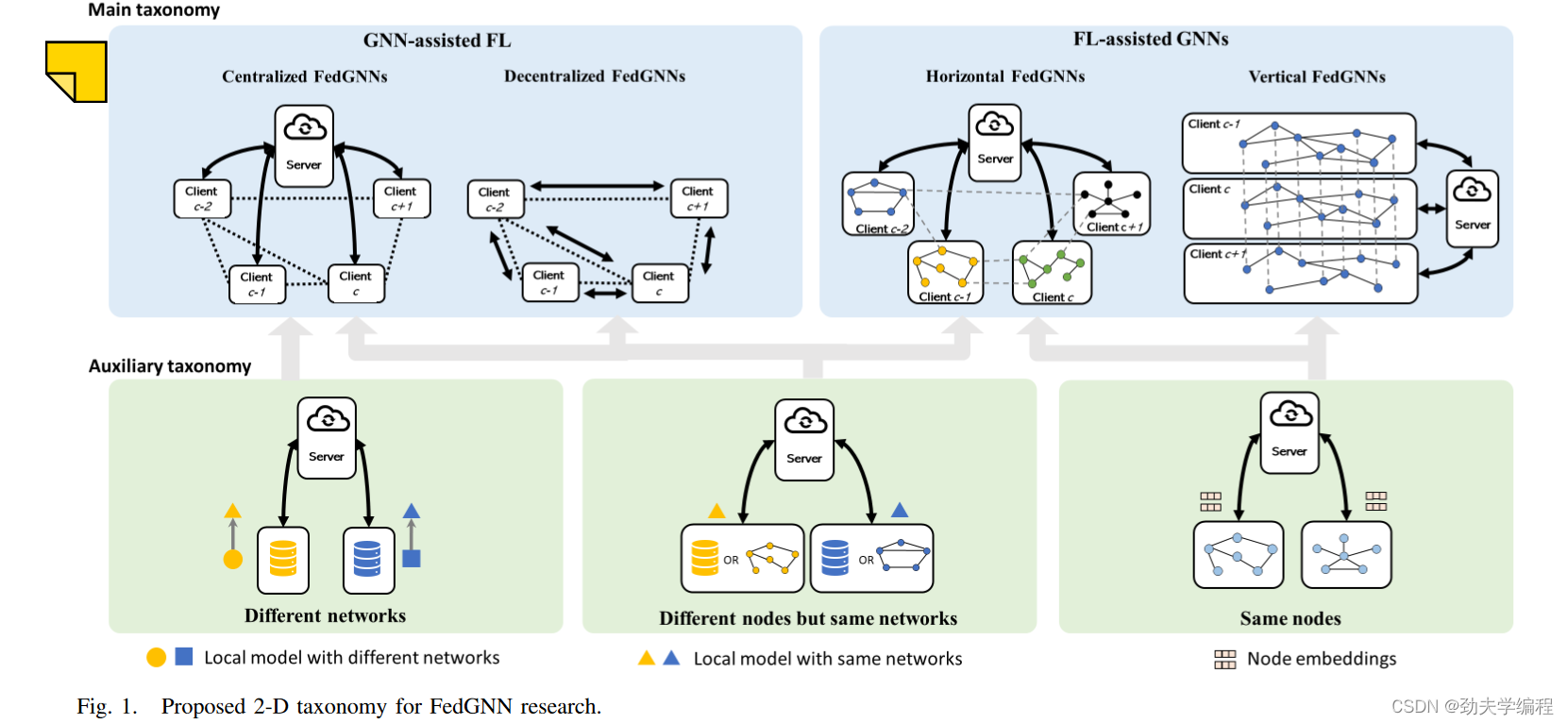

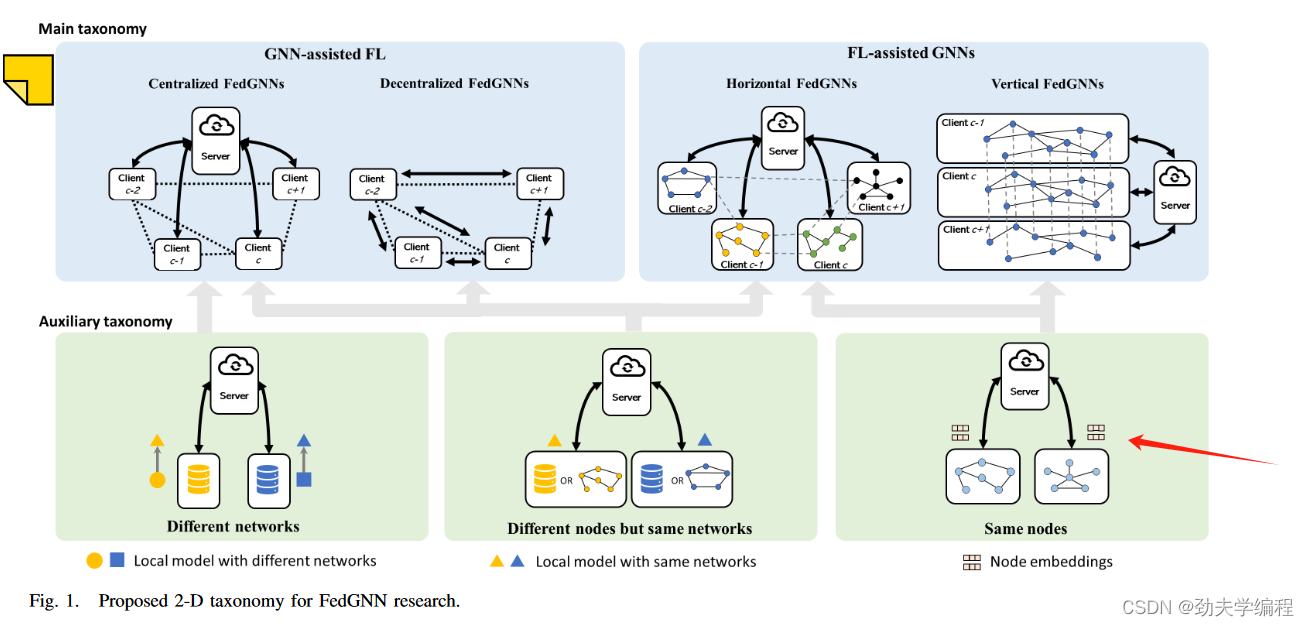

现阶段FedGNN分类法主要有两类:

1.主要分类法——侧重FL和GNN的集成

2.辅助分类法——侧重FL聚合,处理不同级别的图数据异质性

2.1主要分类法

这里主要介绍主要分类法的两个类别,GNN辅助FL和FL辅助GNN

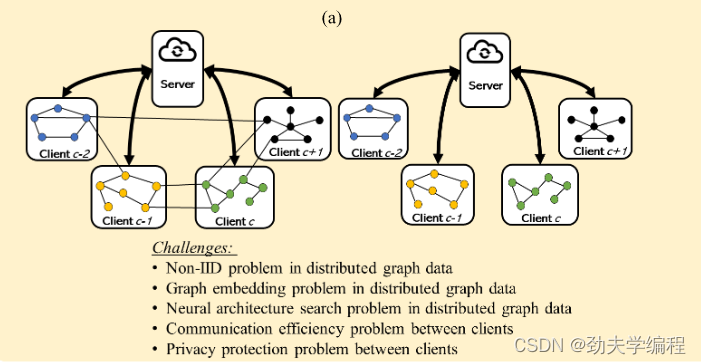

GNN-Assisted FL

GNN-Assisted FL这种情况主要是针对没有显示图,但存在隐式图,比如可以表示客户端之间连通性网络的隐式图。

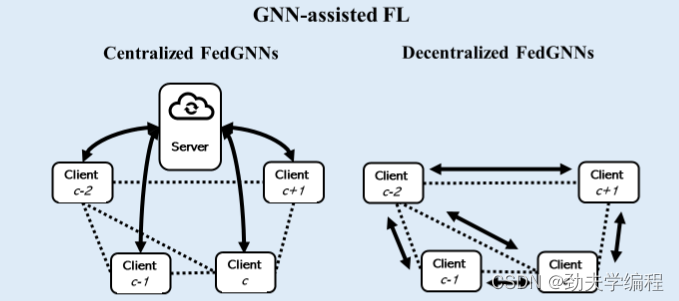

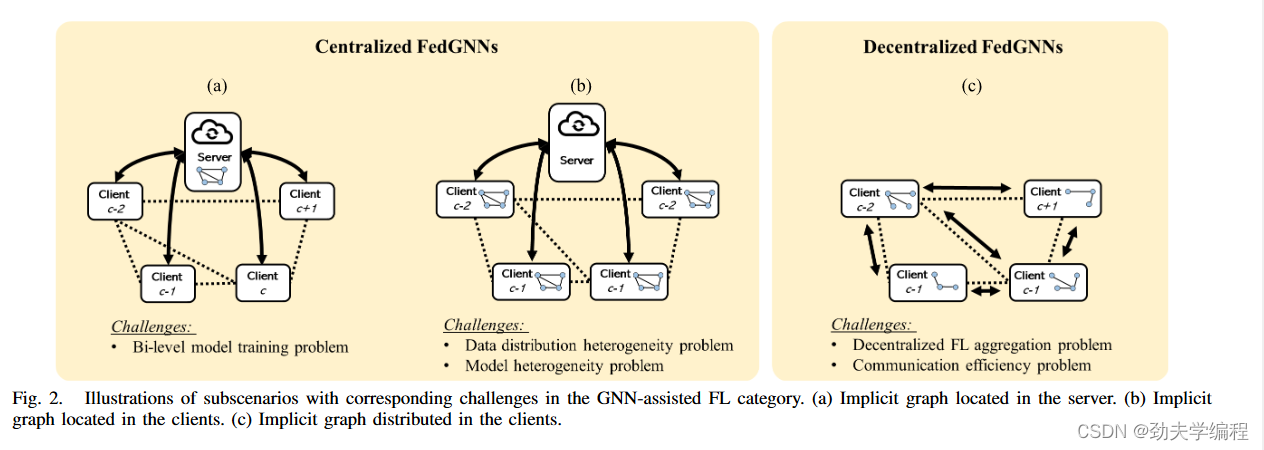

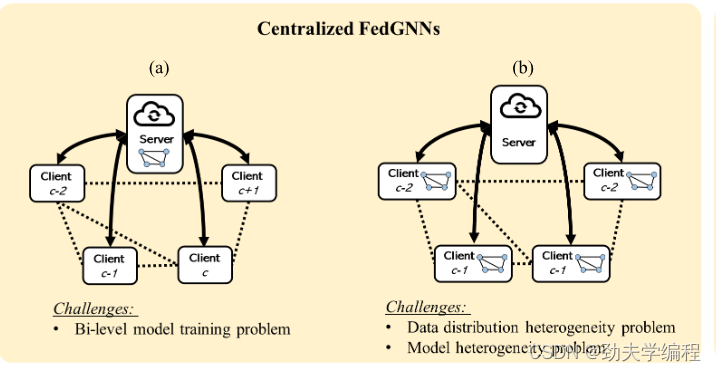

在GNN-Assisted FL中,FL训练模型是主要任务,因为客户端的本地数据也不一定是图数据。该类别下工作可以进一步分为Centralized FedGNN和DeCentralized FedGNN。主要区别就是是否有一个中央服务器来协调客户端工作。

FL-Assisted GNNs

这类方法主要是客户端有显式图数据并且客户端之间相互孤立。这时GNN就需要FL来帮助进行模型训练。

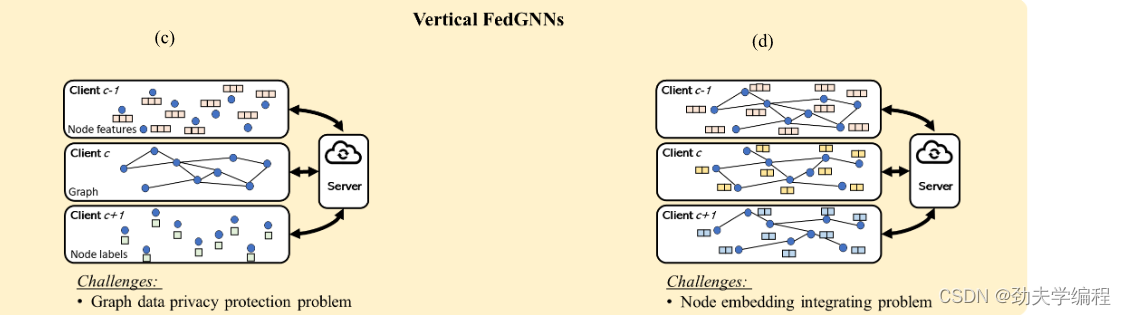

然后根据图节点ID跨客户端的重叠规模进一步细分位水平型FedGNNs和垂直型FedGNNs。如上图。

2.2辅助分类法

辅助分类法侧重于处理FL客户端之间的异构性。它们可以分为三类:

(1)具有相同ID的节点的客户端

该种类型是将节点嵌入特征上传到FL服务器进行聚合。这种类型在垂直型和水平型FedGNN都有用到。

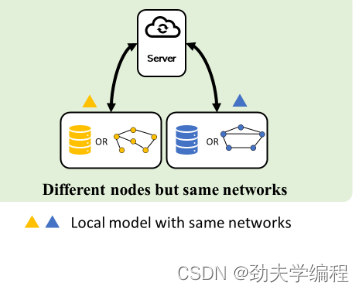

(2)具有不同节点但网络结构相同的客户

该类使用模型权重和梯度进行FL聚合。常应用在GNN辅助的FL和一些没有重叠节点的水平FedGNN工作的两种场景。

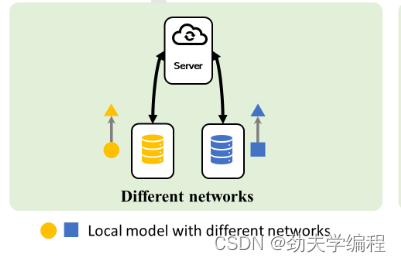

(3)采用不同网络结构的客户端。

对于具有不同网络结构的客户端训练局部模型,首先可以将网络结构建模为图,并将GNN模型应用到其中。然后,GNN模型的权重或梯度可用于FL聚合。目前,这只应用在集中式的FedGNN工作中。

三、GNN-ASSISTED FL

在GNN-ASSISTED FL中主要是处理含有隐式图信息的FL系统。

这种隐式信息主要源自客户之间的图,还有深度神经网络的层连接。比如相距较近的道路传感器往往会记录类似的交通情况。

这种客户间的图可以由具有图结构的客户端构建,如上图,每个客户端为图中一个节点。一个客户间图可以由这些具有图结构的客户端构建,其中每个客户端表示为图中的一个节点,如图2中的黑色点线所示。

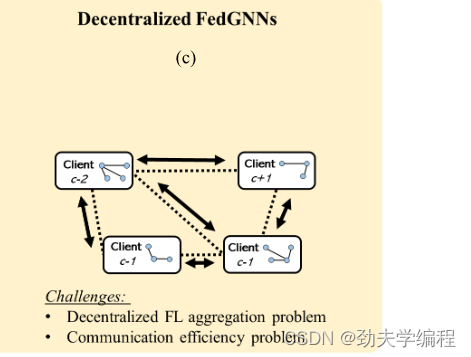

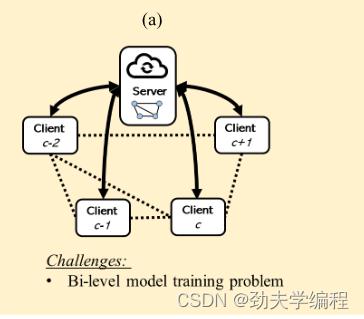

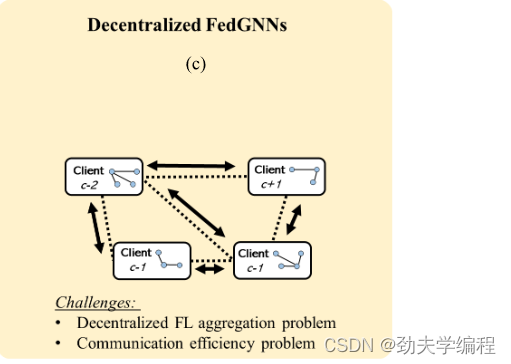

根据FL系统中是否存在中心服务器,GNN辅助的FL有两种场景:集中式FedGNNs和分散式FedGNNs。

如上图所示,由于集中式的FedGNNs同时具有服务器和客户端,根据隐式图的位置,生成两个子场景:

(1)位于服务器的隐式图

(2)位于客户端的隐式图

而在没有中心服务器的情况下,去中心化FedGNNs中的隐式图只能分布在客户端之间。如下图所示:

3.1Centralized FedGNNs

位于服务器的隐式图:

用客户间图在服务器中训练一个GNN模型。它假设邻近的客户端倾向于具有相似的局部模型或特征嵌入。

服务器首先像在标准FL中一样从客户端收集参数。将上传的局部模型参数作为客户间图中的节点特征。然后,利用上传的参数训练一个GNN模型,以方便FL聚合。

最后,将更新后的参数返回给客户端。客户间图可以事先给定,也可以在训练时使用自注意力模块提取。由于服务器拥有单独的GNN模型,如何在服务器中同时训练本地模型和GNN模型(双层模型)是一个挑战。

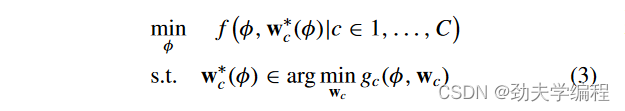

对于双层模型训练

有人提出了用两类目标函数训练局部模型和GNN模型:客户端用于训练局部模型的局部任务目标函数gc ( · )和FL服务器用于训练GNN模型的目标函数f ( · )

其中φ表示GNN模型中的可训练参数,w ? c ( φ )是客户端c的局部解权向量。

还有人提出了使用独立的目标函数依次训练局部模型和GNN模型

例如,客户使用不同的本地任务来训练本地模型。然后,服务器训练一个GNN模型来融合多任务局部估计。服务器中基于GNN的分组预测器被设计为根据客户数据分布相似性将客户聚类成组。同组内的客户协同训练,缓解异构性问题。

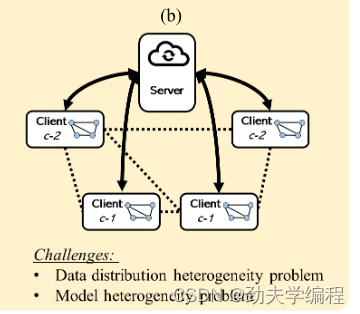

位于客户端的隐式图:

根据隐式图源,在客户端中训练GNN模型,以解决两个挑战:

1.数据分布异构性

该情况遵循一般的FL训练过程,由客户端协同训练GNN模型,并将模型权重上传到FL服务器。服务器进行FL聚合,并将更新后的模型权重分配给客户端进行下一轮训练。同时,在FL客户端构建不同的图可以解决不同问题

2.模型异构性

模型异构指的是在联邦学习系统中,不同客户端的本地模型结构和参数可能不同。

HAFL-GHN利用图神经网络(GNN)来解决这一问题。通过将神经网络转换为图并使用GHN模型进行训练,可以聚合异构的模型权重。

客户端只需上传本地GHN权重到FL服务器进行聚合,而不是上传整个本地模型权重。

这种方法通过利用基于图的表示和GHN,解决了联邦学习中模型异构性的问题,实现了不同本地模型的聚合。

3.2Decentralized FedGNNs

去中心化的FedGNNs没有中心服务器来协调FL客户端,其中隐式图(客户间图)分布在客户端。

因此如果客户端只能与相邻节点进行通信。那么,如何进行去中心化的FL模型聚合是一个具有挑战性的问题。除此之外,如何与邻居进行高效的通信也是至关重要的。

1.分散式FL聚合问题:

现有主流有两种方法来解决由图拓扑结构关联的分散式FL聚合问题:

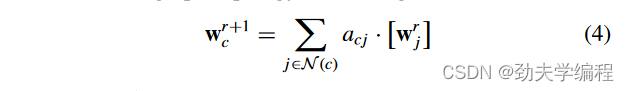

1 )通过对邻域内的模型更新进行加权求和来更新FL模型参数;

2 )通过图正则化来更新FL模型参数。在基于加权求和的方法中,FL客户端与邻居进行通信,并根据连接它们的图拓扑来聚合邻居的局部模型参数来更新它们的局部模型

ps:正则化是防止模型过拟合,也就是防止模型对训练过的数据表现很好,但是对没训练过的数据表现不好。

Wr+1c:是客户端c在第r+1轮训练的局部模型参数,可以是贝叶斯模型,也可以是GNNs。

[Wrj]:表示对Wrj进行数据加密保护

acj:表示图的邻接矩阵A中的[第c行,第j列]元素,它被假设用来反映客户端c和j之间的局部数据分布相似性。

N ( c )是c的邻域.

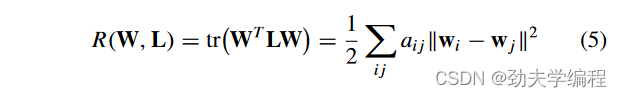

在基于图正则化的方法中,为了解决non-i.i.d. problem,图拉普拉斯正则化被引入到目标函数中,以使来自相邻客户端的模型参数相似。

ps:Non-i.i.d.问题指的是数据样本不是独立同分布的情况,比如数据样本之间存在某种相关性,不同客户端的数据可能具有不同的分布,因为它们来自不同的用户。

W:为相邻客户的模型权重

L:为邻客户端之间图拓扑的拉普拉斯矩阵

tr():为迹运算

aij:为连接客户i和j的邻接矩阵中的边权重

wi:表示客户i中的模型参数。

通过这种方法,模型能够更好地处理非独立同分布的数据,因为它强制来自相邻客户端的模型参数保持一致性,从而减少不同客户端之间数据分布差异对模型训练的不利影响。图拉普拉斯正则化提供了一种有效的手段来增强联邦学习系统的鲁棒性和泛化能力。

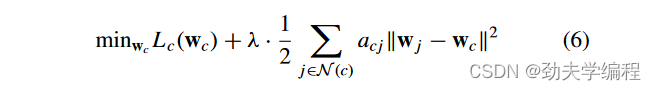

每个客户端的本地目标函数如下:

λ:表示平衡权重

N ( c ):表示客户c的邻域

Lc ( · ):表示客户c的局部损失函数

每个客户只能从自己的邻居那里获得相关信息。假设每个客户端有一个任务,并事先给定一个全连接的客户间图。一旦每个客户端从其邻居获得局部更新的模型,它将使用图正则化进行模型更新。

2.通信效率问题:

Rizk和Sayed提出了一种多服务器的FedGNN架构,以提高在处理大规模图时的通信效率。

它假设网络中存在多台服务器之间通过固定的图拓扑相关联,并且没有中心服务器协调服务器之间的网络。每个服务器下的客户端按照经典的集中式FL协议进行FL模型训练。一旦所有的服务器都聚合了自己的客户端的模型更新,它们之间就进行了服务器间的模型聚合。

PSO-GFML通过只与serv交换部分局部模型参数来提高通信效率。

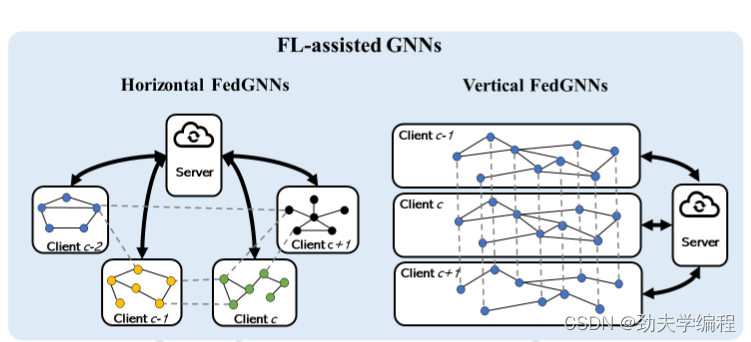

四、FL-ASSISTED GNNS

在FL辅助的GNNs这一部分中,处理具有显式图信息的FL系统,特别是孤立图数据。由于图数据的隔离性,FL算法作为一种新兴的处理具有隐私保护的分布式数据的工具,被应用于辅助GNN模型训练过程。

根据图节点ID跨客户端的重叠规模,FL辅助GNNs有两种场景:

1 )horizontal FedGNNs(水平FedGNNs)

2 )vertical FedGNNs(垂直FedGNNs)

4.1horizontal FedGNNs

水平型FedGNNs是指客户端中的孤立图数据共享相同的节点特征空间,但节点ID不同的情况。每个客户端至少有一个图或一组图。

ps:共享相同的节点特征空间,但节点ID不同的情况。举个例子,不同银行的客户交易数据,每个银行的数据独立但客户特征(如年龄、收入、交易历史)相同。

根据不同客户端中连接节点的边的丢失情况有如下两种:

4.1.1Clients Without Missing Edges

客户端拥有本地数据,并且没有丢失边的数据,如下图:

这种情况就是客户端之间连接节点的边被保留,如上图左。或者这些客户端之间原本就没有边数据,如上图右。

对于没有缺失边的客户端,常用的策略是先在客户端训练局部GNN模型来学习局部图表示或节点嵌入。然后,在其上应用FL算法。FL服务器收集来自客户端的模型参数或梯度进行FL聚合,并将更新后的参数返回给客户端进行下一轮训练。

4.1.1.1Non-i.i.d. problem

这里相关的研究问题主要集中在noni . i . d .问题

ps:Non-i.i.d.问题指的是数据样本不是独立同分布的情况,Non-independence,Non-identical distribution。

noni . i . d .问题在数据分布和图拓扑中都存在。

数据分布中的非独立同分布问题,包括属性分布和标签分布,与正常数据中的非独立同分布问题相同。

图拓扑中的非i . i . d .问题是指客户端之间的节点度、边权重、边类型或图结构的非i . i . d .分布。

大多数现有的FedGNN工作集中于前者,目前的主流解决办法有:基于模型的方法、基于数据的方法、基于FL聚合改进的方法。

基于模型的方法提高了局部模型的自适应性能,或者提供每个客户端的未来个性化学习一个强大的全局FL模型,包括模型插值、正则化局部损失、元学习、知识蒸馏等。

客户端的最终模型是全局模型和局部模型的结合。更新过程中局部模型的百分比由一个混合权重控制,该权重可以是局部数据分布与全局数据分布之间的Jensen - Shannon散度或地球移动距离( EMD )

基于数据的方法旨在通过样本重加权、聚类、流形学习等方法降低客户端数据分布的统计异质性。可以通过根据样本的预测置信度对样本重新加权来解决非独立同分布数据问题。为了使局部训练在客户之间更加一致,并避免局部数据的过拟合,它对局部模型在预测结果中比全局模型更不好的样本赋予更多的权重。

也可以通过从每个客户端根据图同构网络( GIN )模型的梯度或模型权重对客户端进行聚类来解决非i . i . d .问题。一般的FL聚合是在每个簇内进行的。FMTGL 通过获得通用任务来缓解noni . i . d .问题。

ps:同构网络指的是网络中的节点和边具有相同类型和属性的网络。相对,异构网络中的节点和边可以有不同的类型和属性。

基于FL聚合改进的方法通过定义FL聚合中每个客户端的重要性来缓解noni . i . d .问题。一般的FL聚合方法描述如下:

Wrc:第c个客户端中的模型权重

Wr :第r轮服务器中的全局模型权重

ηc:客户端c在FL聚合中的重要性

根据公共随机生成图的客户端局部模型输出之间的函数相似度计算权重。每个客户端还可以计算与其他所有客户端的相似度,得到个性化的本地模型。

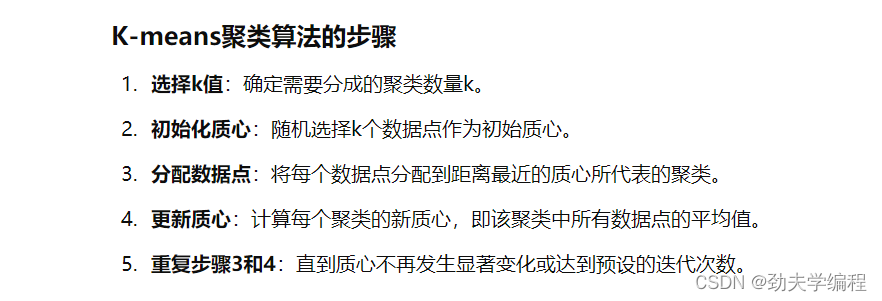

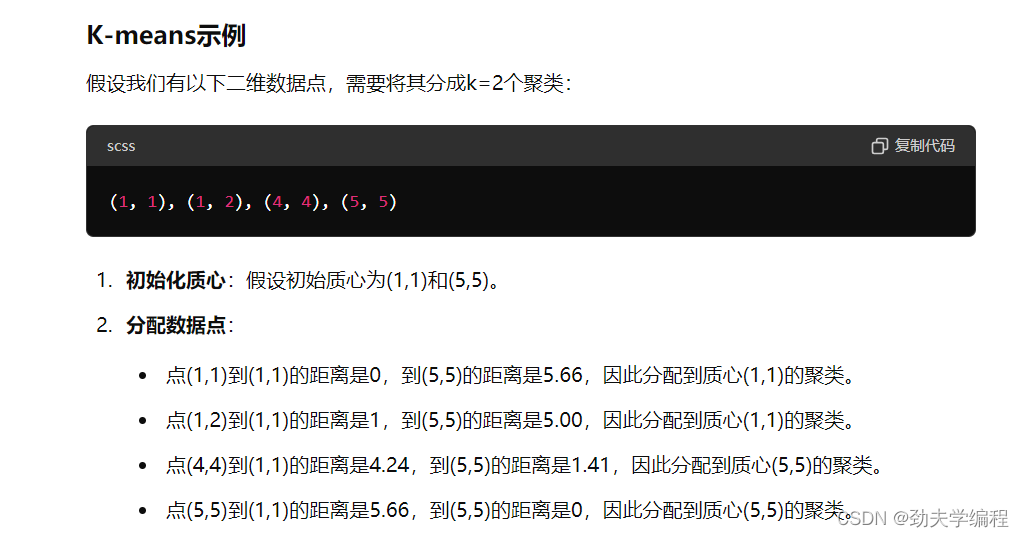

最近的一些工作主要关注图结构中的非i . i . d .问题。FedLIT 使用k - means聚类对边进行分类。然后,在每个客户端中利用多个卷积通道在不同类型的边上进行消息传递,解决了noni.i .d的挑战。

ps:

4.1.1.2Graph embedding problem

分布式图数据中的图嵌入问题:由于局部图拓扑结构随时间变化或每个节点包含时序数据,因此需要为分布式图数据嵌入时空( ST )信息。

STFL没有考虑图嵌入中的时间关系。他们将每个时间的图数据作为一个样本,并预测每个样本的标签。

Feddy通过应用动态GNN来考虑图嵌入中的时间信息。

4D-FED-GNN 重点研究了时间点缺失的演化图学习任务。每个客户端针对每个时间步训练一个GNN模型。GNN充当生成器或基于数据的自编码器

4.1.1.3Neural architecture search problem

分布式图数据中的神经结构搜索问题:为局部GNN模型设计合适的结构有利于全局模型的性能。

FL-AGNNS 提出了一种联合进化优化策略来搜索合适的GCN架构。该算法采用GCN超网和权值共享策略来减少搜索时间,使算法能够在短时间内找到更优的GCN模型。

4.1.1.4Communication efficiency problem between clients

客户端之间的通信效率问题:大规模的局部图数据需要数量巨大的局部GNN模型,这导致客户端之间的通信成本很高。

为了减少GNN模型训练的通信和计算开销,Fed Graph 设计了基于强化学习的服务器采样策略。在每一轮中,服务器为客户端细化采样策略(也就是说,需要采样的节点数)和GNN模型参数。

CTFL 采用分而治之的策略,根据局部模型参数的接近程度对客户进行聚类。每个集群只有一个具有代表性的本地模型发送到服务器进行FL聚合,以降低通信成本。

4.1.1.5Privacy protection problem between clients

客户端之间的隐私保护问题:通过共享模型参数和图拓扑结构,FedGNNs具有较大的攻击面,需要更多地关注隐私保护问题。一些工作假设客户端和服务器都是诚实但好奇的(honest-but-curious),即他们会遵循协议,但可能会尝试推断其他参与方的私密信息。

Fe So G使用动态局部差分隐私( LDP )将加密的梯度上传到服务器,进行FL聚合。

ps:动态本地差分隐私(Dynamic Local Differential Privacy, LDP)是一种隐私保护技术,通过在数据上传之前添加噪声,确保单个数据项的隐私。

FedGraph 中的客户端使用可信执行环境( TEE )加密本地训练,服务器使用安全多方计算( MPC )或同态加密( HE )加密全局模型聚合。

ps:可信执行环境 (TEE)是一种安全区域,提供隔离执行环境,使得代码和数据在这个环境中执行时得到保护。即使操作系统或其他软件受到攻击,TEE 内部的内容也不会被泄露或篡改。

安全多方计算 (MPC):一种加密计算技术,允许多个参与方在不暴露各自输入数据的前提下,共同完成某个计算任务。每个参与方只知道自己的输入和最终计算结果。

同态加密 (HE):一种加密技术,允许在加密数据上直接执行特定的计算,计算结果仍然是加密的。解密后得到的结果与对明文直接计算的结果相同。

FedEgo通过在客户端构建混合自我图来保护图隐私。通过为中心节点采样大小固定的邻居节点来保护全局结构,从而构建自图

ps:自我图通过仅使用与中心节点直接相连的邻居节点来构建,限制了每个客户端分享的信息量,从而保护图的隐私

4.1.2Clients With Missing Edges

拥有本地数据,但丢失边的数据,如下图:

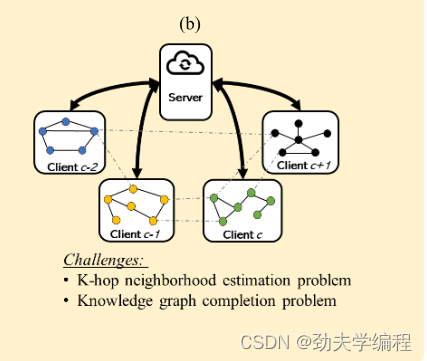

边缺失的客户端:该情况假设不同客户端中连接节点的一些边缺失。缺失的边可以分为两种类型:1 )具有不同节点ID的节点之间的边

2 )位于不同客户端的对齐节点之间的边(也就是不同客户端表示相同实体或者具有相似特征的边缺失)

对于第一类,户端之间无法直接通信,所以如何处理被缺失边隔离的k-hop neighbor information是一个关键的挑战。

对于第二种类型,KG(知识图谱)完备化是这一背景下的一个重要挑战。关键的策略是在客户端对齐节点之间进行信息转换,以帮助本地KG嵌入完成。一旦局部图被修改,FL算法就以与"无缺失边的客户端"工作相同的方式来辅助GNN训练。

4.1.2.1K-hop neighborhood estimation problem

k - hop邻域估计问题:位于服务器、客户端或第三方的边生成器或节点生成器被设计用来修正局部图以估计它们的k - hop邻域信息。一旦局部图是完整的,在客户端对其进行GNN模型训练,并在服务器中应用FL聚合来获得全局模型。

ps:边(节点)生成器通过生成潜在的边(节点)来补全图结构,确保节点能够获得更多的邻居信息。这些生成器可以通过模型推断、数据挖掘或机器学习等方法来实现。

FASTGNN 在服务器中提出了一种简单的边生成器。它利用高斯随机生成的边缘重建客户端之间缺失的边缘,把他们传送到所有客户端去更新自己的本地图。

位于服务器的FedGL中的边生成器可以生成FL客户端上传的节点嵌入的全局伪图,并将其分发到客户端以修改其局部图,用于GNN模型的训练。

4.1.2.2KG completion problem:

KG完备化问题:来自不同领域的KG可能包含相同的实体。如何在不泄露隐私的情况下,借助其他KG来提高KG的嵌入质量是一个挑战。关键部分是在对齐的嵌入之间进行跨客户端的信息转换。

ps:对齐实体(Aligned Entities):不同领域或不同客户端的KGs 中,表示相同实体的节点。

嵌入(Embedding):将KGs 中的实体和关系映射到低维向量空间,便于进行计算和分析。

FKGE 设计了一个改进的基于GAN的模块来翻译配对的KG之间的对齐实体和关系嵌入。如果成对的KG得到改进,则将精化后的嵌入广播给其他KG。

FedE 在服务器中设计了一个整体实体表来记录来自客户端的所有唯一实体。服务端将FedAvg FL聚合应用在表中对齐的实体嵌入上。一旦完成,更新的实体嵌入将被分发到客户端。客户端通过自训练对比学习损失,基于KG嵌入方法更新实体嵌入。

为了解决FedE中的隐私泄露问题,FedR中的客户端上传关系嵌入而不是实体嵌入,因为服务器无法在仅有关系嵌入的情况下推断实体嵌入。为了进一步保护隐私,在上传到服务器之前,安全聚合应用于关系嵌入,服务器中的关系表通过私有集合并( Private Set Union,PSU )获得。

4.2vertical FedGNNs

垂直型FedGNNs中的客户端持有节点ID完全重叠但特征空间不同的节点。客户借助FL,利用来自不同客户的特征训练一个全局GNN模型。

根据图数据的完备性,垂直FedGNNs有两个子场景:

1 )图数据不完备的客户端

2 )图数据完备的客户端

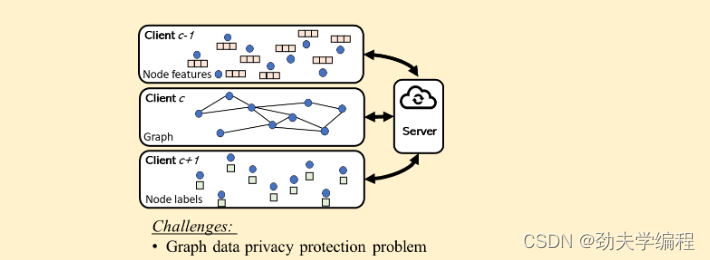

4.2.1Clients With Incomplete Graph Data

在联邦学习环境中,不同客户端拥有不完整的图数据,即图的拓扑结构、节点特征和节点标签分别由不同客户端拥有。这种情况下,如何使这些客户端在保护隐私的前提下协同工作是一个重要的挑战。

4.2.1.1Graph data privacy protection problem

SGNN(Secure Graph Neural Network)通过计算基于动态时间规整(Dynamic Time Warping, DTW)算法的相似度矩阵,来传递相同的图拓扑信息,但隐匿原始结构,以保护图结构的隐私。此外,为了保护节点特征的隐私,SGNN将原始特征进行独热编码(One-Hot Encoding),并将编码后的信息上传至服务器,进行全局GNN模型的训练,用于节点分类任务。

FedSGC(Federated Simplified Graph Convolution)假设只有两个客户端且没有中心服务器,图拓扑和节点特征分别由两个客户端持有。拥有节点标签的客户端是主动方,负责创建加密密钥对,并使用加性同态加密(Additively Homomorphic Encryption, AHE)加密敏感信息,然后将其发送给另一方以更新GNN模型参数。

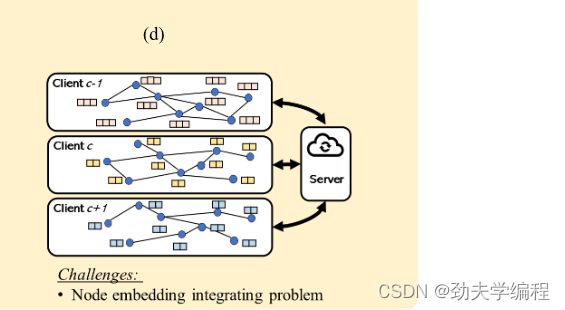

4.2.2Clients With Complete Graph Data

在这种情况下,它假设客户端包含完整的图数据,包括图拓扑和节点特征。然而,它们的节点特征类型是不同的,如下图。以安全的方式集成节点特征是利用这种分布式图数据训练GNN模型的关键策略。

VFGNN(Vertically Federated Graph Neural Network)中的客户端使用差分隐私(Differential Privacy, DP)加密节点特征,并通过半诚实(semihonest)的服务器进行整合。整合方式可以是平均、拼接或回归计算。训练完成后,拥有节点标签的客户端接收更新后的节点嵌入,以进行节点预测。

ps:差分隐私加密:节点特征使用DP加密,保护隐私。

FMLST(Federated MultiLayer Spatial-Temporal Network)假设所有客户端共享一个全局模式图,该图包含相同的节点。通过多层感知机(MLP)将本地时空(ST)模式与全局ST模式融合,客户端通过评估全局和本地模式图之间的差异来个性化其本地模式图。

ps:全局模式图:所有客户端共享一个包含相同节点的全局模式图。

模式融合:使用MLP将本地和全局ST模式拼接作为输入,进行模式融合。

本地个性化:客户端通过评估全局和本地模式图之间的差异,个性化其本地模式图。

FedVGCN(Federated Vertically Graph Convolutional Network)中,两个客户端之间传输同态加密的中间结果,半诚实服务器创建加密密钥对并进行FL聚合,以完成节点特征空间的整合。

ps:同态加密:使用同态加密技术保护中间结果的隐私。

加密密钥对:半诚实服务器创建加密密钥对,用于数据加密和解密。

FL聚合:服务器进行FL聚合,整合各客户端的中间结果,完成节点特征空间的整合。

Graph-Fraudster研究了本地原始数据和节点嵌入上的对抗攻击,提出了差分隐私机制和top-k机制作为可能的防御手段。

ps:对抗攻击:研究对抗攻击对本地原始数据和节点嵌入的影响。

防御机制:

差分隐私机制:通过添加噪声保护数据隐私。

top-k机制:选择前k个最重要的特征进行处理,减少攻击面。

4.3Summary

联邦学习(FL)辅助的图神经网络(GNN)方法在分布式环境中利用FL来辅助GNN模型的训练。以下是对这些方法的总结,包括它们的优缺点。

优点

应对数据异质性问题:

Horizontal FedGNNs处理拥有不同节点ID的客户端图数据,能够训练GNN模型并缓解跨客户端的数据异质性问题。

分布式模型训练:

可以在分布式环境中进行GNN模型的训练,使得每个客户端都能利用本地数据进行模型更新。

处理缺失边的能力:

某些方法能够应对客户端之间缺失边的情况,通过恢复部分缺失信息来提高模型性能。

缺点

图拓扑异质性忽略:

Horizontal FedGNNs通常忽略了图拓扑的异质性问题。偏差的图可能导致联邦GNN中的不公平性。

隐私保护能力低:

现有方法的隐私保护能力普遍较低。例如,很少有方法在将模型权重发送到服务器之前对其进行加密,导致当前方法在应对恶意攻击时缺乏鲁棒性。

高通信成本:

当本地图模型的规模或客户端数量较大时,通信成本高。

仅适用于基础GNN模型:

现有方法仅适用于有限的基础GNN模型,需要包括更多先进的GNN模型。

不精确的本地图修复:

如果修复后的本地图不准确,模型性能可能会下降。此外,有些方法要求客户端与邻居共享一些节点特征以修复本地图,这可能导致隐私泄露。

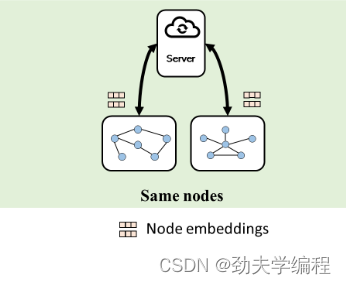

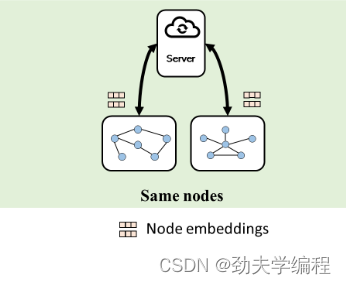

五、FL Clients With the Same Nodes

在这个类别中,假设客户端拥有具有相同节点集合但不同类型节点特征的节点。

垂直型FedGNNs和部分具有重叠节点(例如, KG完成任务)的水平型FedGNNs就属于这一类。

在这种情况下,FL客户端通常会将节点的特征嵌入上传到FL服务器,在FL服务器中聚合同一节点的不同特征嵌入,实现客户端之间的知识传递。

此外,模型权重也可以在客户端之间共享,以在垂直FedGNNs中联合训练一个全局FL模型。

六、FL Clients With Different Nodes but the Same Network Structure

在这一分类中,假设FL客户端具有不同的节点,但具有相同的网络结构。

大多数GNN辅助的FL和水平FedGNN都属于这一类,因为它们的客户端包含不同的样本。由于该设置下节点ID不同,无法将节点特征嵌入上传到服务器进行FL聚合。

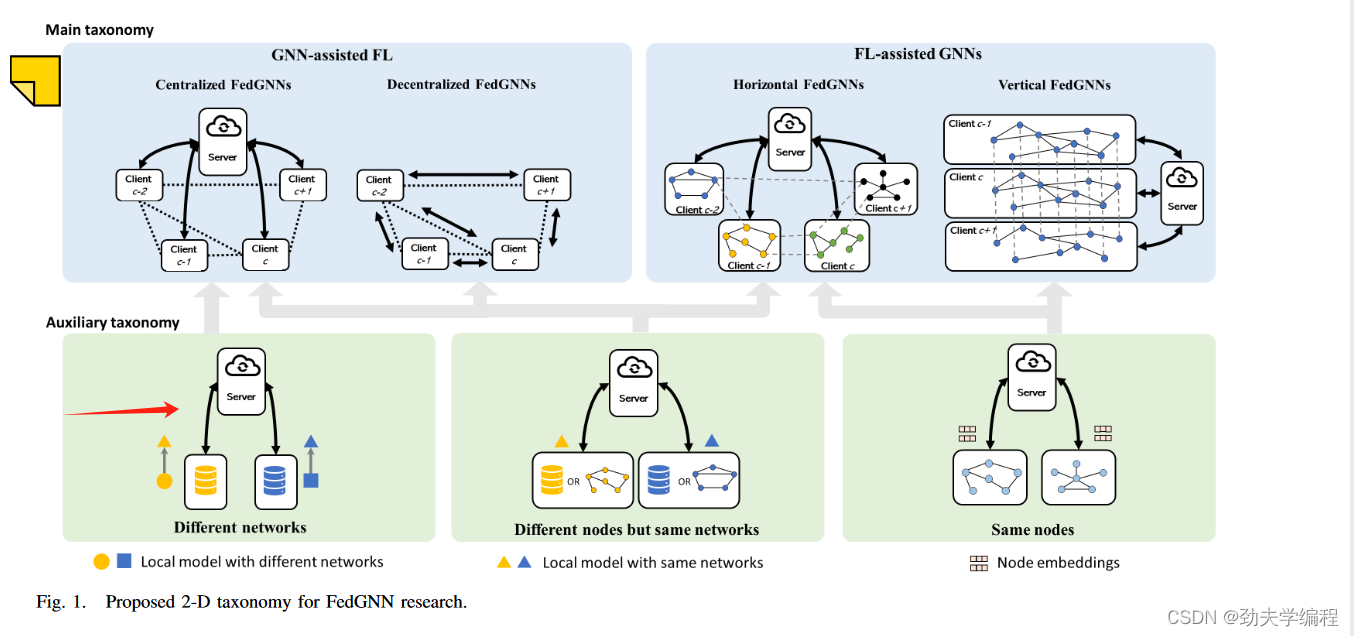

根据GNN聚合X(l+1) = AX(l)W,可训练矩阵W的大小与图拓扑结构无关,而与节点特征和输出特征的维度有关。因此,可以将整个图,可训练的模型权重和梯度在GNN模型中的嵌入上传至服务器进行FL聚合。是否上传模型权重或梯度取决于训练速度和模型性能之间的偏好

七、FL Clients With Different Network Structures

这类工作处理的是客户端网络架构不同的更困难的情况。来自不同客户端的GNN模型权重共享相同的维度,只要不同客户端的节点特征维度相同。然而,在这种设置下,来自不同客户端的节点特征是异构的,导致跨客户端的本地网络架构多种多样。

前只有 Litany 等人提出了一种解决方案:

将本地网络架构转换为图:

将每一层看作一个顶点,层的类型作为节点特征,将本地网络架构表示为一个图。

通过这种方式,可以将不同客户端的网络架构转换为具有相同节点特征维度的图。

一致节点特征维度:

一旦所有客户端的节点特征维度一致,问题就可以转换为前面讨论的第二类情况(具有相同节点特征空间但不同节点ID的客户端)。

使用图神经网络(GNN)模型训练这个图,并将GNN模型的权重上传到服务器进行FL聚合。

ps:

原文地址:https://blog.csdn.net/m0_57180439/article/details/140062531

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!