隐性行为克隆——机器人的复杂行为模仿学习的新表述

介绍

论文地址:https://arxiv.org/pdf/2109.00137.pdf

源码地址:https://github.com/opendilab/DI-engine.git

近年来,人们对机器人学习进行了大量研究,并取得了许多成果。其中,模仿学习法尤其受到关注。这是一种从人类等专家从实际机器人操作中获得的数据中学习策略的方法。模仿学习的优点包括:它不需要设计奖励函数,而且可以使用直接操作机器人的数据,无需考虑建模误差,而建模误差可能是模拟现实中的一个问题。由于这些优点,已经证实经过良好调整的基于模仿学习的措施可以在现实世界中取得成功,目前正在对其进行积极研究。

请观看这段视频,作者在视频中实际解释了这项研究的内容,以便更好地理解。

现有研究和问题

明确的政策

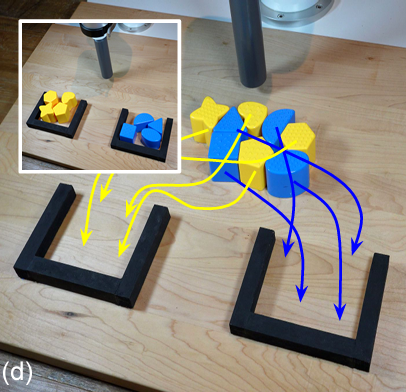

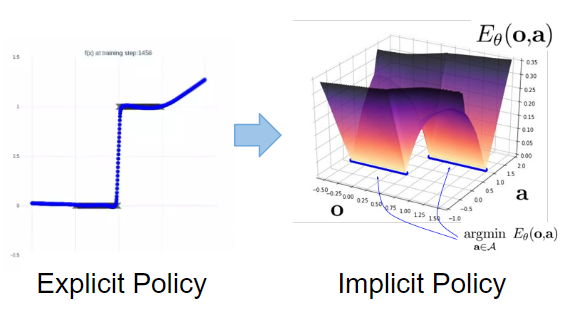

模仿学习中常用的一种方法叫做 “显式策略”。这是一种将根据观察结果生成机器人行为的策略建模为连续函数的方法,具体表示如下。

_θ_的获得是为了最小化人类给出的轨迹与策略轨迹之间的误差。

_θ_的获得是为了最小化人类给出的轨迹与策略轨迹之间的误差。

然而,众所周知,这一明确政策难以应对以下两个挑战

不连续性

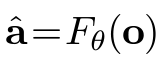

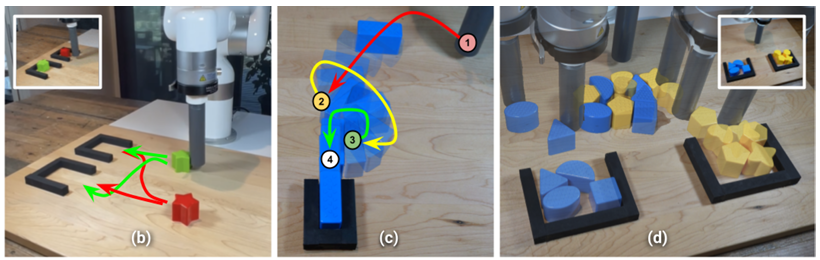

这指的是包含离散情况(如动作序列)的任务的特点。下图显示的任务是将一个蓝色方块插入一个小盒子中,但要实现这一点,需要离散地切换操作顺序,即从左到右推一次,然后从后面推到盒子一侧。然而,这无法用连续建模的 "显式策略 "来表示。

多种模式

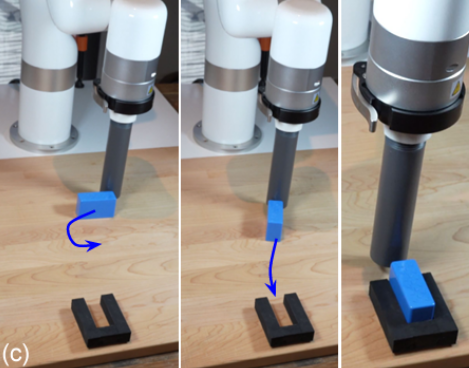

这是指实现一个目标有多种方法。在下图中,任务是将蓝色和黄色的积木分开并放入两个盒子中,但为了实现目标,需要移动的积木既可以来自蓝色,也可以来自黄色,这就使得任务具有了多模式性。这就给处理这种多模式任务带来了困难。

建议方法

为了应对现有研究的挑战,本文以另一种方式重新表述了模仿学习,这就是下文中的 “隐性政策”。

隐性政策

具体来说,它引入了基于能量的模型(EBM)。与前一个系统测量与目标轨迹的接近程度不同,"显式策略 "系统对观测和行动的 EBM 学习如下:

在 EBM 中,在给定状态下选择某种行动的概率可表示为可以表示为其中,z(x,θ) 为归一化常数。

在 EBM 中,在给定状态下选择某种行动的概率可表示为可以表示为其中,z(x,θ) 为归一化常数。

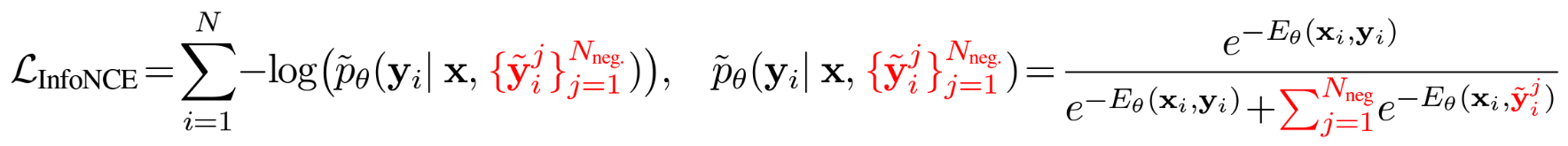

然而,由于_很难计算所有y_的_z,因此_采用了_如下的抽样近似_方法:损失函数由该概率的负对数似然来计算。损失函数也是用这个概率的负对数似然来计算的,学习和推理都是通过这些来进行的。

然而,由于_很难计算所有y_的_z,因此_采用了_如下的抽样近似_方法:损失函数由该概率的负对数似然来计算。损失函数也是用这个概率的负对数似然来计算的,学习和推理都是通过这些来进行的。

特殊性

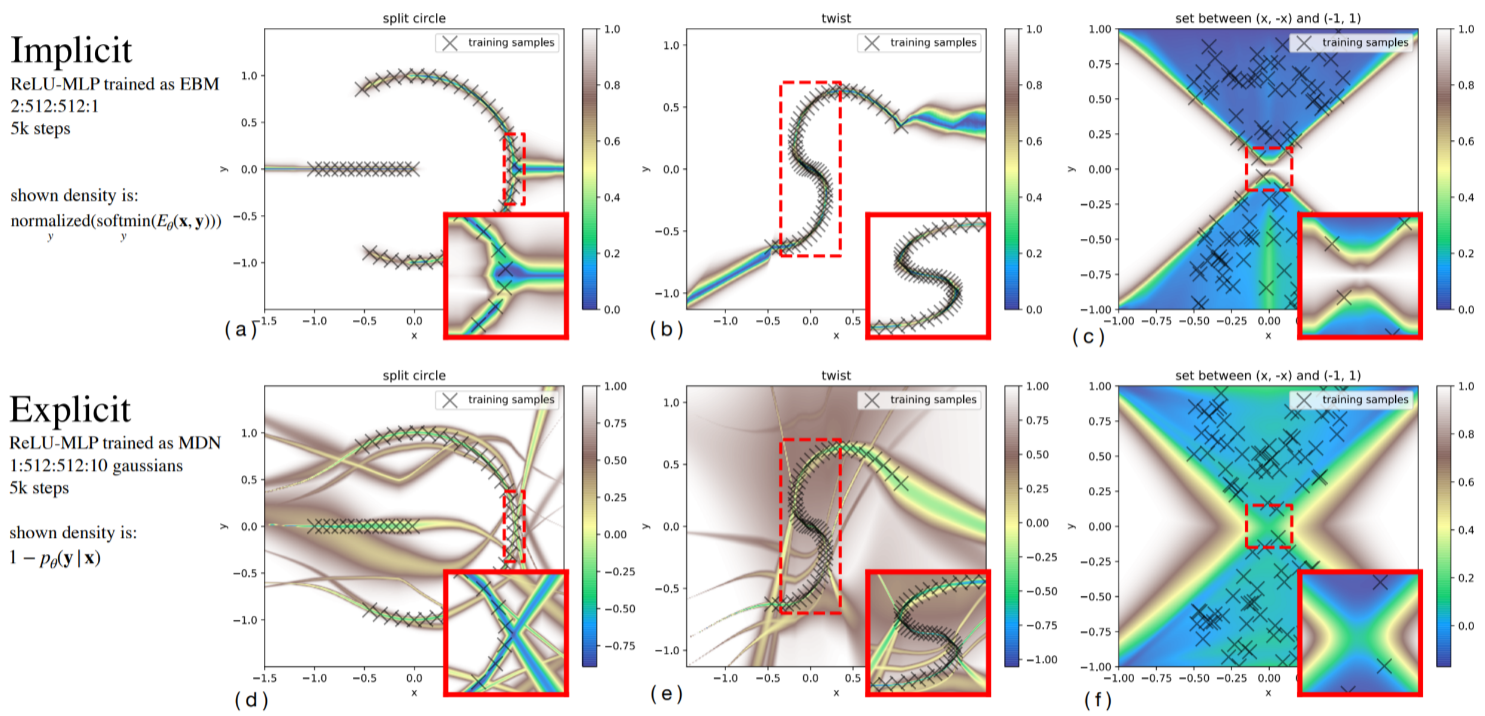

现在,我们来回顾一下上述表述所获得的特性。首先,以下结果表明,离散性问题得到了解决。问题集是将一个不连续的函数正确地表示为教师数据,而显式策略不可避免地会在两者之间完成,而隐式策略能够以不连续的形式表示。

下图显示了学习函数的问题设置,O 代表样本。在这个问题中,存在多值和多模态函数,以往的方法很难对其进行近似,但隐式策略将数值集中在样本附近,表明它比显式策略更好地表示了这一问题。

下图显示了学习函数的问题设置,O 代表样本。在这个问题中,存在多值和多模态函数,以往的方法很难对其进行近似,但隐式策略将数值集中在样本附近,表明它比显式策略更好地表示了这一问题。

试验

隐式策略用于执行实际的机器人控制任务。观测内容包括图像输入、机器人关节角度、角速度和位置姿态,而关节角度的位置控制指令和速度控制指令则被设置为动作。

您可以在这里观看实验结果视频。

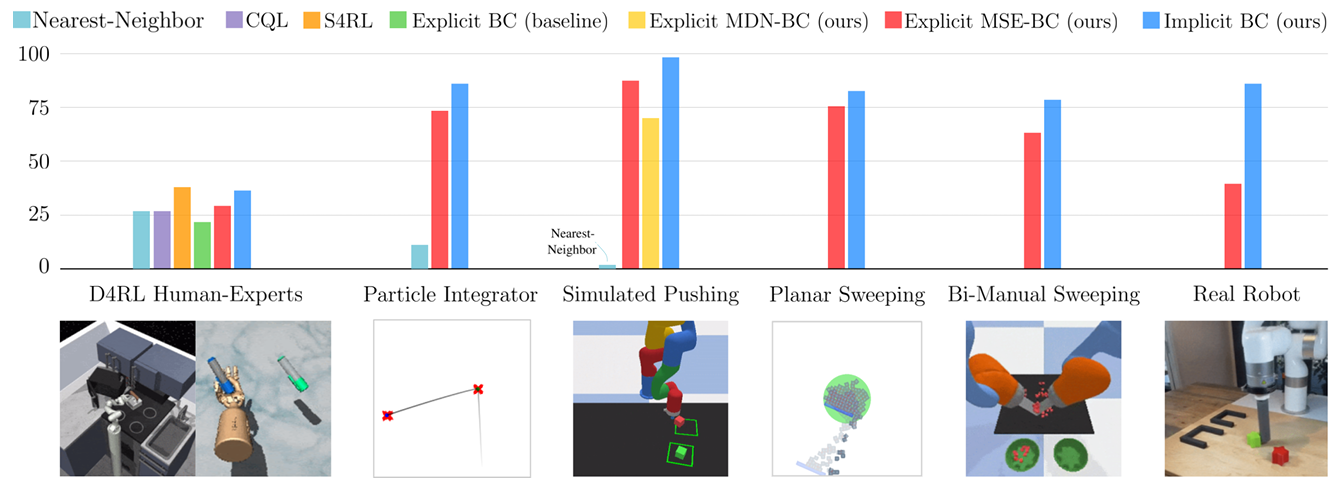

模拟实验

利用各种模拟环境和任务,与传统方法进行了比较。基本上,在几乎所有任务中,该方法的性能都明显优于传统方法。

所有这些任务都涉及离散性和多模态性,结果似乎证实了隐式政策在处理这些特征方面的优势。

野外实验

机械手用于执行多项任务,在实际机器上移动积木块。首先,如左图所示,将红色和绿色积木块放入任一目标的任务,我们的方法取得了约 90% 的成功率,而传统方法只有约 55% 的成功率。这项任务具有高度的多模态性,我们已经证实,我们的方法能够应对隐式规则中固有的多模态性。接下来,在插入需要调整 1 毫米的图块(如图像中央的图块)的任务中,需要离散地切换动作序列,如图所示。在这项任务中,系统的 "隐含策略 "特性也大大优于传统方法,成功率约为 80%。最后,我们还尝试了将大量蓝色和黄色图块分离并放置到目标中的任务,如右图所示。即使是这种离散任务和多模态任务的复杂组合,成功率也达到了约 50%,这证明系统能够将学习到的行为结合起来,并产生新的行为。此外,机器人还能对人类的干预(如移动木块)立即做出反应,并将其送回目标位置,这证明所获得的策略非常稳健。

总结

在本文中,我们重点讨论了模仿学习的传统方法(显式策略)无法处理的离散性和多模态问题,并提出了一种可以处理这些问题的新方法(隐式策略)。在模拟和真实机器上的实验表明,它的性能明显优于传统方法,而且在真实机器上非常稳健。

需要改进的一个方面是,与之前的 "显式政策 "相比,计算成本有所增加,因此如果能进一步降低计算成本,就有可能完成更多的动态任务。

原文地址:https://blog.csdn.net/matt45m/article/details/140505519

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!