世界启动Ⅲ--什么是 Transformer?

前言

Transformer 本质上是神经网络。专门从数据中学习上下文的神经网络。

但它们的特殊之处在于存在一些机制,可以消除对标记数据集以及网络中的卷积或循环的需求。

这些特殊机制是什么?

有很多。但真正推动 Transformer 发展的两种机制是注意力加权和前馈网络 (FFN)。

什么是注意力加权?

注意力加权是一种技术,通过该技术,模型可以了解需要关注传入序列的哪一部分。可以将其想象成“索伦之眼”,随时扫描所有内容,并聚焦于相关部分。

有趣的是:显然,研究人员几乎将 Transformer 模型命名为“Attention-Net”,因为 Attention 是其中至关重要的一部分。

FFN 是什么?

在 transformers 的背景下,FFN 本质上是一个作用于一批独立数据向量的常规多层感知器。结合注意力,它产生正确的“位置-维度”组合。

Attention 和 FFN 如何工作?

所以,事不宜迟,让我们深入研究注意力加权和FFN如何使 transformer 如此强大。

因此我们开始吧:

这里的关键思想:注意力加权和前馈网络(FFN)。

记住这些,假设我们得到:

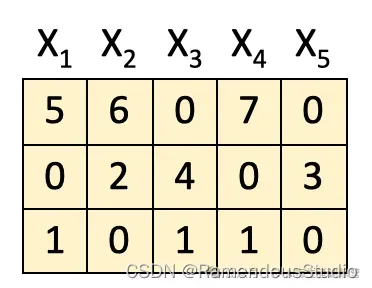

- 来自前一个块的 5 个输入特征(这里是一个 3x5 矩阵,其中 X1、X2、X3、X4 和 X5 是特征,每三行分别表示它们的特性。)

[1]获取注意力权重矩阵A

该过程的第一步是获得注意力权重矩阵 A。这是自注意力机制发挥作用的部分。它试图在这个输入序列中找到最相关的部分。

我们通过将输入特征输入到查询键 (QK) 模块来实现此目的。为简单起见,此处未包含 QK 模块的详细信息。

[2]注意力权重

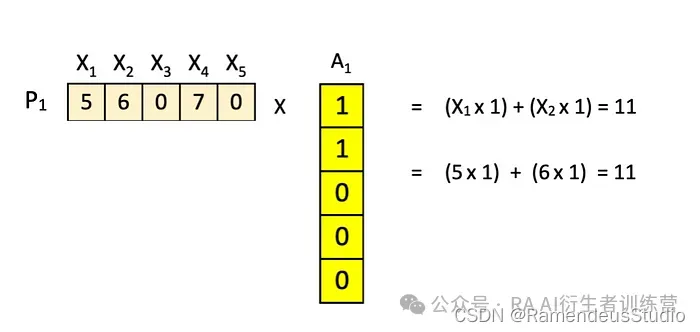

一旦我们有了注意力权重矩阵 A (5x5),我们就将输入特征 (3x5) 与其相乘以获得注意力加权特征 Z。

这里重要的部分是,这里的特征是根据它们的位置P1、P2 和 P3 即水平方向进行组合的。

为了进一步分解,请考虑按行执行的计算:

P1 X A1 = Z1 → 位置 [1,1] = 11

P1 X A2 = Z2 → 位置 [1,2] = 6

P1 X A3 = Z3 → 位置 [1,3] = 7

P1 X A4 = Z4 → 位置 [1,4] = 7

P1 X A5 = Z5 → 位置 [1,5] = 5

。

。

。

P2 X A4 = Z4 → 位置 [2,4] = 3

P3 X A5 = Z5 →位置[3,5] = 1

举个例子:

一开始似乎有点乏味,但按照行乘法,结果应该很简单。

很酷的是我们的注意力权重矩阵A的排列方式,新的特征Z变成X的组合,如下所示 :

Z1 = X1 + X2

Z2=X2+X3

Z3=X3+X4

Z4=X4+X5

Z5=X5+X1

(提示:查看矩阵A中 0 和 1 的位置)。

[3] FFN: 第一层

下一步是将注意力加权的特征输入前馈神经网络。

但是,此处的不同之处在于跨维度组合值,而不是上一步中的位置组合。具体操作如下:

这样做的目的是从另一个方向查看数据。

- 在注意力步骤中,我们在原有特征的基础上结合我们的输入,得到新的特征。

- 在这个 FFN 步骤中,我们考虑它们的特征,即垂直组合特征以获得我们的新矩阵。

例如:P1(1,1) * Z1(1,1)+ P2 (1,2) * Z1 (2,1)+ P3 (1,3) * Z1(3,1) + b(1) = 11,其中 b 是偏差。

再次,逐元素行运算来拯救我们。请注意,这里新矩阵的维数增加到了 4。

[4]线性整流器

我们最喜欢的步骤:ReLU,其中前一个矩阵中获得的负值返回为零,而正值保持不变。

[5] FFN: 第二层

最后我们将其传入第二层,结果矩阵的维数从 4 降回 3。

这里的输出准备好输入到下一个块(参见其与原始矩阵的相似性)并且整个过程从头开始重复。

这里要记住的两个关键点是:

- 注意层跨位置(水平)组合。

- 前馈层跨维度(垂直)组合。

这就是 Transformer 强大功能的秘密武器——从不同方向分析数据的能力。

总结上述想法,关键点如下:

- Transformer 架构可以被视为注意层和前馈层的组合。

- 注意层将特征组合起来以产生新特征。例如,想象一下将两个机器人 Robo-Truck 和 Optimus Prime 组合起来得到一个新的机器人 Robtimus Prime。

- 前馈(FFN) 层将部件或特征组合起来以产生新的部件/特征。例如,Robo-Truck 的轮子和 Optimus Prime 的 Ion-laser 可以产生轮式激光器。

永远强大的变形金刚

神经网络已经存在了相当长一段时间。卷积神经网络 (CNN) 和循环神经网络 (RNN) 一直占据主导地位,但自从 2017 年推出 Transformers 以来,情况发生了重大转变。从那时起,人工智能领域呈指数级增长——每天都有新模型、新基准、新学习出现。只有时间才能证明这个非凡的想法是否有一天会引领更大的东西——真正的“Transformer”。

但现在,如果说一个想法确实可以改变我们的生活方式,这并不为过!

欢迎你分享你的作品到我们的平台上:www.shxcj.com 或者 www.2img.ai 让更多的人看到你的才华。

创作不易,觉得不错的话,点个赞吧!!!

原文地址:https://blog.csdn.net/RamendeusStudio/article/details/140497923

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!