基于云计算和大数据技术的传感器数据存储与分析系统

传感器被广泛用于监测环境参数,如温度、压力、湿度和特定气体的浓度。这些数据通常被收集并保存在数据存储系统中,随后进行分析以识别异常模式。在数据量巨大的情况下,传统的关系型数据库可能在性能上遇到瓶颈,使得处理和分析来自传感器的数据变得复杂。随着数据量的增加和获取速度的加快,传统的数据管理和分析方法可能不足以应对新型传感器应用的需求。因此,出现了基于云技术和大数据技术的新型传感器数据存储和分析解决方案,这些解决方案利用开源工具,提供全面的传感器数据管理和分析功能。

一、相关技术

1.1 传感器数据

传感器是能够监测诸如温度、湿度、压力、噪声水平和光照条件,并能检测物体速度和位置的设备。随着技术的进步,传感器的应用日益广泛,其所产生的数据无论是在体积上还是种类上都在快速增长。传感器的广泛应用催生了新的挑战。例如,物联网(IoT)的概念即是由传感器数量远超互联网用户数量的现象发展而来,它强调的是物品之间的互联。物联网通过Wi-Fi、RFID、GPRS、DSL、LAN、3G等多种连接方式,促进了人与物、物与物以及人与人之间的通讯,进而生成了大量的数据,这些数据对于传统数据库技术来说,在存储和分析方面显得难以应对。随着传感器技术的飞速发展,传感器的数量和其所产生的数据量正在以惊人的速度增长,这对使用传统SQL数据库进行数据处理和分析提出了更高的计算和存储要求。

1.2 MapReduce与Hadoop技术概述

在处理传感器数据的大规模分析时,NoSQL数据库因其在多个服务器间高效分配数据的能力而受到青睐,它们能够动态地为数据集添加新的属性。这类数据库为处理大量数据提供了高可用性、高性能和可扩展性的特点。

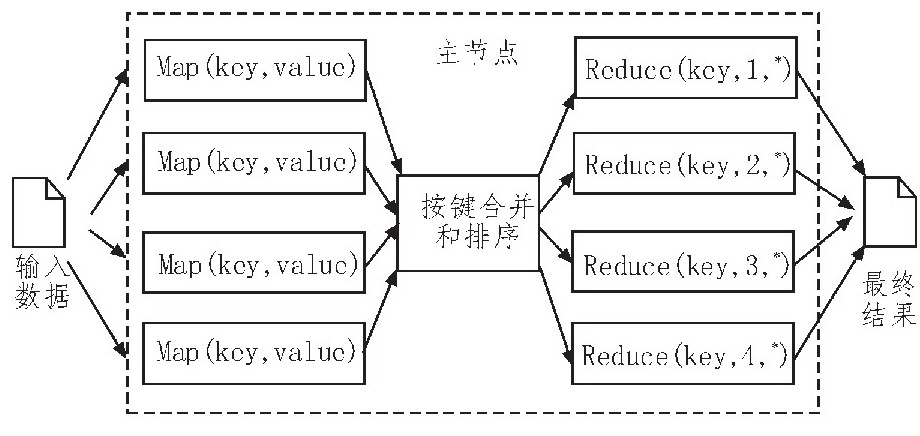

MapReduce是一个编程模型,它支持对大规模数据集进行并行处理。用户可以通过MapReduce API来实现自己的程序,从而完成数据的分割、分发、处理和结果的整合。MapReduce作业通常由一个主节点控制,分为Map和Reduce两个主要函数。Map函数负责将输入数据切分为键值对,然后按键排序;Reduce函数则将这些排序后的值合并,生成最终的输出结果。

MapReduce的工作原理

在实际应用中,可能需要运行多个MapReduce作业来完成数据分析任务。这些作业可以独立运行,也可以在更复杂的数据处理流程中相互关联。MapReduce已经在Hadoop等开源项目中得到实现,并在多个领域的大数据项目中得到应用。

Hadoop是一个开源框架,它使用Hadoop分布式文件系统(HDFS)来存储数据。在HDFS中,数据以块的形式存储,文件被分割成多个块,然后分布在Hadoop集群的多个节点上。默认情况下,每个块的大小为64MB,但如果文件更大,HDFS会从不超过最大块大小的那一行开始分割文件,将剩余部分移至新的块中。这种设计使得Hadoop能够有效地处理大规模数据集。

1.3 云计算

为了高效地运行Hadoop集群处理大量数据,通常需要构建一个集群环境。得益于虚拟化技术的发展,建立此类集群的成本已经大幅降低。尽管如此,建立集群通常还是需要较大的经济投入、软件许可费用以及人工管理。云计算提供了一种成本效益高的解决方案,它不仅便于处理和分析大规模数据,还作为一种服务模式支持大数据技术。一些开源的云计算平台允许用户部署基础设施即服务,其上可以进一步构建平台即服务,例如Hadoop,专门用于大规模数据的处理。

部署Hadoop集群可能涉及在多个服务器上安装和配置相应的软件,当集群规模达到数百甚至数千台服务器时,这一过程可能会变得复杂且充满挑战。云计算平台提供的基础设施易于扩展和管理,包括网络和存储资源,并具备容错能力。

1.4 大数据分析

在大数据分析领域,通常需要应用数据挖掘或机器学习算法。许多现有的机器学习框架由于内存限制而难以扩展到处理大规模数据。Mahout是一个分布式机器学习框架,它提供了多种算法,包括分类、协同过滤和聚类等,这些算法可以并行运行在集群上。Mahout的目标是构建一个可扩展的机器学习库,以服务于Hadoop集群,从而将大型数据集的分析任务分解为多个子任务,最终通过组合这些子任务的结果来得到整体分析结果。

Spark则引入了一种新的数据处理方式,它通过所谓的弹性分布式数据集(RDD)提供了一种分布式内存抽象,这种数据结构支持在大型集群上的内存计算。RDD具备容错能力,能够在任务失败时自动恢复和重构数据。Spark通过这种数据抽象支持迭代计算,相较于其他计算框架,在处理大数据时更为高效和实用。

二、系统架构

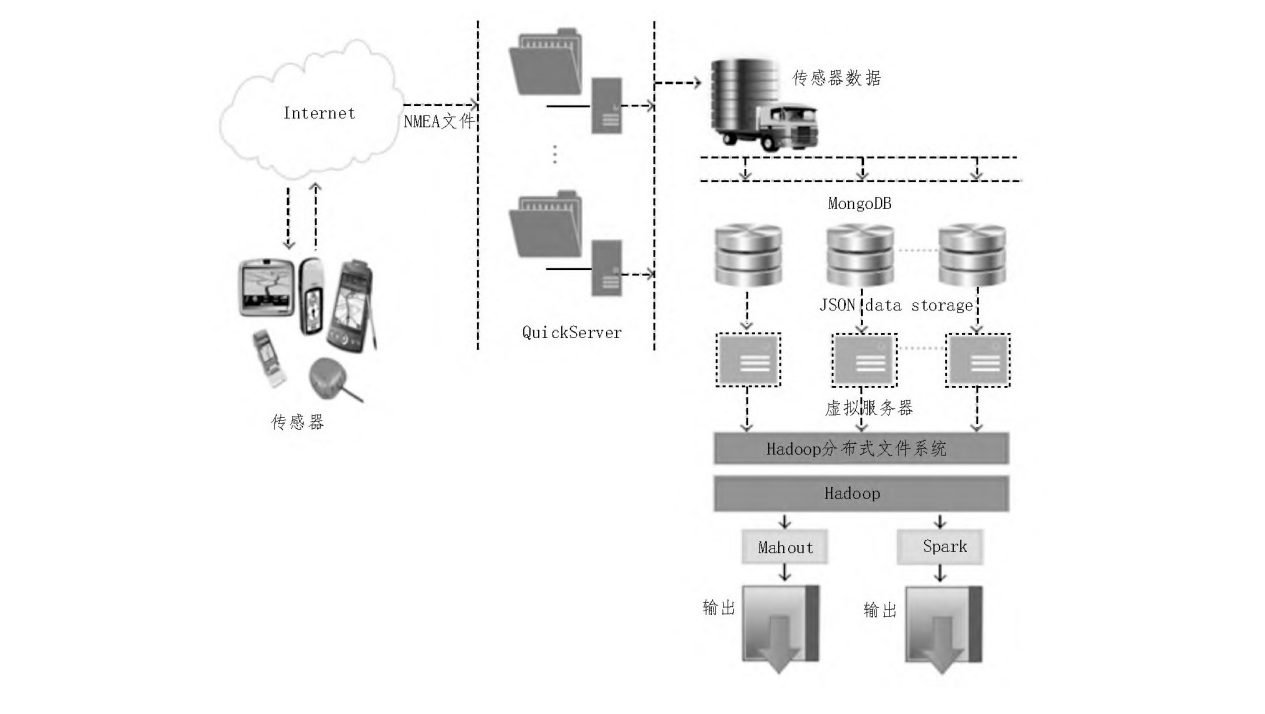

在研究中,构建了一个全面的传感器数据管理和分析系统,该系统基于开源软件,具备分布式和可扩展的特性,能够适应不同数量传感器的需求。系统的架构可以从图2中得到了解。系统主要分为三个核心部分:数据采集、数据存储和数据分析。在该系统中,应用平台运行在特定的硬件上,该硬件配备了高性能的处理器和充足的内存,以及一个流行的操作系统。

具体的硬件配置包括一个具有多个处理核心的服务器,这些核心基于特定的CPU架构,并且系统内存容量足以支持复杂的数据处理任务。操作系统选择了一个广泛使用的Linux发行版,以确保系统的稳定性和安全性。这样的配置旨在为传感器数据的采集、存储和分析提供一个高效、可靠的运行环境。

系统架构

在研究中,采用了GPS传感器来生成数据。该系统架构也适用于其他类型的传感器网络,因为其数据采集子系统能够接收通过TCP或UDP协议发布的各类传感器数据。

2.1 数据采集子系统的设计和实现

GPS作为一种广泛应用的位置定位技术,它基于卫星导航系统,为全球范围内的接收设备提供时间与位置信息。在多数情况下,GPS数据在采集后并不进行深入分析。在本研究中,利用了开源的Java库QuickServer,该库能够迅速构建多线程、多客户端的TCP服务器应用程序以及功能强大的服务器应用。QuickServer包含一个名为OSAdminServer的远程管理接口,它可以用来管理服务器软件的各项功能。在收集GPS服务器发送的实时数据时,服务器上会运行一个数据过滤和解析程序,这个程序负责即时提取关键信息,并将其存储到数据库中。

2.2 数据存储子系统的构建与优化

传感器收集的数据一般会被保存在某种数据存储结构中。随着传感器数量和数据量的增加,持续存储数据变得日益复杂。传统的传感器数据存储方法往往只暂时保存数据。然而,传感器数据具有潜在价值,可能包含故障或诊断信息。因此,本研究构建了一个可扩展的分布式数据存储子系统,用于长期存储传感器数据。开源的NOSQL数据库为大量传感器数据的存储提供了有效的解决方案。本研究中使用了MongoDB数据库,这是一种流行的开源NOSQL数据库,它是一个面向文档的数据库,能够存储JSON格式的文档,具有高性能、高可用性和易于扩展的特点。MongoDB中的文档可以映射为编程语言的数据类型,且数据库支持通过自动主故障转移进行复制。为了扩展数据库,可以自动将数据集合分布到不同的机器上。选择MongoDB的主要原因是为了提供对QuickServer的高性能写入支持,并在大规模传感器使用场景下轻松扩展数据库。

2.3 数据分析子系统的构建

在研究中,数据分析子系统是关键组成部分,它负责处理和分析传感器收集的数据。该子系统不仅支持长期存储数据,还能够从中提取关键信息,例如预警信号和故障指示。数据分析可以通过基础统计方法实施,也可以采用更高级的数据挖掘或机器学习技术。

在本研究中,利用大数据技术构建了一个可扩展的分布式数据分析平台,旨在对传感器数据运用先进的机器学习算法,以识别有价值的信息。大数据处理通常需要计算集群的支持,这些集群可以通过多个服务器构建。虚拟化技术在此过程中发挥重要作用,它通过提高资源利用率来降低成本,并允许在单一物理机器上运行多个操作系统实例,这些实例可以作为集群节点。

尽管虚拟化技术提供了诸多优势,但许多虚拟化软件可能需要昂贵的许可费用或专业的操作技能。因此,本研究采用了开源云计算平台OpenStack来创建Hadoop集群的计算节点。OpenStack是一种广泛使用的云计算解决方案,它为应用程序和科研人员提供了处理大数据的机会,通过可扩展的计算集群和先进的数据存储系统。

云计算服务通常分为三种模型:基础设施即服务(IaaS)、平台即服务(PaaS)和软件即服务(SaaS)。其中,IaaS是最灵活的基础模型,提供对硬件、存储、网络和操作系统的访问和管理。OpenStack是基于Rackspace和NASA的开发,是一个提供可扩展、灵活的云计算管理平台的IaaS项目。它提供了基于Web的图形用户界面(GUI),用于管理虚拟机的创建和删除。

在本研究中,使用OpenStack搭建了一个私有云环境,并运行了多个虚拟机实例作为Hadoop集群的节点,包括主节点和工作节点。这样的设置为大数据处理提供了必要的基础设施支持。

三、传感器数据分析结果

在对传感器数据进行分析的过程中,采用了分布式的机器学习方法。具体来说,利用了Apache Mahout框架和Apache Spark技术,这两种开源的分布式技术被用于对GPS传感器数据进行聚类分析。这些数据原本存储在MongoDB中,通过映射被转移到运行在集群节点上的HDFS中。

在空间数据分析领域,机器学习和数据挖掘算法的应用已经得到了一些研究的展示。但是,数据的规模对这些算法的运行构成了重要限制,因为它们通常计算复杂且资源消耗大。幸运的是,大数据技术提供了分析大规模空间数据集的可能性。

在本研究中,采用了k-means算法对二维GPS位置数据进行聚类分析。k-means是一种无监督学习算法,其核心目标是将数据对象分配到不同的组中,这些对象需要以数字特征的形式表示。该算法使用距离作为相似性的衡量标准,并通过迭代过程将数据点分配到k个聚类中。研究中提出的架构被用来处理包含数百万数据点的大型数据集。

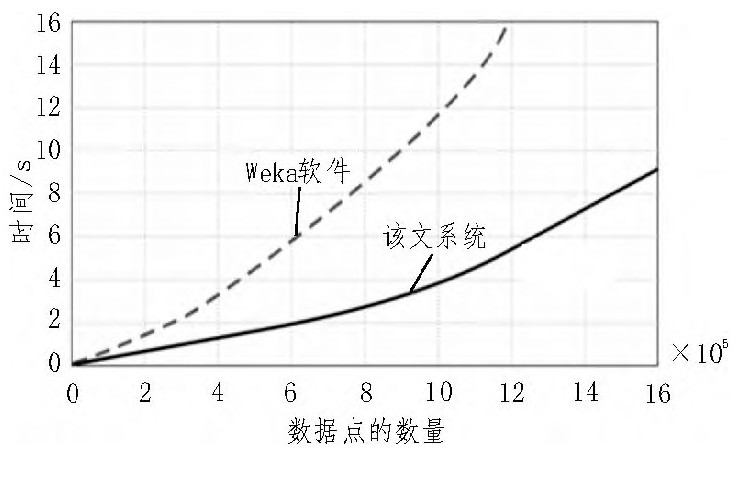

性能对比结果

为了进行比较,还在一台配置有8GB内存和Intel i5-3470 CPU的台式机上运行了Weka软件。Weka是一款广泛使用的数据挖掘和机器学习软件,它在多项研究中都有所应用。性能对比结果显示,Weka在处理数据点较少时与提出的系统性能相近。但是,随着数据量的增加,Weka的性能显著下降,处理时间大幅度增加,并且在数据点数量超过一定阈值时会出现内存异常。

相比之下,提出的系统使用Spark技术对高达1600万个数据点执行k-means算法,处理时间随着数据点数量的增加而几乎呈线性增长,显示出系统能够高效地处理大规模的传感器数据,且在分析数百万数据点时不出现性能问题。这些结果表明,所提出的系统能够有效地对大量数据点进行聚类分析。

四、总结

研究中提出的系统架构旨在实现传感器数据的分布式采集、存储和分析。该架构具备良好的扩展性,能够适应大规模传感器部署和大数据环境。它支持多传感器数据的高效收集,并通过高性能服务器进行数据处理。测试结果显示,该系统能够有效地处理复杂的数据分析任务,并且在分析大规模传感器数据时展现了卓越的性能。通过运用开源技术、云计算和大数据框架,该系统能够满足大规模传感器数据分析的需求。

原文地址:https://blog.csdn.net/whwzzc/article/details/142324637

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!