机器学习 | 随机梯度下降分类器

数据科学和机器学习工具包中用于各种分类任务的一个重要工具是随机梯度下降(SGD)分类器。通过探索其功能和在数据驱动决策中的关键作用,我们开始探索SGD分类器的复杂性。

SGD分类器是一种与SGD回归器有着密切联系的灵活分类技术。它的工作原理是在损失函数最陡梯度的方向上逐渐改变模型参数。它在每次迭代中用随机选择的训练数据子集更新这些参数的能力是它作为“随机”的区别。

SGD分类器是一个有用的工具,因为它的多功能性,特别是在需要实时学习和涉及大数据集的情况下。我们将在这篇文章中研究SGD分类器的基本思想,剖析其关键变量和超参数。我们还将讨论任何潜在的缺点,并研究其优点,例如可扩展性和效率。

随机梯度下降

深度学习和机器学习中一种流行的优化方法是随机梯度下降(SGD)。大型数据集和复杂的模型从其训练中受益匪浅。为了最小化损失函数,SGD迭代地更新模型参数。它通过在每次迭代中使用训练数据的小批量或随机子集来区分自己为“随机”,这在最大化计算效率的同时引入了一定程度的随机性。通过加速收敛,这种随机性可以帮助逃避局部极小值。现代机器学习算法严重依赖SGD,因为尽管它很简单,但当与正则化策略和合适的学习率计划相结合时,它可能非常有效。

随机梯度下降如何工作?

以下是SGD流程的典型工作方式:

- 随机初始化模型参数或使用某些默认值初始化模型参数。

- 随机打乱训练数据。

- 对于每个训练示例:使用当前示例计算成本函数相对于当前模型参数的梯度。

- 在负梯度的方向上通过称为学习率的小步长来更新模型参数。

- 对指定的迭代次数(epoch)重复此过程。

什么是SGD分类器?

SGD分类器是一种线性分类算法,旨在找到最佳决策边界(超平面),以分离属于特征空间中不同类别的数据点。它通过使用随机梯度下降优化技术迭代地调整模型的参数来最小化成本函数,通常是交叉熵损失。

它与其他分类器的区别

SGD分类器与其他分类器的不同之处在于以下几个方面:

- 随机梯度下降:与一些使用封闭形式解决方案或批量梯度下降(在每次迭代中处理整个训练数据集)的分类器不同,SGD分类器使用随机梯度下降。它增量地更新模型的参数,一次处理一个训练样本或以小批量处理。这使得它具有计算效率,非常适合大型数据集。

- 线性:SGD分类器是一个线性分类器,这意味着它构建了一个线性决策边界来分离类。这使得它适用于特征和目标变量之间的关系近似线性的问题。相比之下,像决策树或支持向量机这样的算法可以捕获更复杂的决策边界。

- 正则化:SGD分类器允许合并L1或L2正则化以防止过拟合。正则化项被添加到成本函数,鼓励模型具有较小的参数值。这在处理高维数据时特别有用。

机器学习中的常见用例

SGD分类器通常用于各种机器学习任务和场景:

- 文本分类:它通常用于情感分析,垃圾邮件检测和文本分类等任务。文本数据通常是高维的,SGD分类器可以有效地处理大型特征空间。

- 大型数据集:当处理大量数据集时,SGD分类器的随机性是有利的。它允许您在大型数据集上进行训练,而无需将整个数据集加载到内存中,从而提高内存效率。

- 在线学习:在实时数据流的场景中,例如点击流分析或欺诈检测,SGD分类器非常适合在线学习。它可以不断适应不断变化的数据模式。

- 多分类:SGD分类器可以通过扩展二分类方法来处理多个类,通常使用one-vs-all(OvA)策略来用于多分类任务。

- 参数调整:SGD分类器是一种通用算法,可以使用各种超参数进行微调,包括学习率,正则化强度和损失函数的类型。这种灵活性使它能够适应不同的问题域。

随机梯度下降分类器的参数

随机梯度下降(SGD)分类器是一种多功能算法,具有各种参数和概念,可以显着影响其性能。以下是与SGD分类器相关的一些关键参数和概念的详细说明:

- 学习率(α):

学习率(α)是一个关键的超参数,它决定了每次迭代中参数更新所需的步长。

它控制收敛速度和稳定性之间的权衡。

较大的学习率可以导致更快的收敛,但可能导致超过最优解。

相比之下,较小的学习速率可能导致较慢的收敛,但更新更稳定。

为你的特定问题选择一个合适的学习率是很重要的。 - 批量(Batch Size):

批量大小定义了在更新模型参数时,每次迭代或小批量中使用的训练示例的数量。批量大小有三种常见选择:

随机梯度下降(batch size= 1):在这种情况下,模型参数在处理每个训练样本后更新。这引入了显著的随机性,可以帮助避免局部最小值,但可能导致噪声更新。

小批量梯度下降(1 < batch size < 训练样本的数量):小批量SGD在批量梯度下降的效率和随机梯度下降的噪声之间取得了平衡。这是最常用的变体。

批量梯度下降(batch size =训练样本的数量):在这种情况下,模型参数在每次迭代中使用整个训练数据集进行更新。虽然这可以导致更稳定的更新,但它在计算上是昂贵的,特别是对于大型数据集。 - 收敛标准:

收敛准则用于确定何时应该停止优化过程。共同的趋同标准包括:

固定的epoch数:您可以设置预定义的epoch数,算法在完成数据集的多次迭代后停止。

成本函数变化的容差:当连续迭代之间的成本函数变化小于指定阈值时停止。

验证集性能:您可以在单独的验证集上监视模型的性能,并在达到令人满意的性能水平时停止训练。 - 正则化(L1和L2):

正则化是一种用于防止过拟合的技术。

SGD Classifier允许您将L1(Lasso)和L2(Ridge)正则化项合并到成本函数中。

这些项根据模型参数的大小增加了一个惩罚,鼓励它们变小。

正则化强度超参数控制正则化对优化过程的影响。 - 损失函数:

损失函数的选择决定了分类器如何测量预测和实际类别标签之间的误差。

对于二元分类,通常使用交叉熵损失,而对于多类问题,分类交叉熵或softmax损失是典型的。

损失函数的选择应该与问题和所使用的激活函数相一致。 - 动量和自适应学习率:

为了增强收敛性并避免振荡,您可以使用动量技术或自适应学习率。动量引入了一个额外的参数,使更新更加平滑,并帮助算法摆脱局部极小值。自适应学习率方法根据观察到的进展在训练期间自动调整学习率。 - 提前停止:

提前停止是一种用于防止过拟合的技术。它涉及在训练期间监控模型在验证集上的性能,并在性能开始下降时停止优化过程,这表明过拟合。

使用SGD分类器的案例

要在Python中实现随机梯度下降分类器,您可以遵循以下步骤:

1.导入库

# importing Libraries

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.linear_model import SGDClassifier

from sklearn.metrics import accuracy_score, confusion_matrix, classification_report

import seaborn as sns

此代码加载Iris数据集,导入机器学习分类任务所需的库,划分训练和测试阶段,构建SGD分类器,评估模型的准确性,生成混淆矩阵,分类报告,并显示混淆矩阵的散点图和热图。

2.加载和准备数据

# Load the Iris dataset

data = load_iris()

X, y = data.data, data.target

# Split the data into training and testing sets

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size=0.3, random_state=42)

3.创建SGD分类器

# Create an SGD Classifier

clf = SGDClassifier(loss='log_loss', alpha=0.01,

max_iter=1000, random_state=42)

在此代码中,SGD分类器(clf)被实例化用于分类任务。由于分类器被配置为使用对数损失(逻辑损失)函数,因此它可以用于二分类和多分类。此外,为了帮助避免过拟合,使用alpha参数为0.01的L2正则化。为了保证结果的一致性,选择42的随机种子,并且分类器在训练期间运行多达1000次迭代。

4.训练分类器并进行预测

# Train the classifier

clf.fit(X_train, y_train)

# Make predictions

y_pred = clf.predict(X_test)

5.评估模型

# Evaluate the model

accuracy = accuracy_score(y_test, y_pred)

print(f'Accuracy: {accuracy}')

输出

Accuracy: 0.9555555555555556

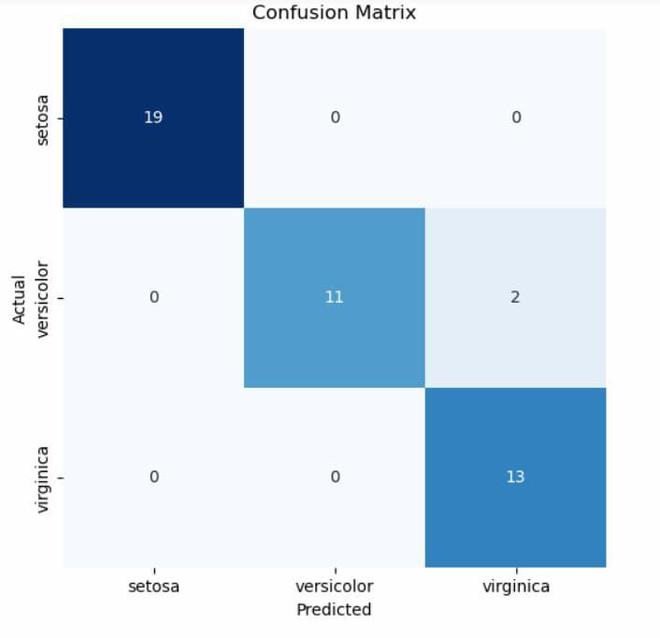

6.混淆矩阵

# Plot the confusion matrix using Seaborn

plt.figure(figsize=(6, 6))

sns.heatmap(conf_matrix, annot=True, fmt="d", cmap="Blues", cbar=False,

xticklabels=data.target_names, yticklabels=data.target_names)

plt.xlabel('Predicted')

plt.ylabel('Actual')

plt.title('Confusion Matrix')

plt.show()

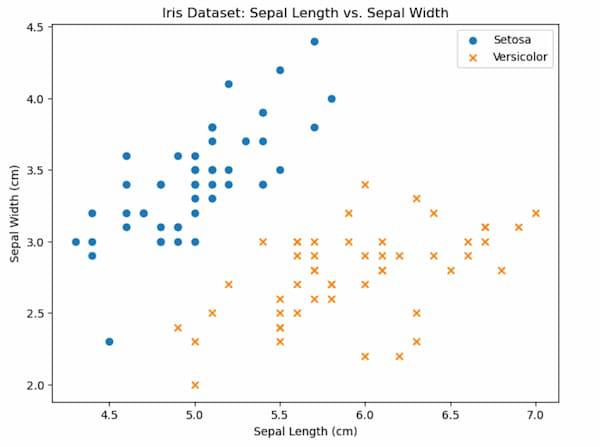

7.两个类别(Setosa和Versicolor)的散点图

# Visualize the Sepal length vs. Sepal width for two classes (Setosa and Versicolor)

plt.figure(figsize=(8, 6))

plt.scatter(X[y == 0, 0], X[y == 0, 1], label="Setosa", marker="o")

plt.scatter(X[y == 1, 0], X[y == 1, 1], label="Versicolor", marker="x")

plt.xlabel("Sepal Length (cm)")

plt.ylabel("Sepal Width (cm)")

plt.legend()

plt.title("Iris Dataset: Sepal Length vs. Sepal Width")

plt.show()

8.分类报告

# Print the classification report

class_names = data.target_names

report = classification_report(y_test, y_pred, target_names=class_names)

print("Classification Report:\n", report)

输出

Classification Report:

precision recall f1-score support

setosa 1.00 1.00 1.00 19

versicolor 1.00 0.85 0.92 13

virginica 0.87 1.00 0.93 13

accuracy 0.96 45

macro avg 0.96 0.95 0.95 45

weighted avg 0.96 0.96 0.96 45

随机梯度下降分类器优缺点

随机梯度下降(SGD)分类器提供了几个优点:

- 大数据集的效率:SGD分类器最显著的优势之一是它对大数据集的效率。由于它一次处理一个训练示例或小批处理,因此不需要将整个数据集加载到内存中。这使得它适用于具有大量数据的场景。

- 在线学习:SGD非常适合在线学习,模型可以实时适应和学习传入的数据流。它可以不断更新其参数,使其适用于推荐系统,欺诈检测和点击流分析等应用。

- 快速收敛:SGD通常比批量梯度下降收敛得更快,因为参数更新更频繁。当您有计算约束或想要快速遍历不同的模型配置时,这种速度可能是有益的。

- 正则化支持:SGD分类器允许合并L1和L2正则化项,这有助于防止过拟合。这些正则化技术在处理高维数据或需要降低模型复杂性时非常有用。

随机梯度下降(SGD)分类器有一些缺点和局限性:

- 随机性:SGD的随机性在参数更新中引入了随机性,这可能会使收敛路径产生噪声。它可能导致某些迭代收敛较慢,甚至收敛到次优解。

- 调整学习率:选择适当的学习率至关重要,但可能具有挑战性。如果学习率太高,算法可能超过最优解,而学习率太低可能导致收敛缓慢。找到正确的平衡可能是耗时的。

- 对特征缩放的敏感性:SGD对特征缩放敏感。理想情况下,特征应该标准化(即,以均值为中心并缩放到单位方差)以确保最佳收敛。不这样做可能会导致趋同问题。

- 有限的建模能力:作为一个线性分类器,SGD分类器可能难以处理没有线性决策边界的复杂数据。在这种情况下,像决策树或神经网络这样的其他算法可能更合适。

结论

总之,Python中的随机梯度下降(SGD)分类器是一种多功能的优化算法,支持各种机器学习应用程序。通过使用随机数据子集有效地更新模型参数,SGD有助于处理大型数据集和在线学习。从线性和逻辑回归到深度学习和强化学习,它为有效训练模型提供了强大的工具。它的实用性、广泛的实用性和适应性使其继续成为现代数据科学和机器学习的基石,从而能够在不同领域开发准确高效的预测模型。

原文地址:https://blog.csdn.net/qq_42034590/article/details/135736391

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!