实战 | YOLOv8使用TensorRT加速推理教程(步骤 + 代码)

导 读

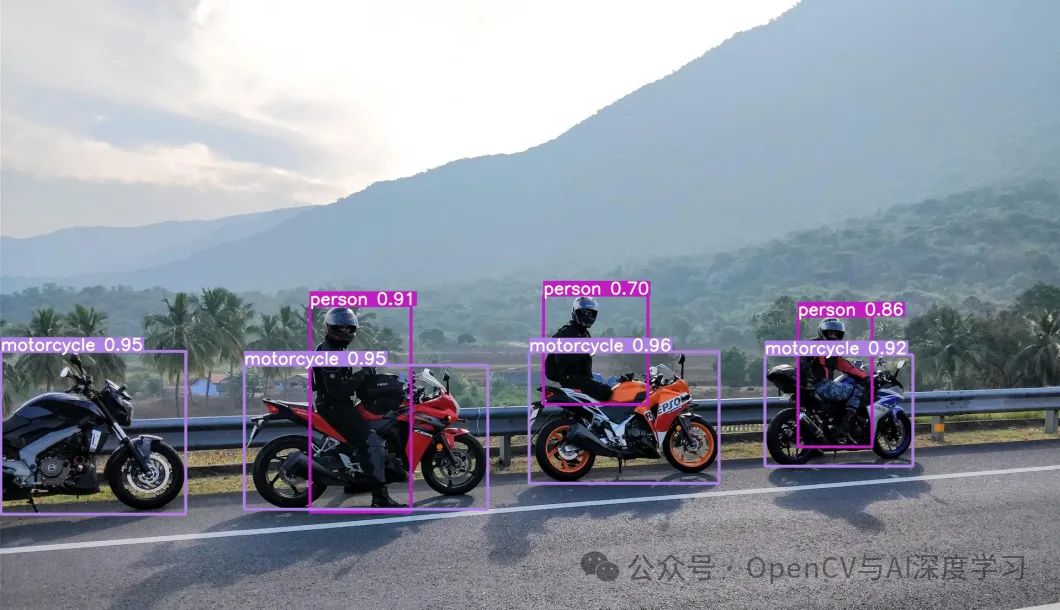

本文主要介绍如何使用TensorRT加速YOLOv8模型推理的详细步骤与演示。

YOLOv8推理加速的方法有哪些?

YOLOv8模型推理加速可以通过多种技术和方法实现,下面是一些主要的策略:

1. 模型结构优化

网络剪枝:移除模型中不重要的神经元或连接,减少模型复杂度。

模型精简:设计更轻量级的模型架构,比如使用更少的卷积层或更小的卷积核。

2. 算子优化

算子融合:将多个连续的操作合并成一个,减少计算和内存开销。

内核优化:利用特定硬件的优化指令集,如AVX2, AVX512等,针对CPU进行优化。

3. 量化

权重量化:将模型的权重和激活值从浮点数转换为定点数(如8位或16位整数),降低计算复杂度。

混合精度训练:在训练过程中使用混合精度,如FP16,以加快训练和推理速度。

4. 编译器和运行时优化

TensorRT:使用NVIDIA的TensorRT对模型进行优化,生成高效的执行引

原文地址:https://blog.csdn.net/stq054188/article/details/140305396

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!