论文略读:Benign Oscillation of Stochastic Gradient Descent with Large Learning Rate

iclr 2024 reviewer评分 368

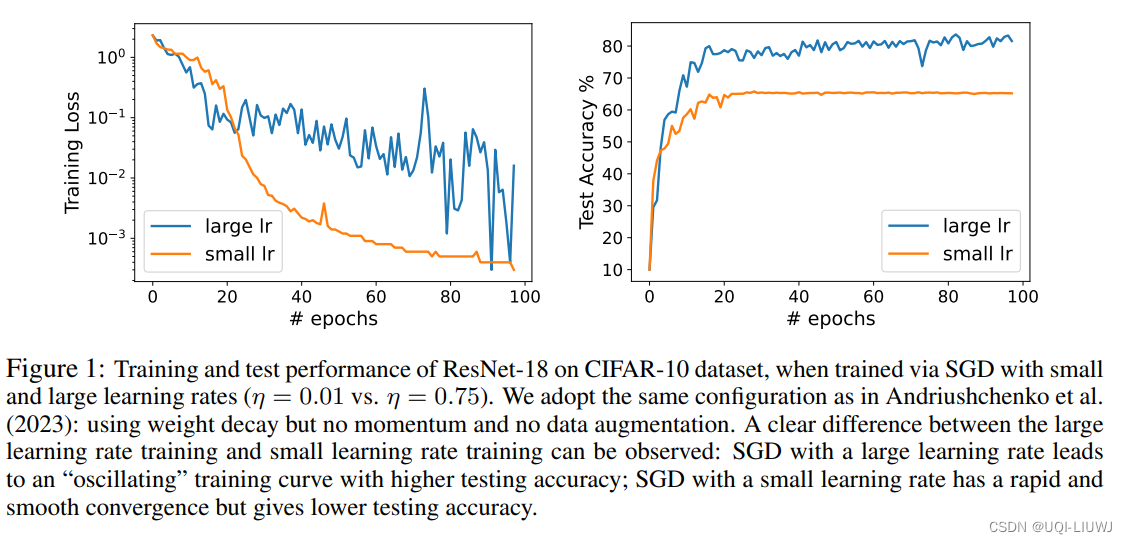

- 论文从理论上研究了通过随机梯度下降(SGD)且采用大学习率训练的神经网络(NN)的泛化特性

- 论文的发现是,由于SGD的大学习率引起的NN权重的振荡,实际上有利于NN的泛化,潜在地优于通过SGD以小学习率训练的、更平滑收敛的相同NN

- ——>将这种现象称为“良性振荡”

- 论文证明,通过振荡SGD且学习率较大训练的NN可以有效地学习在那些强特征存在的情况下的弱特征。相比之下,通过SGD且学习率较小训练的NN只能学习强特征,而在学习弱特征方面几乎没有进展

- ——>当面对只包含弱特征的新测试数据点时,通过振荡SGD且学习率较大训练的NN仍然可以做出正确的预测,而通过SGD且学习率较小训练的NN则不能

原文地址:https://blog.csdn.net/qq_40206371/article/details/137782176

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!