时间序列关于可解释性值得关注的论文汇总-第2篇

前言

这是时序可解释性论文汇总的第二篇,第一篇见这里(后台回复:“论文合集”可直接获取整理的文章)。深度学习的可解释性研究一直是热门,而时间序列的可解释性同样非常重要。这是因为时序模型被大量应用到特定领域:金融、医疗、交通等,这些应用场景对模型的可解释要求更高,需要提供可解释的预测。

1

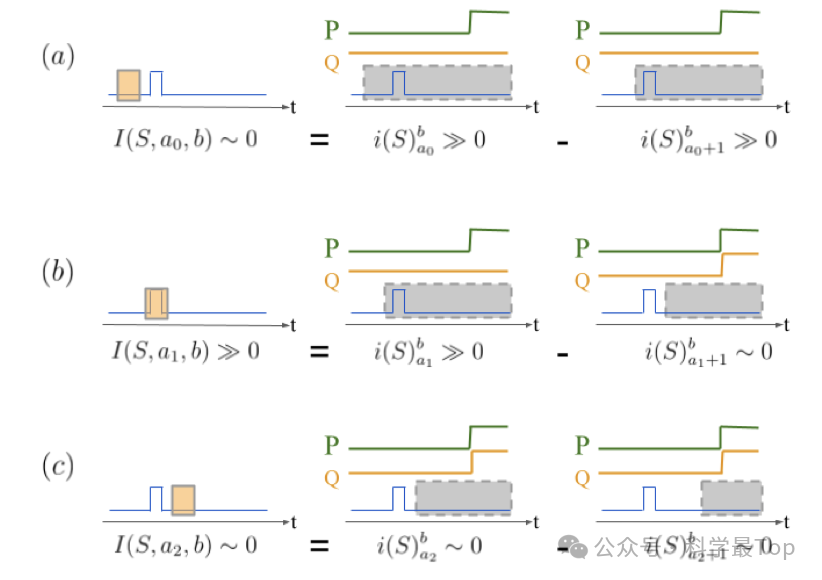

论文标题:TEMPORAL DEPENDENCIES IN FEATURE IMPORTANCE FOR TIME SERIES PREDICTION(ICLR23)

时间序列数据为可解释性方法带来了两个关键挑战:首先,同一特征在随后时间步的观察不是独立的;其次,同一特征对模型预测的重要性随时间变化。本文中提出了一种基于特征移除的可解释性方法——时间窗口特征重要性(WinIT),以解决这些问题。与现有的特征移除解释方法不同,WinIT在构建其重要性得分时,明确考虑了同一特征在不同时间观察之间的时间依赖性。此外,WinIT通过总结过去时间窗口内的重要性,捕捉了特征随时间变化的重要性。通过实证研究,并与一系列领先的可解释性方法进行了比较,作者探讨了各种评估策略的影响。结果表明:WinIT在现有方法上取得了显著的提升,并且在不同的评估指标上表现出更一致的性能。

2

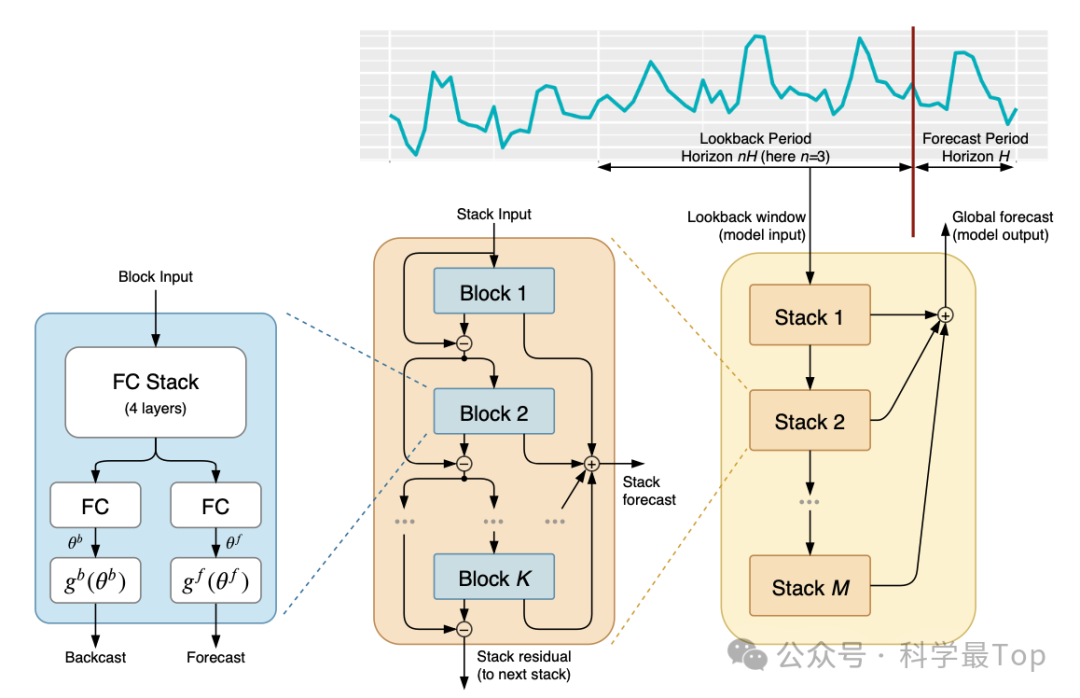

论文标题:N-BEATS: NEURAL BASIS EXPANSION ANALYSIS FOR INTERPRETABLE TIME SERIES FORECASTING(ICLR20)

本研究致力于应用深度学习技术解决单变量时间序列的点预测问题。作者设计了一种深度神经网络架构,该架构以反向和前向残差连接为基础,并堆叠了多层全连接层。这一架构具备多项优势:易于解释、无需调整即可适用于多种目标领域,且训练效率高。模型的初始配置并未采用任何特定于时间序列的组件,但其在多样化数据集上的表现强烈暗示了一个与常规认知相反的观点:深度学习的基本构件,如残差块,本身就足以应对广泛的预测挑战。最后,作者展示了如何通过增强架构来提供既准确又易于解释的预测结果。

3

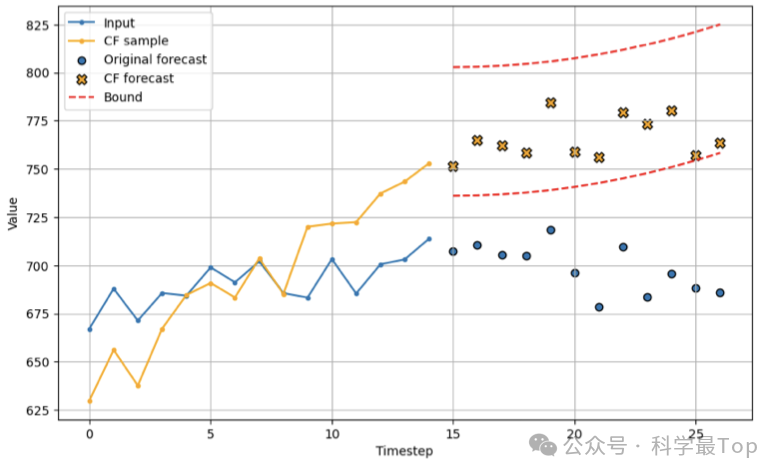

论文标题:Counterfactual Explanations for Time Series Forecasting

反事实解释(Counterfactual Explanations)作为一种事后分析手段,在分类模型的解释上得到了广泛应用,但它们在预测模型中的应用尚待深入研究。本文中,作者首次提出了时间序列预测中反事实生成的问题,并设计了一种名为ForecastCF的算法,该算法通过在原始时间序列上施加基于梯度的扰动来解决问题。ForecastCF通过在预测值上施加约束,引导这些扰动以实现预期的预测结果。对ForecastCF进行了实验评估,使用了四种当前领先的深度模型架构,并与两种基线方法进行了比较。评估结果显示,ForecastCF在反事实的有效性和数据流形的接近度上均优于基线方法。总体来看研究结果表明,ForecastCF能够为多种预测任务生成富有意义且相关的反事实解释。

4

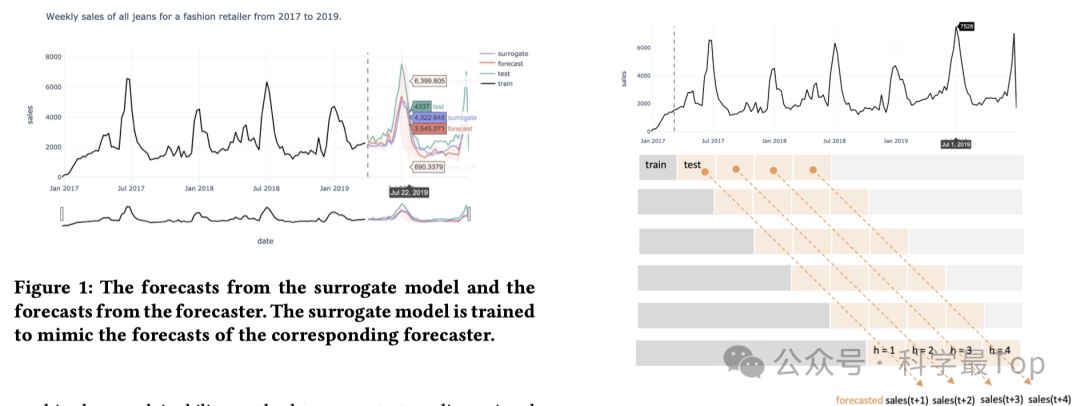

论文标题:Counterfactual Explanations for Time Series Forecasting

本文提出了一种基于特征的可解释性算法TsSHAP,该算法能够为任何黑盒预测模型提供预测解释。TsSHAP算法对所解释的预测模型具有通用性,并且能够基于用户预先定义的可解释特征,提供预测的解释。这些解释通过SHAP值来表达,SHAP值是通过在代理模型上应用TreeSHAP算法得到的,代理模型学习了从可解释特征空间到黑盒模型预测的映射关系。此外,作者还对时间序列预测中的局部、半局部和全局解释概念进行了形式化定义,这些定义在多种应用场景中都具有重要价值。通过在多个数据集上的广泛实验,验证了TsSHAP算法的有效性和稳健性。

大家可以关注我【科学最top】,第一时间follow时序高水平论文解读!!!

原文地址:https://blog.csdn.net/u010681011/article/details/143807847

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!