2024年了,视频生成模型离通用世界模拟器还有多大差距?SOTA模型全面评估

文章链接: https://arxiv.org/pdf/2410.05363

项目链接: https://phygenbench123.github.io/

数据&代码:https://github.com/OpenGVLab/PhyGenBench

亮点直击

- 提出了 PhyGenBench,它涵盖了广泛的明确物理现象和明确的物理定律。该基准可以全面衡量 T2V 模型是否理解直观物理学,并间接评估它们与世界模拟器能力之间的差距。

- 提出了一个自动化评估框架 PhyGenEval,克服了使用其他指标评估物理常识正确性的问题,并且在 PhyGenBench 上表现出与人类反馈高度一致的效果,使用户能够对各种 T2V 模型进行大规模自动化测试。

- 对流行的 T2V 模型进行了广泛评估,甚至表现最好的模型 Gen-3 仅得分0.51。这表明当前的模型离成为世界模拟器的目标还有很大差距。根据评估结果,进行了深入分析,发现解决诸如动态等问题通过提示工程或简单地扩大模型规模仍然具有挑战性。

总结速览

解决的问题: 当前的文本生成视频(T2V)模型在可视化复杂提示词方面取得了显著进展,但在直观物理学的准确表示能力上仍缺乏深入探索,限制了其成为通用世界模拟器的潜力。

提出的方案: 为了弥补这一不足,本文提出了一个名为 PhyGenBench 的物理生成基准,用于评估T2V生成中物理常识的正确性。该基准包含160个精心设计的提示,涵盖27个不同的物理定律,跨越四大基本领域,全面评估模型对物理常识的理解。

应用的技术: 本文还提出了一个新颖的评估框架 PhyGenEval,采用层次化评估结构,结合先进的视觉-语言模型和大语言模型,对物理常识进行评估,从而实现大规模自动化评估。

达到的效果: 通过 PhyGenBench 和 PhyGenEval,研究结果表明现有模型在生成符合物理常识的视频方面存在挑战,简单地扩大模型规模或使用提示工程技术无法完全解决这些问题。希望这项研究能够激励社区在模型开发中优先考虑物理常识的学习。

动机

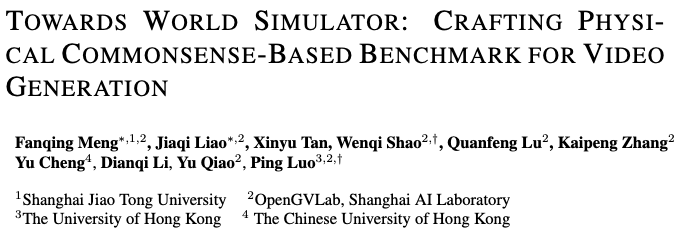

认知心理学家认为实现世界模拟器的重要一步是使得模型具备intuitive physics概念,这是一个即使是人类婴儿都会具有的直觉,其不需要依赖准确的物理定律表达式,而是依赖人类自身的感受进行判断。然而我们发现经过大量资源进行训练的video generation model,即使是最先进的模型(比如Kling,Gen-3),也几乎不具备这种intuitive physics,凸显了其与world simualtor的巨大距离。

目前的video generation benchmark大多忽视了对于这一点的evaluation以及analysis,所以我们提出PhyGenBench以及PhyGenEval,进行自动化的模型evaluation。

PhyGenBench

受 (Swartz, 1985) 的启发,首先定义以下术语:“物理常识”:对日常生活中物体和动作行为的基本直观理解;“物理定律”:描述自然中一致行为的普遍科学原则;“物理现象”:由物理定律的相互作用引起的可观察事件或过程。PhyGenBench 的目的是评估 T2V 模型是否理解物理常识,而 PhyGenBench 中的每个提示都展示了一个明确的物理现象及其背后的物理定律。

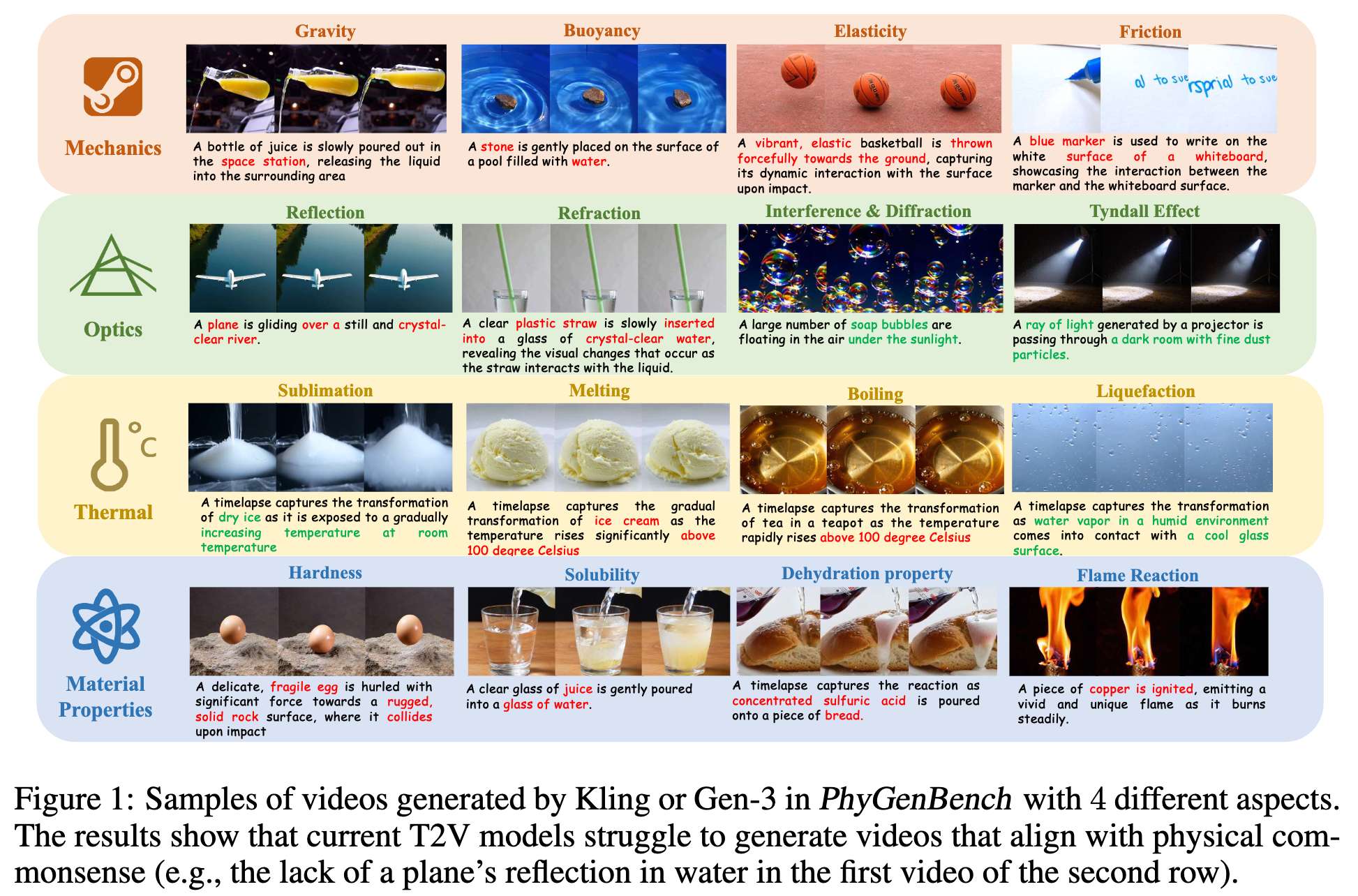

概述。 如下图 2(a) 所示,PhyGenBench 包含四个主要类别的物理常识:“力学”、“光学”、“热学”和“物质性质”。它涵盖了 27 个物理现象,并通过相应设计的 160 个提示反映了内在的物理定律:

-

“力学”涵盖了 7 个常见的机械定律:重力、浮力、固体压力、大气压力、弹性、摩擦力和表面张力,共有 40 个验证提示。例如,我们使用“将一块铁轻轻放在盛满水的水箱表面”来测试 T2V 模型对浮力的理解,其中铁由于其比水密度更高而应下沉。

-

“光学”根据光现象分为 6 个方面:反射、折射、散射、色散、干涉和衍射以及直线传播,共产生 50 个提示。像“风筝在光滑宁静的池塘上空翱翔”这样的提示用于测试反射生成能力。

-

“热学”考虑了 6 种相变:凝固、熔化、液化、沸腾、沉积和升华,共 30 个提示。受 ChronoMagicBench启发,沸腾过程通过提示“水在温度迅速上升至100°C以上时的变换时间推移”进行评估。

-

“物质性质”包括 5 个物理性质(颜色、硬度、溶解性、可燃性和火焰反应)和 3 个化学性质(酸性、氧化还原电位和脱水性),产生了 40 个提示。通过现象反映物质性质,例如,“硬度”通过“一个鸡蛋以巨大力量被投向一块岩石”的提示表现出来,鸡蛋应该碎裂,而岩石保持完整。

一个提示中可能包含多个物理定律,这甚至会使人类标注者在评估视频生成中的物理常识时感到困惑。为避免这种情况,我们精心策划了提示,以确保每个提示仅反映一个物理现象,并包含明确的物理定律。通过结合四个不同物理类别中的物理定律,PhyGenBench 提供了对当前 T2V 模型物理常识理解的全面评估。

基准构建。 如前面图 2(b) 所示,我们开发了一个综合方法来创建 PhyGenBench。该方法包括五个步骤:

- 概念化:根据 (Halliday et al., 2013),我们首先从物理学的四个主要类别中确定关键的物理常识。对于每个类别,我们从教科书 (Harjono et al., 2020) 中选择具体的物理定律,这些定律广为人知,且可以通过清晰、可观察的物理现象轻松演示。

- 提示工程:对于每个物理定律,我们手动设计了初始的 T2V 提示,清晰描述了其背后的物理现象。

- 提示增强:为了增强模型的视频生成能力,我们通过增加更多的物体和动作描述对初始 T2V 提示进行增强 (Yang et al., 2024)。该增强过程经过精心设计,以避免透露预期的物理现象。

- 多样性提升:根据 T2V-CompBench (Sun et al., 2024),我们使用 GPT-4o 对增强的提示进行物体替换。此步骤提高了基准的多样性。

- 质量控制:对提示及其相关的物理定律进行了全面审查,以确保准确性和相关性。特别是,确保 T2V 提示及其对应的物理定律清晰准确。

随后,随机使用当前的 T2V 模型检查提示是否足够简单,以便模型生成语义准确的视频。这一方法生成了一个稳健且全面的基准,用于评估 T2V 模型对物理常识的理解,为推动该领域的研究提供了宝贵工具。

PhyGenEval

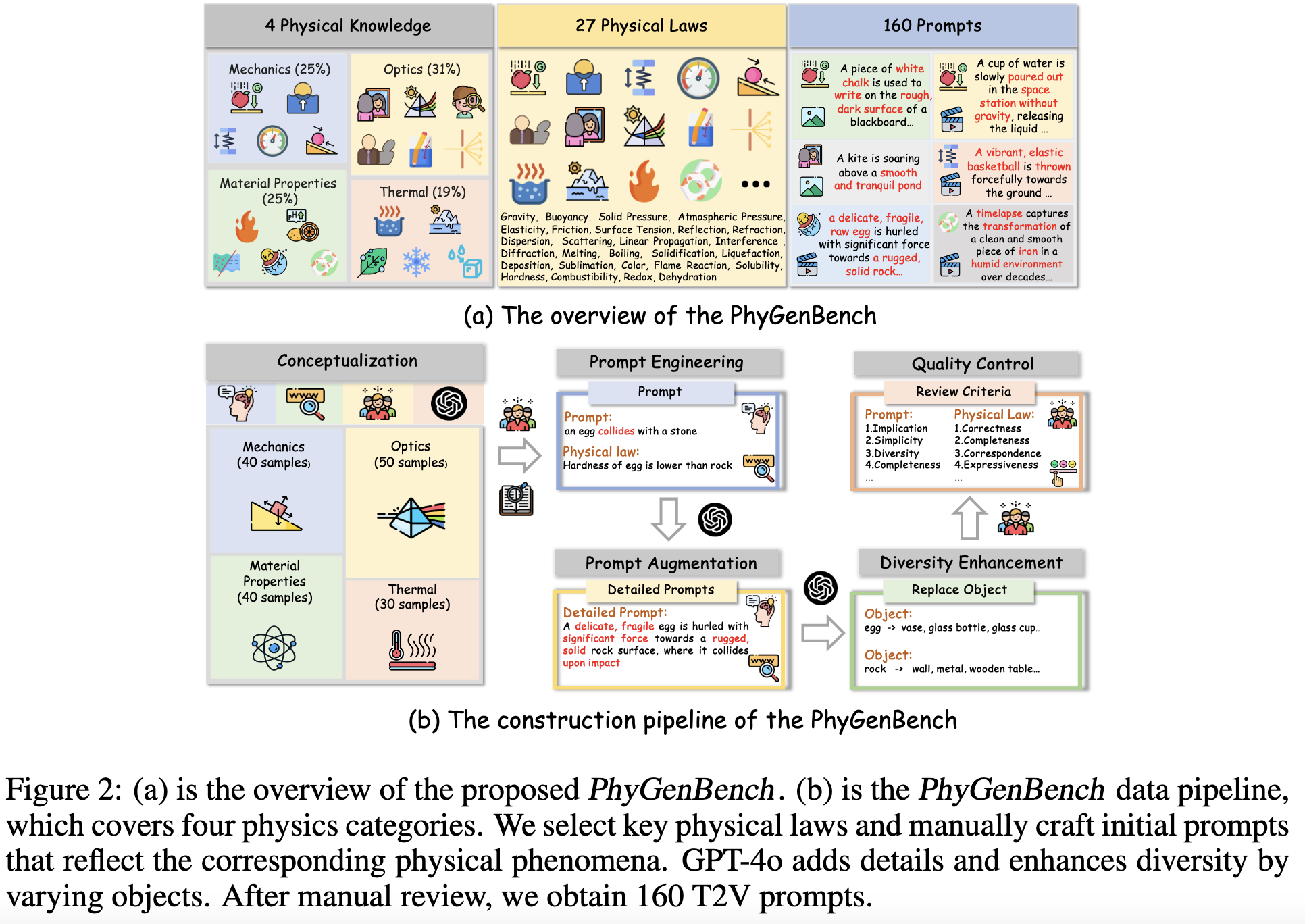

PhyGenEval 旨在评估生成视频中的物理现象是否符合相应的物理定律。为了获得明确的判断,评估被分为语义对齐(SA)和物理常识对齐(PCA)。SA 评估生成视频与输入提示之间的语义含义是否匹配,而 PCA 则衡量视频中的物理定律是否得到了体现。例如,对于“鸡蛋与石头碰撞”这一场景,SA 需要视频中包含鸡蛋、石头和碰撞动作。PCA 则要求视频展现完整的物理过程,即鸡蛋撞上石头并破裂,而石头保持完好。根据 (He et al., 2024b),我们将 SA 和 PCA 都转换为四分制评分,以及人工评分。

语义对齐评估

直接使用视觉语言模型(VLM)来对齐视频与输入提示的语义含义比较困难,因为提示通常混合了语义实体和物理现象,视频中的中间结果往往被隐含。例如,对于提示“一个延时摄影记录了汤温度上升超过100°C的转变”,可能生成的视频是“视频显示了一碗汤,但汤没有发生任何转变”。为了解决这一挑战,我们首先使用 GPT-4o 从原始文本提示中提取对象和动作,然后利用 GPT-4o 依次判断视频中是否出现了提取的对象,并验证指定动作的发生。此分解方法可以更细致地捕捉信息,防止模型在评估过程中混淆语义和物理正确性。实验结果表明,我们的自动评估方法与人类判断更为一致,并且在 PhyGenBench 上优于之前的方法 (He et al., 2024b; Sun et al., 2024)

物理常识评估

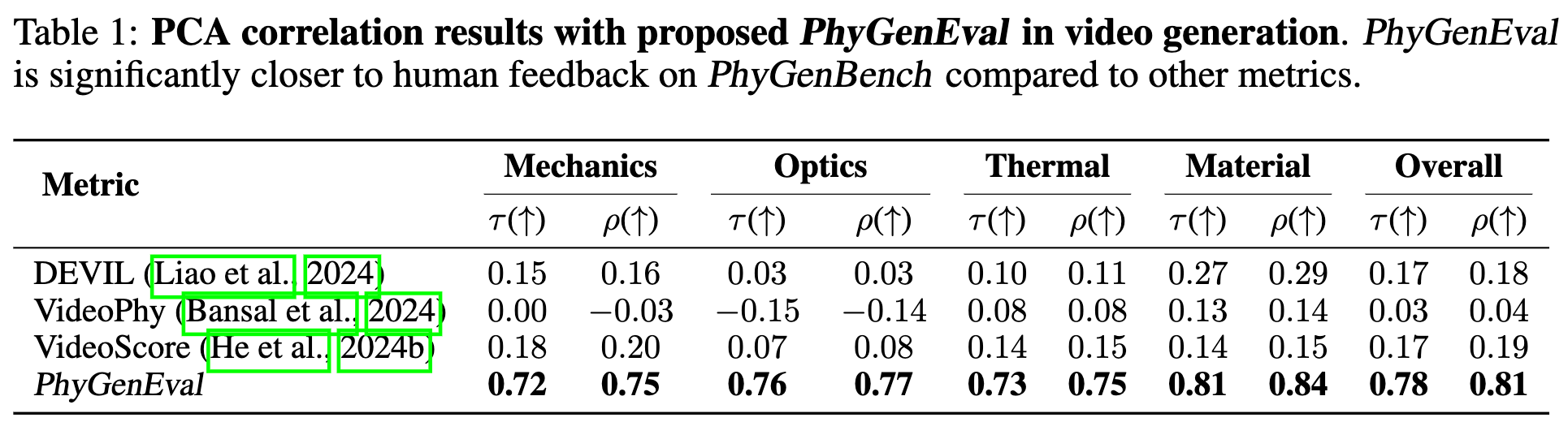

为了评估视频中的物理正确性,我们比较了多个常见评估指标与人工评估的结果。表1的实验结果显示,这些方法在 PhyGenBench 上难以推广到物理常识正确性的评估,例如 VideoScore在 PhyGenBench 上的斯皮尔曼相关系数只有0.19,尽管这是除 PhyGenEval 之外与人工评估最相关的方法。其主要原因是:直接使用基于视频的 VLM 无法理解视频中的物理常识 ,因为现有方法并不是以物理常识为基础设计的。

为了全面理解视频中的物理常识,需要解决以下三个关键问题:

- 关键物理现象:物理过程通常表现出清晰的关键现象,如“鸡蛋撞击岩石后破裂”。必须识别这些关键物理现象并检测它们在视频中的出现。

- 因果关系与事件顺序:物理过程具有因果关系,表现在关键事件的正确顺序中,如“鸡蛋先碰到石头,然后破裂”。正确的事件顺序验证了物理过程的正确性。

- 整体自然性:物理过程需要具备整体的自然性,反映过程的真实性。

为了解决这些问题,PhyGenEval 设计了一种渐进策略,首先检测关键物理现象,然后验证多个关键现象的顺序,最后评估整个视频过程的自然性。这种层次化、精细化的方法比现有直接使用 VLM 评估物理常识的方法更为有效,使得 PhyGenEval 能够实现与人工评估更为接近的结果。

关键物理现象检测

此阶段的目标是检测视频中是否出现了关键物理现象。我们将关键现象定义为物理过程中可观察且显著的发生事件(例如,特定帧),能够直接揭示相应的物理定律,如变形或颜色变化。对于 PhyGenBench 中的每个输入提示,我们设计了一个检索提示 p r pr pr 和一组物理相关问题 Q Q Q,其中检索提示用于定位关键现象帧,物理相关问题则用于检查关键帧中是否存在预期的物理现象。

如下图 3 (a) 所示,首先通过将输入的 T2V 提示和对应的物理定律输入 GPT-4o 来获得 Q Q Q 和 P r Pr Pr。

然后,依据检索提示在视频中定位关键帧 I i I_i Ii,其中 I i I_i Ii 是视频中的第 i i i 帧。通过使用关键帧,我们定义了视频中关键现象的置信度评分。

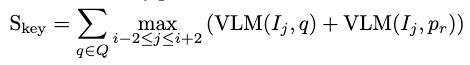

物理现象检测公式解释

在此阶段中,公式 V L M ( I j , q ) VLM(I_j ,q) VLM(Ij,q) 表示对于问题 q q q,视频帧 I j I_j Ij 是否反映了物理现象的存在。而 V L M ( I j , p r ) VLM(I_j ,pr) VLM(Ij,pr) 则用于检查视频帧 I j I_j Ij 是否与检索提示相匹配,以确保关键现象出现在正确的帧中。由于视频可能包含语义错误,确定关键物理现象的出现也是至关重要的(例如,鸡蛋不应在撞击石头前就破裂)。考虑关键帧附近的5个相邻帧来增强鲁棒性。例如,鸡蛋可能不会在首次接触石头时立即破裂。使用基于 VQAScore的评估器来实例化 V L M ( ⋅ ) VLM(·) VLM(⋅),其在视觉问答的评估中已经表现出良好的效果。

物理顺序验证

在这一阶段,验证关键物理现象是否按正确的顺序发生。正确的物理顺序是物理过程中反映因果关系的有序事件序列,它代表了关键物理现象的必要前提和时间顺序。例如,鸡蛋应先接触石头,然后破裂。考虑到 PhyGenBench 中的当前模型通常保持结果一致性(如:鸡蛋破裂后不会重新组装),通过关键帧来研究顺序正确性(如前面图3(b)所示),例如,鸡蛋撞击石头的关键帧应在破裂的关键帧之前。

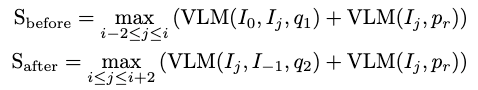

类似于单帧图像的评估,提示 GPT-4o 生成检索提示 p r pr pr 和三个物理相关问题 ( q 1 q_1 q1, q 2 q_2 q2, q 3 q_3 q3)。 p r pr pr 用于定位关键帧(例如鸡蛋轻微接触石头的瞬间)。 q 1 q_1 q1, q 2 q_2 q2 和 q 3 q_3 q3 则用于从第一帧到关键帧、从关键帧到最后一帧以及从第一帧到最后一帧分别检查顺序的正确性。类似地,首先使用 CLIPScore 来定位关键帧 I i I_i Ii,然后定义顺序正确性得分 S b e f o r e S_{before} Sbefore 和 S a f t e r S_{after} Safter 如下:

整体物理顺序评估公式

在此阶段, q 3 q_3 q3 评估视频的整体物理序列一致性。回答 q 3 q_3 q3 的得分定义为:

S a l l = V L M ( I 0 , I i − 2 : i + 2 , I − 1 , q 3 ) S_{all} = VLM(I_0,I_{i-2:i+2},I_{-1},q_3) Sall=VLM(I0,Ii−2:i+2,I−1,q3)

该公式评估整体序列(与输入视频相似,但使用手动选择的关键帧)。在此,我们采用 GPT-4o 或 LLaVA-Interleave (Li et al., 2024) 作为基于 VLM 的评估器 V L M ( ⋅ ) VLM(·) VLM(⋅),因为它们表现出卓越的多图像理解能力。整个物理顺序评估的总体得分可以表示为:

S o r d e r = S b e f o r e + S a f t e r + S a l l S_{order} = S_{before} + S_{after} + S_{all} Sorder=Sbefore+Safter+Sall

整体自然性评估

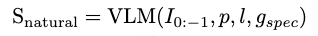

该阶段旨在评估视频的整体自然性。将自然性定义为与现实世界物理现象一致的动态进程。对于 PhyGenBench 中的每个提示,我们获得一个自然性评估标准,记作 g s p e c g_{spec} gspec,用于评估视频的自然性。如前面图 3© 所示,我们首先参考 DEVIL来建立一个通用评估标准 g g e n g_{gen} ggen,适用于所有 T2V 提示。此外,使用每个输入的 T2V 提示 p p p、相应的物理定律 l l l 和通用评估标准 g g e n g_{gen} ggen 来指导 GPT-4o 为给定提示生成详细的评估标准 g s p e c g_{spec} gspec。最后,我们要求 VLM 根据 p p p、 l l l、 g s p e c g_{spec} gspec 和相应的视频 I 0 : − 1 I_{0:−1} I0:−1 进行评分。正式定义整体自然性得分为:

整体得分

首先将来自三个阶段的得分 S k e y S_{key} Skey、 S o r d e r S_{order} Sorder 和 S n a t u r a l S_{natural} Snatural 离散化为四点制评分,然后取它们的平均值并进行向下取整,以得出最终得分。为了保证评估的鲁棒性,我们使用 GPT-4o 和 LLaVA-Interleave 分别评估 S o r d e r S_{order} Sorder,使用 GPT-4o 和 InternVideo2 评估 S n a t u r a l S_{natural} Snatural。最终得分通过这两种方法的集成计算得出。详细的计算协议见附录 B。

实验设置

评估了包括 OpenSora V1.2、Lavie、CogVideoX 2b、CogVideoX 5b 和 Vchitect2.0 在内的 5 个开源模型,以及专有模型 Kling 、Pika 和 Gen-3 。将提出的指标与现有的指标或基准进行比较:Videophy、VideoScore和 DEVIL。

人工评估

如下表 1 所示,当前的视频生成评估指标在很大程度上忽视了物理正确性。相比之下,PhyGenEval 实现了一个详细的设计用于评估物理正确性,展现出与人类判断的强相关性。在所有类别中,其总体相关系数达到 0.81,表明 PhyGenEval 作为 PhyGenBench 的一个有效的人类对齐的物理常识正确性评估器。

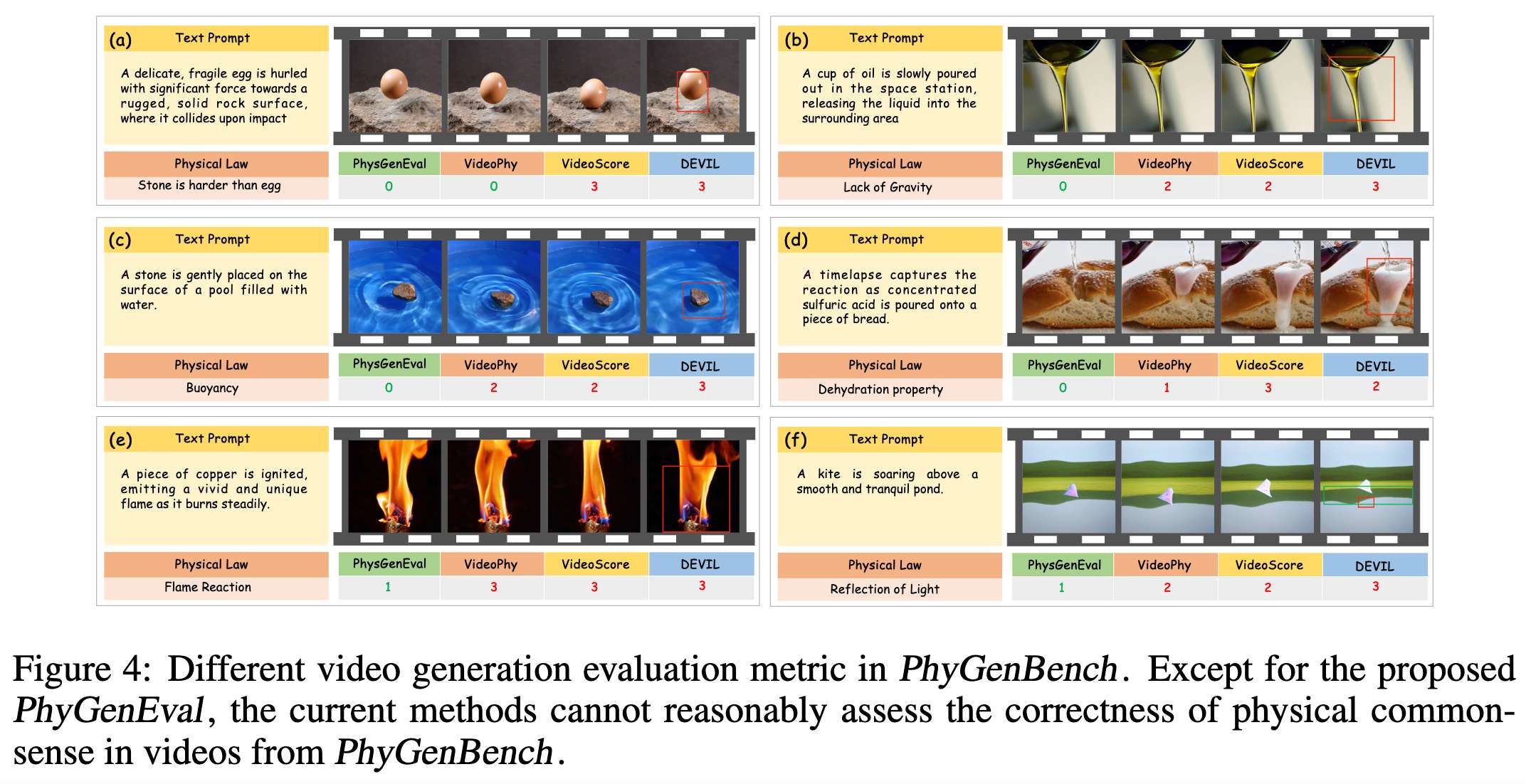

本文进行了一些案例研究,以更清楚地说明各种指标之间的差异。如下图 4 所示,(a) 和 (f) 表明 VideoScore 和 DEVIL 倾向于错误分类那些运动平滑且一致但违反基本物理定律的视频。例如,在 (a) 中,当“一个鸡蛋在撞击岩石时表现出橡胶般的弹性而不是破裂”时,这些指标错误地将其评估为物理正确。VideoPhy 展示了类似的局限性。在 © 中,它错误地评估“岩石漂浮在水面上而不是下沉”为物理正确。此外,我们的分析揭示了这三种方法的一个主要缺陷:它们无法纳入领域特定的物理常识。如 (e) 所示,“燃烧铜的火焰呈红色而不是绿色”,这些指标未能识别出这个错误。这表明它们无法结合领域特定的物理常识。相比之下,PhyGenEval 展示了对物理常识的稳健整合和全面的视频内容分析,从而在 PhyGenBench 中实现了更准确且物理一致的评估。

定量评估

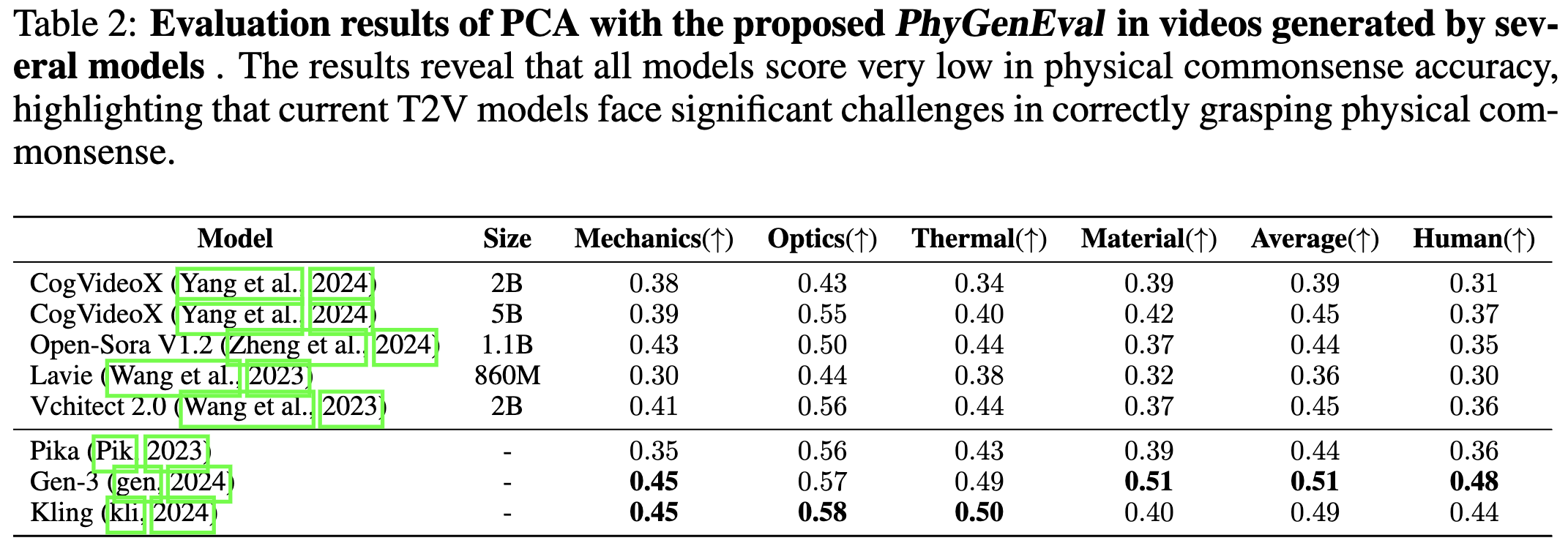

对多种流行的视频生成模型进行了广泛的实验。如下表 2 所示,即使是表现最好的模型 Gen-3,在 PhyGenBench 上的 PCA 得分也仅为 0.51。这表明,即使对于包含明显物理常识的提示,当前的 T2V 模型仍然难以生成符合直观物理规律的视频。这间接反映出这些模型距离实现世界模拟器的目标仍然相去甚远。此外,还发现以下关键观察:

-

光学领域的表现优异:在各种物理常识类别中,所有模型在光学领域的表现始终优于其他领域。特别是 Vchitect2.0 和 CogVideoX-5b 在光学领域的 PCA 得分与闭源模型相当。我们认为,在光学领域的优异表现可以归因于预训练数据集中对光学知识的丰富且明确的表征,从而增强了模型在该领域的理解。

-

Kling 和 Gen-3 的优势:Kling 和 Gen-3 显示出显著高于其他模型的性能。具体而言,Gen-3 对物质性质的理解非常扎实,取得了 0.51 的得分,显著超越其他模型。而 Kling 在热学方面表现尤为突出,在该领域达到了最高的 0.50 分。

-

开源模型的比较:在开源模型中,Vchitect2.0 和 CogVideoX 5b 的表现相对较好,均超过了 Pika 的性能。相比之下,Lavie 在所有类别中的物理正确性始终较低。

定性评估

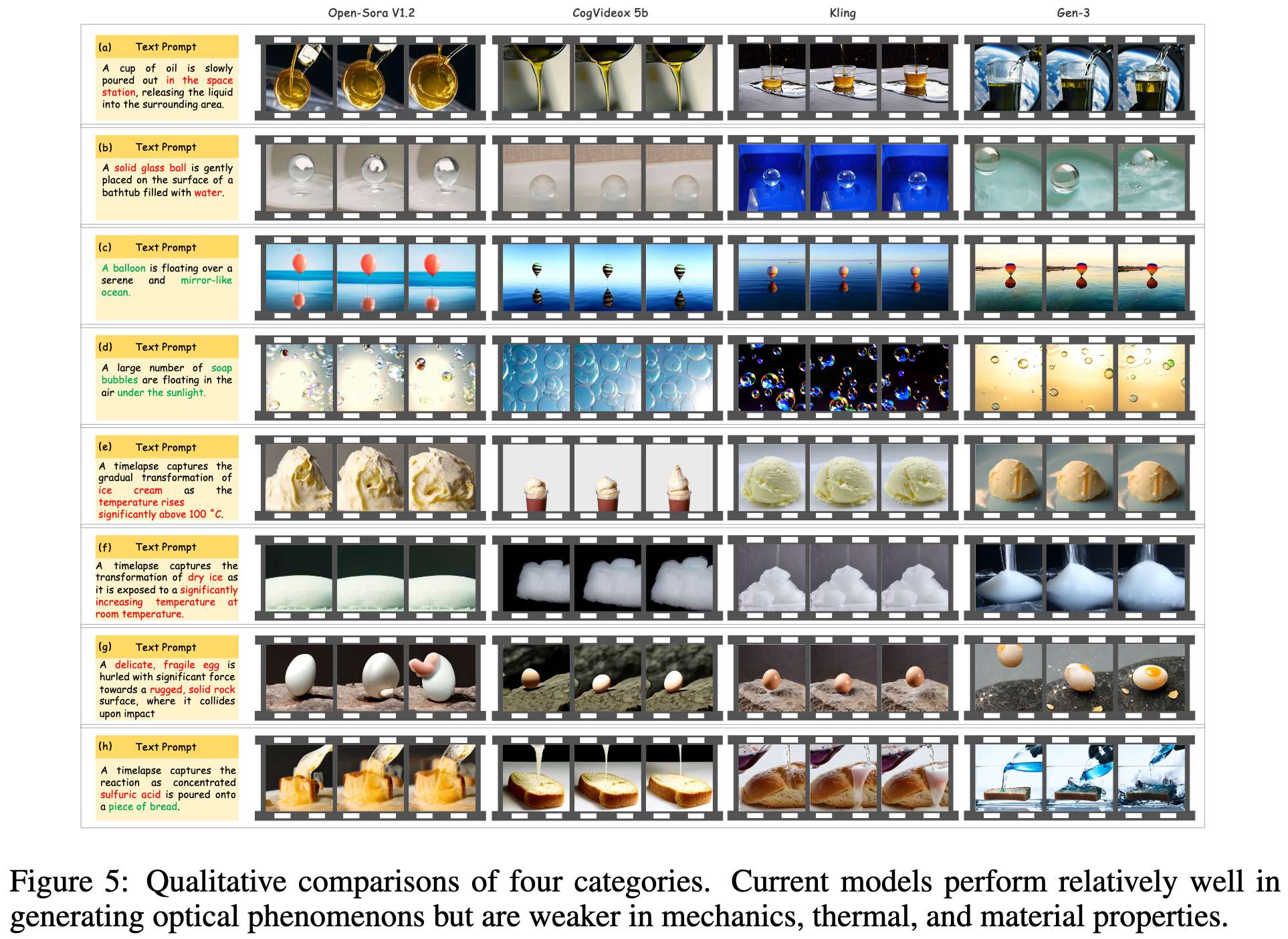

在下图 5 中展示了 4 个物理常识类别的不同视频案例。主要观察如下:

-

力学:模型在生成简单的物理准确现象时表现不佳。如图 5 所示,所有模型未能描绘出玻璃球沉入水中的场景。在 (b) 中,模型反而显示球漂浮在水面上,OpenSora 和 Gen-3 甚至生成了球悬浮的动画。此外,模型未能捕捉到特定物理现象,例如零重力状态下的水,如 (a) 所示。

-

光学:模型在光学方面的表现相对较好。© 和 (d) 显示模型处理水中气球的反射和五彩泡泡,尽管 OpenSora 和 CogVideoX 仍在 (d) 中产生了明显失真的反射。

-

热学:模型在生成相变视频方面表现不佳。在 (e) 中的熔化现象,大多数模型的结果不正确,CogVideoX 甚至生成了冰淇淋变大的视频。在 (f) 中,升华过程也出现类似错误,只有 Gen-3 显示出部分理解。

-

物质性质:在 (g) 中,所有模型未能识别出鸡蛋撞击岩石时应该破裂的事实,Kling 显示鸡蛋像橡皮球一样反弹。对于简单的化学反应,例如在 (h) 中的黑面包实验,模型没有展现出对预期反应的准确理解。

消融研究

对 PhyGenEval 中设计元素的稳健性进行了详细分析,包括三层评估框架中每个层级的作用,以及在整体自然性评估中提出的两阶段策略的影响。实验结果显示,PhyGenEval 的关键设计是必不可少的。

讨论

本节讨论了模型在物理常识评估中的表现差异及其原因,强调了未来模型在物理理解和生成能力上的提升空间。同时,通过对评估框架的消融研究,验证了各组成部分在提升评估精度和可靠性方面的重要性。

讨论了一些常用手段是否可以解决PhyGenBench中所提出的问题,具体来说,讨论了Prompt Engineer(使用GPT rewrite prompt),Scaling Law,以及提高video general quality是否可以解决PhyGenBench中的问题(具体来说,提高VBench上的表现和PhyGenBench的关系)。

我们发现:

- 扩展模型规模可以解决一些问题,但仍难以处理动力学物理现象,我们认为这需要在大量合成数据上进行广泛的训练。(参考[PhysGen])

- 提示工程只能解决一些简单的问题(例如火焰颜色),这凸显了PhyGenBench的难度和重要性。

- 尽管某些方法(Venhancer)可以提高视频的整体质量,但它们并未增强模型对物理常识的理解。

结论

本文探讨了当前 T2V 模型对物理常识理解与其作为世界模拟器的角色之间的差距。为此,我们引入了 PhyGenBench 和 PhyGenEval。PhyGenBench 是一个专门设计的基准,旨在评估模型对物理常识的理解,涵盖各种物理定律和简单、清晰的物理现象。与 PhyGenBench 一起,提出了一种新的三层层级评估框架,称为 PhyGenEval,以自动化评估过程。实验和分析结果表明,当前的 T2V 模型在生成与物理常识一致的视频方面面临挑战,凸显出与世界模拟之间的显著差距。此外,单纯扩大模型规模或应用提示工程无法解决 PhyGenBench 中的问题,特别是涉及动态物理现象的挑战。

未来的工作

我们的研究表明,尽管一些方法可以提高模型的表现,但要解决物理常识的理解问题,仍需要更深入的研究。未来的工作可以集中在以下几个方向:

-

数据增强和合成:对模型进行广泛的合成数据训练,特别是动态物理现象,以增强模型的物理理解能力。

-

更复杂的提示工程:开发更复杂的提示工程技术,旨在解决涉及多种物理现象的复杂问题。

-

跨学科的合作:结合计算机科学和物理学的专业知识,开发能够更好模拟物理规律的模型和算法。

-

基准的扩展:扩展 PhyGenBench,加入更多复杂的物理现象和应用场景,以全面评估模型的物理理解能力。

通过这些努力,希望能够缩小当前 T2V 模型在物理常识理解方面的差距,并推动其朝着更高水平的世界模拟器迈进。

参考文献

[1] Towards World Simulator: Crafting Physical Commonsense-Based Benchmark for Video Generation

原文地址:https://blog.csdn.net/AIGCer/article/details/143029789

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!