3DSBDD中的Context Encoder、Spatial Classifier是怎么实现的?

Context Encoder:

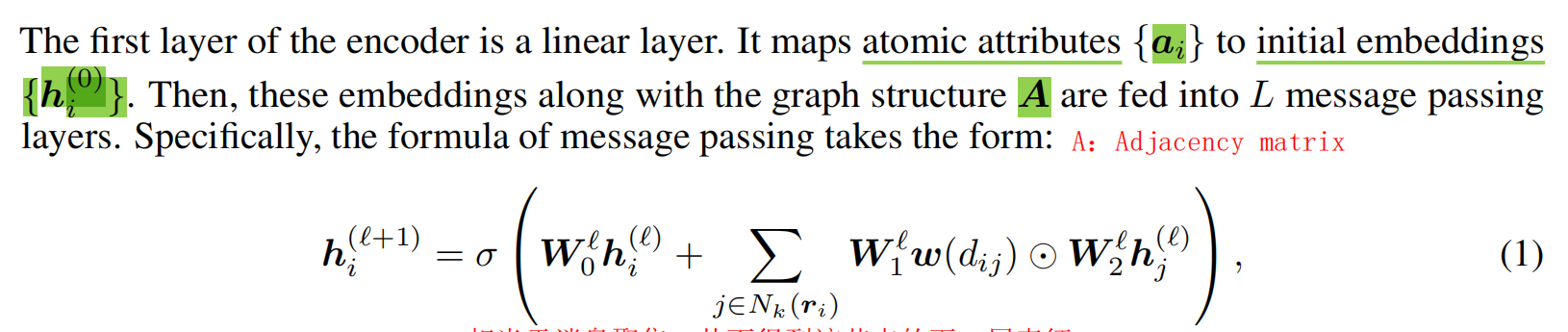

这是MPNN中每个原子怎么得到context信息的过程,它和GCN的计算基本一致:将自己的信息 + 周围节点的信息 * 权重w(dij)

在上面的公式中:

即通过学习边的权重(这里是通过 w(dij) 函数体现的)和聚合邻居节点的信息来更新每个节点的嵌入。这个过程反复迭代,从而在每个节点的嵌入中编码其在图中的结构位置和邻域的信息。

Context Encoder:

-

第一步是使用线性层将原子属性ai 映射到初始嵌入 {hi(0)}。这一步是将原子的特性(如原子类型、电荷等)转换为数值向量形式,以便能够进行数学处理。

-

第二步是将这些嵌入通过 L 次消息传递层处理,生成新的嵌入。公式 (1) 显示了消息传递的具体计算方式,它通过整合节点 i 的邻居节点 j 的信息来更新节点 i 的嵌入。 w(dij) 是一个权重网络,它根据节点间的距离来计算消息的权重,确保了消息的权重对旋转和平移是不变的,这对于化学结构来说是非常重要的,因为化学性质通常与分子的绝对位置无关。

Spatial Classifier:

Spatial Classifier:

-

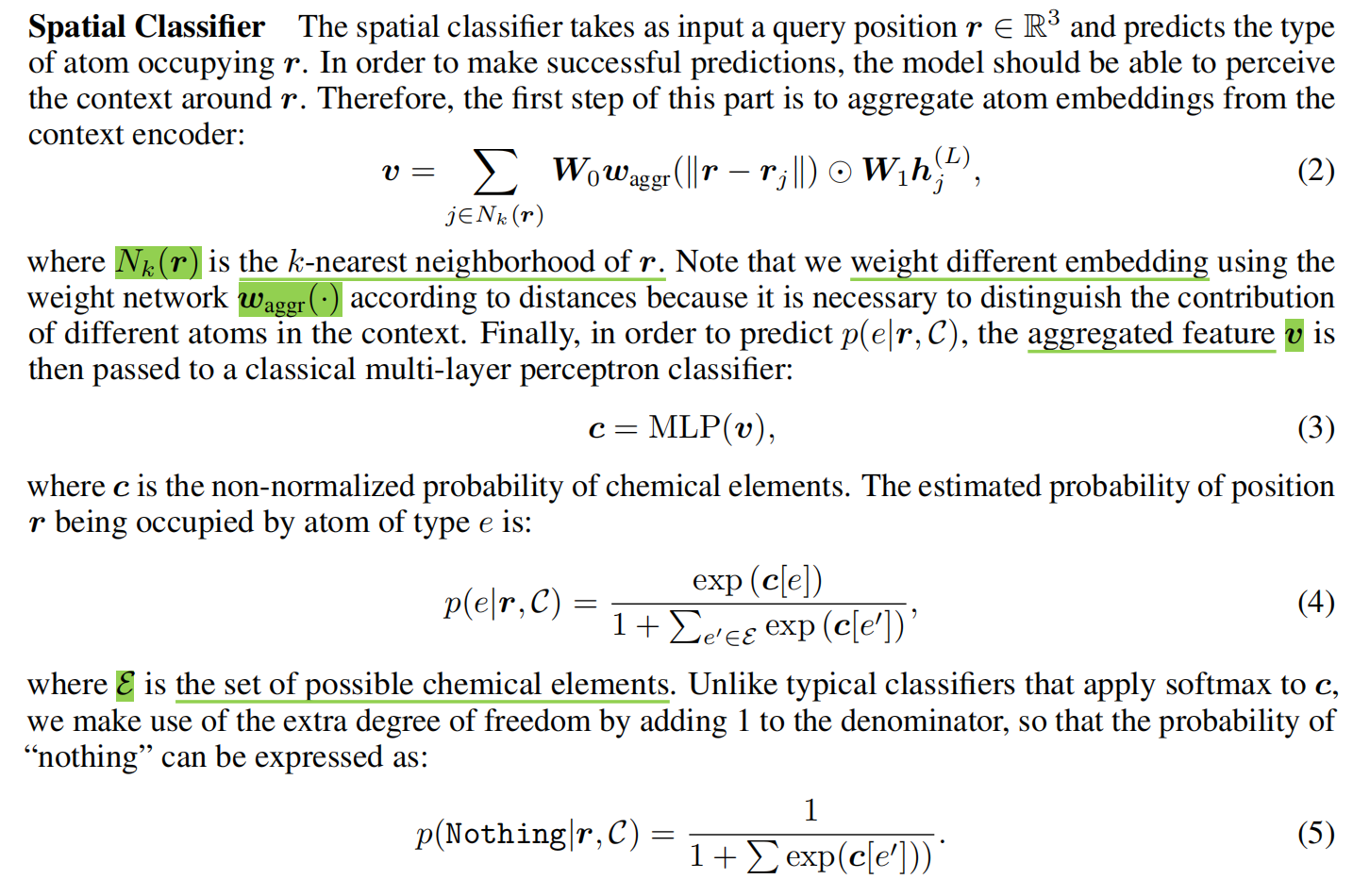

第2步是聚合目标位置 r 的 k-最近邻原子嵌入,得到特征向量 v,如公式 (2) 所示。这一步是为了捕捉目标位置周围的上下文信息,这对于预测 r 被某种类型的原子占据的概率至关重要。

-

第3步是将聚合的特征 v 传递给一个多层感知器(MLP)分类器,得到化学元素的非归一化概率 c,如公式 (3) 所示。多层感知器在这里充当一个分类器,将聚合特征映射为概率分布。

-

第4步是应用softmax激活函数来计算具体元素 e 占据位置 r 的概率,如公式 (4) 所示。这一步将非归一化的分数转换为概率,使得所有可能的化学元素的概率总和为1。

-

第5步是计算“无元素”占据位置 r 的概率,如公式 (5) 所示。这一步为模型增加了一个额外的自由度,允许模型预测某个位置没有被任何原子占据的概率。

【NeurIPS 2021】3DSBDD + A 3D Generative Model for Structure-Based Drug Design

原文地址:https://blog.csdn.net/weixin_43135178/article/details/135916118

免责声明:本站文章内容转载自网络资源,如本站内容侵犯了原著者的合法权益,可联系本站删除。更多内容请关注自学内容网(zxcms.com)!